Treffen Sie Führungskräfte am 27. März in Boston zu einem exklusiven Abend voller Networking, Einblicke und Gespräche. Fordern Sie hier eine Einladung an.

Der beliebte KI-Bildgenerierungsdienst Midjourney hat eine seiner am häufigsten nachgefragten Funktionen implementiert: die Möglichkeit, Charaktere in neuen Bildern konsistent neu zu erstellen.

Dies war bisher naturgemäß eine große Hürde für KI-Bildgeneratoren.

Das liegt daran, dass die meisten KI-Bildgeneratoren auf „Diffusionsmodellen“ basieren, Tools, die dem Open-Source-Bildgenerierungsalgorithmus „Stable Diffusion“ von Stability AI ähneln oder darauf basieren -Pixel, das dieser Beschreibung entspricht, wie aus ähnlichen Bild- und Text-Tags in ihrem riesigen (und umstrittenen) Trainingsdatensatz aus Millionen von Menschen erstellten Bildern gelernt wurde.

Warum konsistente Charaktere für generative KI-Bilder so mächtig – und schwer fassbar – sind

Doch wie bei textbasierten Large Language Models (LLMs) wie ChatGPT von OpenAI oder Coheres neuem Command-R liegt das Problem bei allen generativen KI-Anwendungen in der Inkonsistenz der Antworten: Die KI generiert für jede einzelne Eingabeaufforderung etwas Neues eingegeben werden, auch wenn die Eingabeaufforderung wiederholt wird oder einige der gleichen Schlüsselwörter verwendet werden.

VB-Ereignis

Die AI Impact Tour – Boston

Eine Einladung anfordern

Das ist großartig, um ganz neue Inhalte zu generieren – im Fall von Midjourney Bilder. Aber was ist, wenn Sie ein Storyboard für einen Film, einen Roman, eine Graphic Novel oder ein Comic oder ein anderes visuelles Medium erstellen, wo Sie möchten? das gleiche Soll sich ein Charakter oder mehrere Charaktere darin bewegen und in verschiedenen Szenen, Schauplätzen, mit unterschiedlichen Gesichtsausdrücken und Requisiten auftauchen?

Genau dieses Szenario, das normalerweise für die Kontinuität der Erzählung notwendig ist, war mit generativer KI bisher nur sehr schwer zu erreichen. Aber Midjourney wagt es jetzt und führt einen neuen Tag ein, „–cref“ (kurz für „Charakterreferenz“), den Benutzer am Ende ihrer Textaufforderungen im Midjourney Discord hinzufügen können und der versucht, das Gesicht des Charakters anzupassen Merkmale, Körpertyp und sogar Kleidung aus einer URL, die der Benutzer im Anschluss an das Tag einfügt.

Während die Funktion weiterentwickelt und verfeinert wird, könnte sie Midjourney von einem coolen Spielzeug oder einer Ideenquelle zu einem professionelleren Werkzeug weiterentwickeln.

So verwenden Sie die neue Midjourney-Funktion für konsistente Charaktere

Das Tag funktioniert am besten mit zuvor generierten Midjourney-Bildern. Der Arbeitsablauf für einen Benutzer würde beispielsweise darin bestehen, zunächst die URL eines zuvor generierten Charakters zu generieren oder abzurufen.

Beginnen wir ganz von vorn und sagen wir, dass wir mit dieser Aufforderung einen neuen Charakter generieren: „einen muskulösen, kahlköpfigen Mann mit einer Perle und einer Augenklappe.“

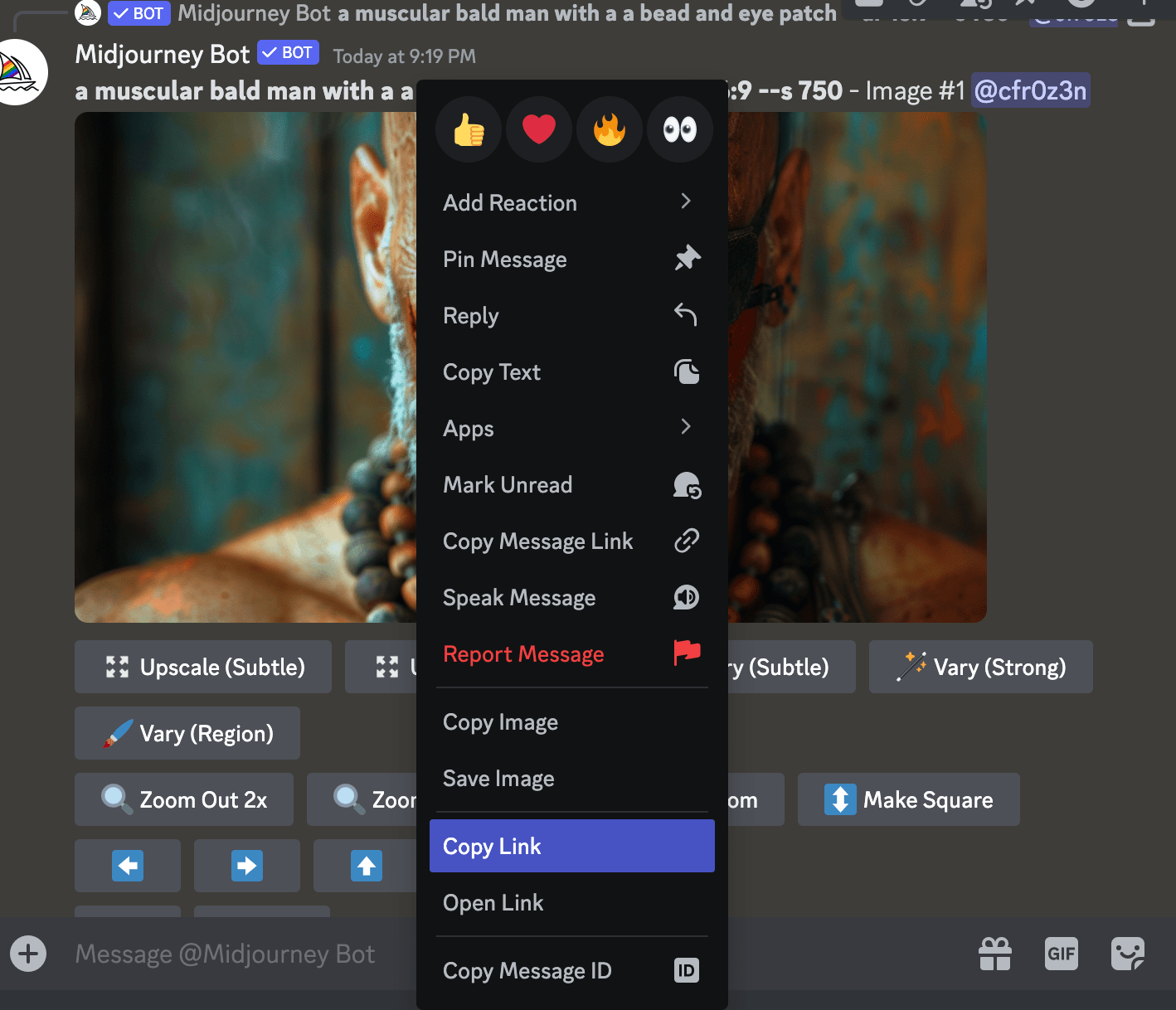

Wir skalieren das Bild, das uns am besten gefällt, hoch und klicken dann bei gedrückter Strg-Taste auf dem Midjourney-Discord-Server darauf, um die Option „Link kopieren“ zu finden.

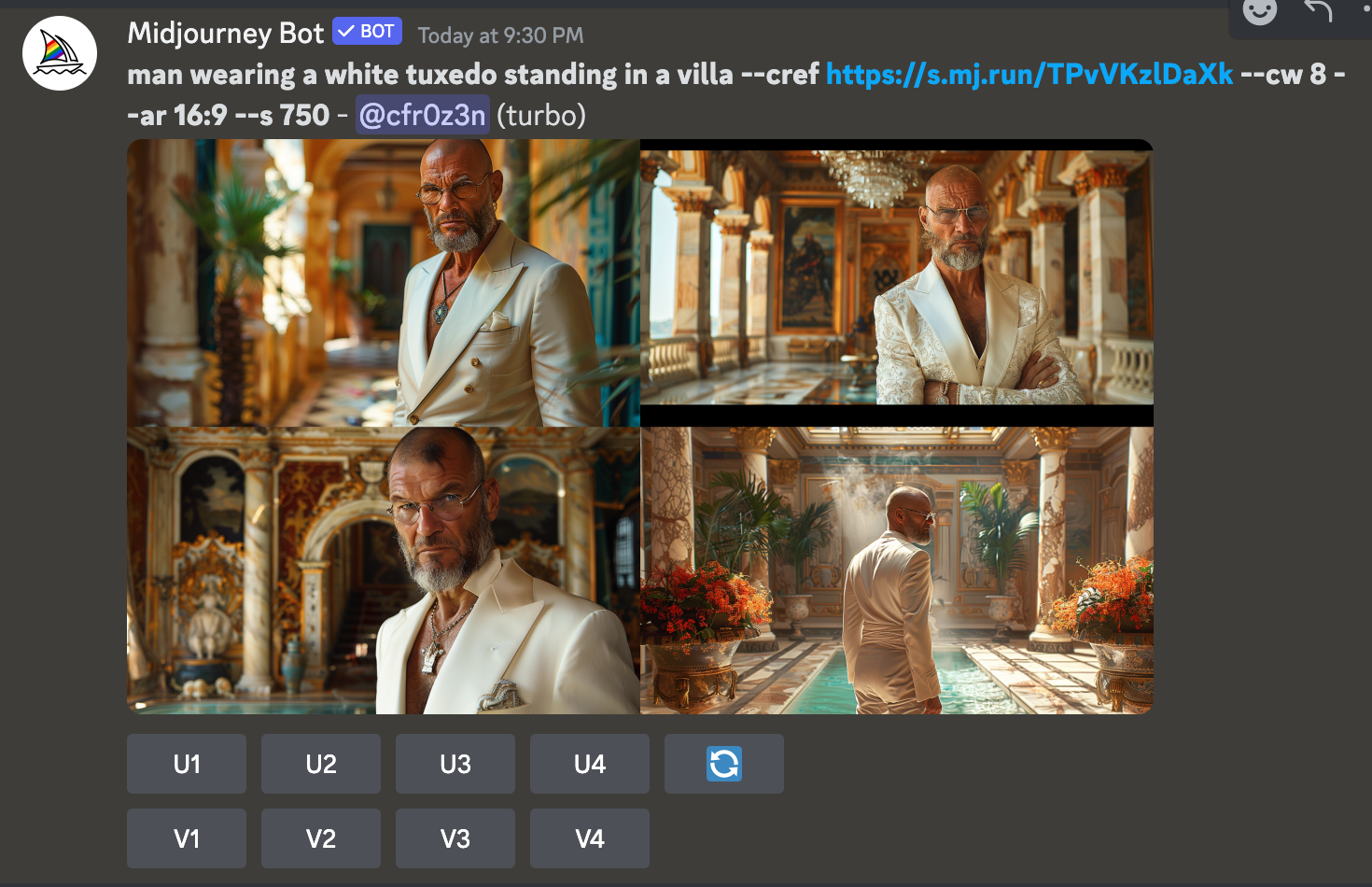

Dann können wir eine neue Eingabeaufforderung eingeben: „Trage einen weißen Smoking und stehe in einer Villa – cref.“ [URL]” und fügen Sie die URL des Bildes ein, das wir gerade generiert haben, und Midjourney wird versuchen, dasselbe Zeichen von zuvor in unserer neu eingegebenen Einstellung zu generieren.

Wie Sie sehen werden, entsprechen die Ergebnisse bei weitem nicht genau dem ursprünglichen Charakter (oder sogar unserer ursprünglichen Eingabeaufforderung), sind aber auf jeden Fall ermutigend.

Darüber hinaus kann der Benutzer bis zu einem gewissen Grad das „Gewicht“ steuern, wie genau das neue Bild das ursprüngliche Zeichen wiedergibt, indem er am Ende seiner neuen Eingabeaufforderung (nach dem „ –cref [URL]” Zeichenfolge, also etwa so: „–cref [URL] –KW 100.“ Je niedriger die „cw“-Zahl, desto mehr Varianz weist das resultierende Bild auf. Je höher die „cw“-Zahl, desto genauer folgt das resultierende neue Bild der Originalreferenz.

Wie Sie in unserem Beispiel sehen können, liefert die Eingabe eines sehr niedrigen Werts „cw 8“ tatsächlich das, was wir wollten: den weißen Smoking. Allerdings wurde jetzt die charakteristische Augenklappe unseres Charakters entfernt.

Na ja, es gibt nichts, was eine kleine „variable Region“ nicht reparieren kann – oder?

Ok, die Augenklappe ist also auf dem falschen Auge … aber wir kommen schon ans Ziel!

Sie können auch mehrere Zeichen zu einem kombinieren, indem Sie zwei „–cref“-Tags neben ihren jeweiligen URLs verwenden.

Das Feature ist erst heute Abend online gegangen, aber Künstler und YouTuber testen es bereits. Probieren Sie es selbst aus, wenn Sie Midjourney haben. Und lesen Sie unten die vollständige Notiz des Gründers David Holz dazu:

Hallo @alle @hier, wir testen heute eine neue „Charakterreferenz“-Funktion. Diese ähnelt der „Stilreferenz“-Funktion, außer dass statt eines Referenzstils versucht wird, das Zeichen mit einem „Zeichenreferenz“-Bild abzugleichen.

Wie es funktioniert

- Typ

--cref URLnach Ihrer Eingabeaufforderung mit einer URL zu einem Bild eines Charakters - Sie können verwenden

--cwum die Referenzstärke von 100 auf 0 zu ändern - Stärke 100 (

--cw 100) ist die Standardeinstellung und verwendet Gesicht, Haare und Kleidung - Bei Stärke 0 (

--cw 0) Es konzentriert sich nur auf das Gesicht (gut zum Wechseln von Outfits/Frisuren usw.)

Wofür es gedacht ist

- Diese Funktion funktioniert am besten, wenn Charaktere aus Midjourney-Bildern verwendet werden. Es ist nicht für echte Personen/Fotos konzipiert (und wird diese wahrscheinlich verzerren, wie es bei normalen Bildaufforderungen der Fall ist).

- Cref funktioniert ähnlich wie normale Bildaufforderungen, außer dass es sich auf die Charaktereigenschaften „konzentriert“.

- Die Präzision dieser Technik ist begrenzt, sie kopiert keine exakten Grübchen, Sommersprossen oder T-Shirt-Logos.

- Cref funktioniert sowohl für Niji- als auch für normale MJ-Modelle und kann auch mit kombiniert werden

--sref

Erweiterte Funktionen

- Sie können mehr als eine URL verwenden, um die Informationen/Zeichen aus mehreren Bildern wie diesem zu mischen

--cref URL1 URL2(Dies ähnelt den Eingabeaufforderungen für mehrere Bilder oder Stile.)

Wie funktioniert es in der Web-Alpha?

- Ziehen Sie ein Bild oder fügen Sie es in die Bildleiste ein. Es verfügt jetzt über drei Symbole. Die Auswahl dieser legt fest, ob es sich um eine Bildaufforderung, eine Stilreferenz oder eine Zeichenreferenz handelt. Umschalt+Wählen Sie eine Option aus, um ein Bild für mehrere Kategorien zu verwenden

Denken Sie daran, dass sich diese und andere Funktionen während der Alpha-Phase von MJ V6 plötzlich ändern können, die offizielle Betaversion von V6 jedoch bald verfügbar ist. Wir freuen uns über die Meinung aller zu ideas-and-features. Wir hoffen, dass Ihnen diese frühe Veröffentlichung gefällt und dass sie Ihnen dabei hilft, beim Aufbau von Geschichten und Welten zu spielen

Die Mission von VentureBeat soll ein digitaler Stadtplatz für technische Entscheidungsträger sein, um sich Wissen über transformative Unternehmenstechnologie anzueignen und Transaktionen durchzuführen. Entdecken Sie unsere Briefings.