Die Zukunft der künstlichen Intelligenz wird schnell zu einem Out-of-Box-Erlebnis, das Unternehmen an ihre spezifischen Bedürfnisse anpassen können. Optimiert Chat-Erlebnisse, die weit über Frage-und-Antwort-Funktionen hinausgehen, und Tools zum Erstellen von KI-Anwendungen ohne monatelange Programmierentwicklung könnten der nächste Schritt neben der Einführung neuer Plugins und Erweiterungen sein.

Gängigere Tools wie ChatGPT für Informationen und Midjourney für Bilder basieren auf öffentlichen Daten und konsistenter Entwicklercodierung, um ein Endprodukt zu erstellen. In der Zwischenzeit setzt sich Amazon Web Services (AWS) dafür ein, generative KI zu schaffen, die nicht nur produktiver und einfacher zu navigieren ist, sondern auch einzigartige und sichere Daten für die Unternehmen bietet, die ihre Tools einsetzen.

Die Marke nutzt Plattformen wie Amazon Bedrock, um sich im neuen KI-Markt einen einzigartigen Platz zu sichern. Sein Flaggschiff-Hub ist seit April verfügbar und beherbergt mehrere sogenannte Foundation Models (FMs). AWS hat diese Basis-APIs zunächst trainiert und bietet Unternehmen die von ihnen gewünschten Standard-KI-Funktionen. Unternehmen können ihre bevorzugten FMs kombinieren und dann weiterhin Apps entwickeln und ihre eigenen proprietären Daten für ihre individuellen Anforderungen hinzufügen.

„Als Anbieter trainieren wir diese Modelle grundsätzlich anhand eines großen Datenbestands. Sobald das Modell trainiert ist, gibt es einen Grenzwert. Zum Beispiel im Januar 2023, dann hat das Modell nach diesem Zeitpunkt keine Informationen mehr, aber Unternehmen wollen Daten, die privat sind“, sagte Atul Deo, General Manager für Produkt und Technik bei Amazon Bedrock, gegenüber Digital Trends.

Jedes Unternehmen und die von ihm verwendeten Basismodelle variieren, so dass jede resultierende Anwendung auf der Grundlage der Informationen, die Organisationen einem Modell zuführen, einzigartig ist. FMs sind bereits Basisvorlagen. Die anschließende Verwendung von Open-Source-Informationen zur Befüllung der Modelle kann dazu führen, dass sich Anwendungen unternehmensübergreifend wiederholen. Die Strategie von AWS gibt Unternehmen die Möglichkeit, ihre Apps durch die Einführung eigener Daten einzigartig zu machen.

„Sie möchten dem Modell auch einige Fragen stellen und Antworten erhalten, aber wenn es nur Fragen zu einigen veralteten öffentlichen Daten beantworten kann, ist das nicht sehr hilfreich. Sie möchten in der Lage sein, die relevanten Informationen an das Modell weiterzugeben und in Echtzeit die entsprechenden Antworten zu erhalten. Das ist eines der Kernprobleme, das dadurch gelöst wird“, fügte Deo hinzu.

Foundation-Modelle

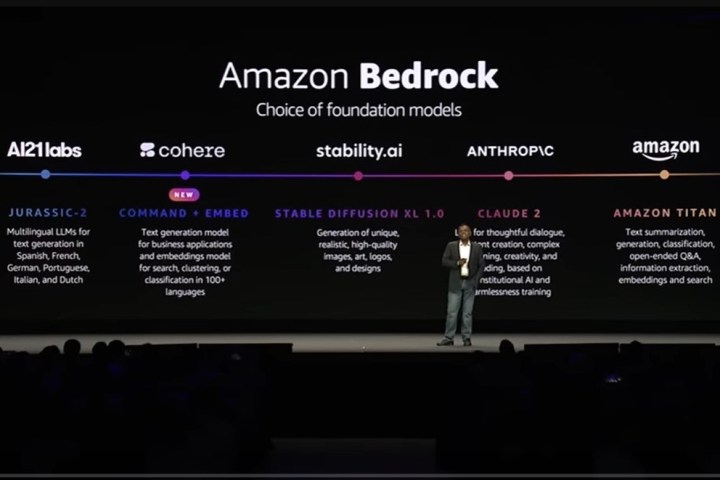

Zu den verschiedenen auf Amazon Bedrock unterstützten Basismodellen gehören Amazon Titan sowie Modelle der Anbieter Anthropic, AI21Labs und StabilityAI, die jeweils wichtige Funktionen im KI-Bereich übernehmen, unter anderem Textanalyse, Bildgenerierung und mehrsprachige Generierung. Bedrock ist eine Fortsetzung der vorab trainierten Modelle, die AWS bereits auf seiner Stagemaker Jumpstart-Plattform entwickelt hat, die im Erdgeschoss vieler öffentlicher FMs eingesetzt wird, darunter Meta AI, Hugging Face, LightOn, Databricks und Alexa.

AWS hat kürzlich auf seinem AWS Summit Ende Juli in New York City auch neue Bedrock-Modelle der Marke Cohere angekündigt. Zu diesen Modellen gehören Command, das Zusammenfassungen, Texterstellung, Dialoge, Textextraktion und Fragenbeantwortung für Geschäftsanwendungen ausführen kann, und Embed, das Clustersuchen durchführen und Aufgaben in über 100 Sprachen klassifizieren kann.

AWS-Vizepräsident für maschinelles Lernen, Swami Sivasubramanian, sagte während der Keynote des Gipfels, dass FMs kostengünstig seien, eine geringe Latenz hätten, dazu gedacht seien, privat angepasst zu werden, Daten verschlüsselt seien und nicht zum Trainieren des ursprünglichen, von AWS entwickelten Basismodells verwendet würden.

Die Marke arbeitet mit einer Vielzahl von Unternehmen zusammen, die Amazon Bedrock nutzen, darunter Chegg, Lonely Planet, Cimpress, Philips, IBM, Nexxiot, Neiman Marcus, Ryanair, Hellmann, WPS Office, Twilio, Bridgewater & Associates, Showpad, Coda und Booking.com .

Agenten für Amazon Bedrock

AWS stellte auf seinem Gipfel auch das Hilfstool Agents for Amazon Bedrock vor, das die Funktionalität von Foundational Models erweitert. Agents richtet sich an Unternehmen für eine Vielzahl von Anwendungsfällen und ist ein erweitertes Chat-Erlebnis, das Benutzern über die Standard-Chatbot-Fragen und -Antworten hinaus hilft. Es ist in der Lage, Aufgaben basierend auf den Informationen, auf die es abgestimmt ist, proaktiv auszuführen.

AWS gab ein Beispiel dafür, wie es in einem kommerziellen Bereich gut funktioniert. Angenommen, ein Einzelhandelskunde wollte ein Paar Schuhe umtauschen. Durch die Interaktion mit dem Agenten kann der Benutzer angeben, dass er einen Schuhaustausch von Größe 8 auf Größe 9 durchführen möchte. Agenten werden nach ihrer Bestellnummer fragen. Nach der Eingabe können Agenten hinter den Kulissen auf den Einzelhandelsbestand zugreifen, dem Kunden mitteilen, dass die gewünschte Größe auf Lager ist, und fragen, ob er mit dem Umtausch fortfahren möchte. Sobald der Benutzer „Ja“ sagt, bestätigen die Agenten, dass die Bestellung aktualisiert wurde.

„Traditionell wäre dies mit viel Arbeit verbunden. Die alten Chatbots waren sehr starr. Wenn Sie hier und da etwas sagen und es nicht funktioniert, würden Sie sagen: „Lass mich einfach mit dem menschlichen Agenten reden“, sagte Deo. „Da große Sprachmodelle nun ein viel umfassenderes Verständnis davon haben, wie Menschen sprechen, können sie Maßnahmen ergreifen und die proprietären Daten in einem Unternehmen nutzen.“

Die Marke gab auch Beispiele dafür, wie eine Versicherungsgesellschaft Agenten einsetzen kann, um Versicherungsansprüche einzureichen und zu organisieren. Agenten können den Mitarbeitern des Unternehmens sogar bei Aufgaben wie dem Nachschlagen der Unternehmensrichtlinien für PTO oder der aktiven Planung dieser Freizeit behilflich sein, mit einem inzwischen allgemein bekannten Stil von KI-Eingabeaufforderungen wie „Cund Sie reichen die PTO für mich ein?“

Agents erfasst insbesondere, wie grundlegende Modelle es Benutzern ermöglichen, sich auf die Aspekte der KI zu konzentrieren, die für sie am wichtigsten sind. Ohne Monate damit verbringen zu müssen, jeweils ein Sprachmodell zu entwickeln und zu trainieren, können Unternehmen mehr Zeit damit verbringen, Informationen, die für ihre Organisation wichtig sind, in Agents zu optimieren und sicherzustellen, dass sie auf dem neuesten Stand sind.

„Sie können ein Modell mit Ihren proprietären Daten verfeinern. Wenn die Anfrage gestellt wird, möchten Sie das Neueste und Beste“, sagte Deo.

Da viele Unternehmen insgesamt weiterhin auf eine stärker geschäftsorientierte Strategie für KI umsteigen, scheint das Ziel von AWS lediglich darin zu bestehen, Marken und Organisationen dabei zu helfen, ihre KI-integrierten Apps und Dienste schneller zum Laufen zu bringen. Die Verkürzung der App-Entwicklungszeit könnte dazu führen, dass neue KI-Apps auf den Markt kommen, aber auch viele häufig verwendete Tools dringend benötigte Updates erhalten.

Empfehlungen der Redaktion