Wikipedia hat ein Problem. Und Meta, das vor nicht allzu langer Zeit umbenannte Facebook, hat vielleicht die Antwort.

Lassen Sie uns zurückgehen. Wikipedia ist eines der größten Gemeinschaftsprojekte in der Geschichte der Menschheit, mit mehr als 100.000 freiwilligen menschlichen Redakteuren, die zum Aufbau und zur Pflege einer unglaublich großen, mehrsprachigen Enzyklopädie beitragen, die aus Millionen von Artikeln besteht. Mehr als 17.000 neue Artikel werden jeden Monat zu Wikipedia hinzugefügt, während ständig Optimierungen und Modifikationen am bestehenden Korpus von Artikeln vorgenommen werden. Die beliebtesten Wiki-Artikel wurden tausende Male bearbeitet und spiegeln die neuesten Forschungsergebnisse, Erkenntnisse und topaktuellen Informationen wider.

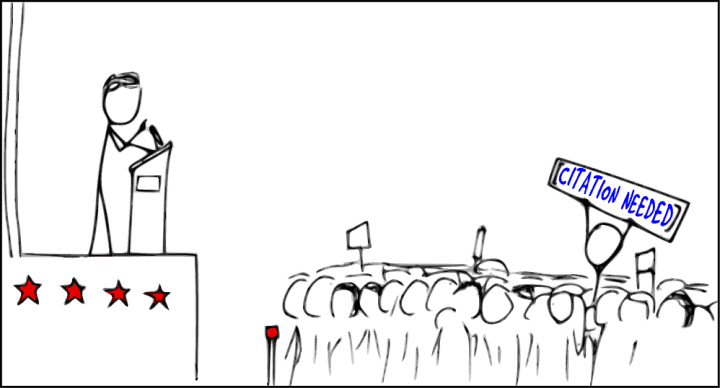

Die Herausforderung ist natürlich die Genauigkeit. Die bloße Existenz von Wikipedia ist ein positiver Beweis dafür, dass eine große Anzahl von Menschen zusammenkommen kann, um etwas Positives zu schaffen. Aber um wirklich nützlich zu sein und keine ausufernde Graffiti-Wand unbegründeter Behauptungen, müssen Wikipedia-Artikel durch Fakten untermauert werden. Hier kommen Zitate ins Spiel. Die Idee – und das funktioniert größtenteils sehr gut – ist, dass Wikipedia-Benutzer und Redakteure Fakten bestätigen können, indem sie Hyperlinks hinzufügen oder anklicken, die Aussagen zu ihrer Quelle zurückverfolgen.

Zitat benötigt

Nehmen wir zum Beispiel an, ich möchte den Eintrag im Wikipedia-Artikel von Präsident Barack Obama bestätigen, der besagt, dass Obama 1988 nach Europa und dann nach Kenia gereist ist, wo er viele seiner väterlichen Verwandten zum ersten Mal getroffen hat. Alles, was ich tun muss, ist, mir die Zitate für den Satz anzusehen, und tatsächlich gibt es drei separate Buchreferenzen, die anscheinend bestätigen, dass sich die Tatsache bestätigt.

Im Gegensatz dazu ist die Phrase „Zitieren erforderlich“ wahrscheinlich die zwei vernichtendsten in ganz Wikipedia, gerade weil sie suggerieren, dass es keinen Beweis dafür gibt, dass der Autor die Wörter nicht aus dem digitalen Äther heraufbeschworen hat. Die Worte „Zitat erforderlich“, die an eine Wikipedia-Behauptung angehängt werden, sind gleichbedeutend damit, jemandem eine Tatsache zu sagen, während man Fingerzitate in der Luft macht.

Zitate sagen uns jedoch nicht alles. Wenn ich Ihnen sagen würde, dass ich letztes Jahr der 23. bestverdienende Tech-Journalist der Welt war und dass ich einmal eine lukrative Modelkarriere aufgegeben habe, um Artikel für Digital Trends zu schreiben, erscheint es oberflächlich plausibel, weil es Hyperlinks gibt, die unterstützen meine Wahnvorstellungen.

Dass die Hyperlinks meine Alternativfakten überhaupt nicht unterstützen, sondern auf sachfremde Seiten zu Digital Trends führen, erschließt sich erst beim Anklicken. Für die 99,9 Prozent der Leser, die mich noch nie getroffen haben, verlassen sie diesen Artikel möglicherweise mit einer Reihe falscher Eindrücke, von denen nicht zuletzt die überraschend niedrige Eintrittsbarriere in die Welt des Modelns ist. In einer hyperverlinkten Welt der Informationsüberflutung, in der wir zunehmend in dem herumspritzen, was Nicholas Carr als „The Shallows“ bezeichnet, erscheint die Existenz von Zitaten selbst als sachliche Bestätigung.

Meta watet herein

Aber was ist, wenn Zitate von Wikipedia-Redakteuren hinzugefügt werden, selbst wenn sie nicht auf Seiten verlinken, die die Behauptungen tatsächlich stützen? Zur Veranschaulichung beschrieb ein kürzlich erschienener Wikipedia-Artikel über das Mitglied des Blackfeet-Stammes, Joe Hipp, wie Hipp der erste indianische Boxer war, der um den WBA World Heavyweight-Titel kämpfte, und verlinkte auf eine scheinbar angemessene Webseite. Die betreffende Webseite erwähnte jedoch weder Boxen noch Joe Hipp.

Im Fall der Behauptung von Joe Hipp war das Wikipedia-Faktoid korrekt, auch wenn das Zitat unangemessen war. Nichtsdestotrotz ist es leicht zu erkennen, wie dies absichtlich oder auf andere Weise zur Verbreitung von Fehlinformationen verwendet werden könnte.

Hier glaubt Meta, einen Weg gefunden zu haben, um zu helfen. In Zusammenarbeit mit der Wikimedia Foundation hat Meta AI (das ist das KI-Forschungs- und Entwicklungsforschungslabor des Social-Media-Riesen) das angeblich erste maschinelle Lernmodell entwickelt, das automatisch Hunderttausende von Zitaten auf einmal scannen kann, um zu prüfen, ob sie unterstützen die entsprechenden Ansprüche. Dies wäre zwar weit entfernt von dem ersten Bot, den Wikipedia verwendet, aber er könnte einer der beeindruckendsten sein.

„Ich denke, wir waren am Ende des Tages von Neugier getrieben“, sagte Fabio Petroni, Research Tech Lead Manager des FAIR-Teams (Fundamental AI Research) von Meta AI, gegenüber Digital Trends. „Wir wollten sehen, wo die Grenzen dieser Technologie liegen. Wir waren uns absolut nicht sicher, ob [this AI] könnte in diesem Zusammenhang etwas Sinnvolles tun. Niemand hatte jemals versucht, etwas Ähnliches zu tun [before].“

Bedeutung verstehen

Das neue Tool von Meta, das mit einem Datensatz trainiert wurde, der aus 4 Millionen Wikipedia-Zitaten besteht, ist in der Lage, die mit einem Zitat verknüpften Informationen effektiv zu analysieren und sie dann mit den unterstützenden Beweisen abzugleichen. Und dies ist auch nicht nur ein einfacher Vergleich von Textzeichenfolgen.

„Es gibt so eine Komponente, [looking at] die lexikalische Ähnlichkeit zwischen der Behauptung und der Quelle, aber das ist der einfache Fall“, sagte Petroni. „Mit diesen Modellen haben wir einen Index all dieser Webseiten erstellt, indem wir sie in Passagen aufgeteilt und eine genaue Darstellung für jede Passage bereitgestellt haben … Das stellt die Passage nicht Wort für Wort dar, sondern die Bedeutung der Passage . Das bedeutet, dass zwei Textblöcke mit ähnlicher Bedeutung in dem resultierenden n-dimensionalen Raum, in dem all diese Passagen gespeichert sind, an einer sehr nahen Position dargestellt werden.“

Genauso beeindruckend wie die Fähigkeit, betrügerische Zitate zu erkennen, ist jedoch das Potenzial des Tools, bessere Referenzen vorzuschlagen. Als Produktionsmodell eingesetzt, könnte dieses Tool hilfreiche Referenzen vorschlagen, die einen bestimmten Punkt am besten veranschaulichen. Während Petroni sich dagegen sträubt, dass es mit einer sachlichen Rechtschreibprüfung verglichen wird, Fehler anzeigt und Verbesserungen vorschlägt, ist dies eine einfache Möglichkeit, darüber nachzudenken, was es tun könnte.

Aber wie Petroni erklärt, gibt es noch viel zu tun, bevor es an diesen Punkt kommt. „Was wir gebaut haben, ist ein Machbarkeitsnachweis“, sagte er. „Im Moment ist es nicht wirklich nutzbar. Damit dies verwendet werden kann, benötigen Sie einen neuen Index, der viel mehr Daten indiziert, als wir derzeit haben. Es muss ständig aktualisiert werden, da täglich neue Informationen hinzukommen.“

Dies könnte, zumindest theoretisch, nicht nur Text, sondern auch Multimedia umfassen. Vielleicht gibt es auf YouTube einen großartigen maßgeblichen Dokumentarfilm, auf den das System die Benutzer verweisen könnte. Vielleicht ist die Antwort auf eine bestimmte Behauptung irgendwo im Internet in einem Bild versteckt.

Eine Frage der Qualität

Es gibt auch andere Herausforderungen. Bemerkenswert ist, dass zumindest derzeit kein Versuch unternommen wird, die Qualität der zitierten Quellen unabhängig zu bewerten. Dies ist ein heikler Bereich für sich. Als einfache Veranschaulichung wäre ein kurzer, wegwerfbarer Verweis auf ein Thema in, sagen wir, der New York Times ein passenderes, qualitativ hochwertigeres Zitat erweisen als eine umfangreichere, aber weniger renommierte Quelle? Sollte eine Mainstream-Publikation einen höheren Rang einnehmen als eine Nicht-Mainstream-Publikation?

Googles Billionen-Dollar-PageRank-Algorithmus – sicherlich der berühmteste Algorithmus, der jemals um Zitate herum gebaut wurde – hatte dies in sein Modell eingebaut, indem er im Wesentlichen eine qualitativ hochwertige Quelle mit einer Quelle gleichsetzte, die eine hohe Anzahl eingehender Links hatte. Derzeit hat Metas KI nichts dergleichen.

Wenn diese KI als effektives Werkzeug funktionieren soll, müsste sie so etwas haben. Stellen Sie sich als ein sehr offensichtliches Beispiel dafür vor, dass jemand die ungeheuerlichste, verwerflichste Meinung für die Aufnahme auf einer Wikipedia-Seite „beweisen“ sollte. Wenn der einzige Beweis, der benötigt wird, um zu bestätigen, dass etwas wahr ist, darin besteht, ob ähnliche Meinungen an anderer Stelle online veröffentlicht wurden, dann könnte sich praktisch jede Behauptung als richtig erweisen – egal wie falsch sie sein mag.

„[One area we are interested in] versucht, die Vertrauenswürdigkeit einer Quelle, die Vertrauenswürdigkeit einer Domäne explizit zu modellieren“, sagte Petroni. „Ich denke, Wikipedia hat bereits eine Liste mit Domains, die als vertrauenswürdig gelten, und Domains, die als nicht vertrauenswürdig gelten. Aber anstatt eine feste Liste zu haben, wäre es schön, wenn wir einen Weg finden könnten, diese algorithmisch zu fördern.“

Empfehlungen der Redaktion