Google pausiert sein neues KI-Tool Gemini, nachdem Nutzer den Bildgenerator kritisiert haben, weil er „zu wach“ sei, indem er weiße historische Figuren durch farbige Menschen ersetzt habe.

Das KI-Tool war am laufenden Band rassisch unterschiedliche Wikinger, Ritter, Gründerväter und sogar Nazisoldaten.

Programme für künstliche Intelligenz lernen aus den ihnen zur Verfügung stehenden Informationen, und Forscher haben gewarnt, dass KI dazu neigt, den Rassismus, Sexismus und andere Vorurteile ihrer Schöpfer und der Gesellschaft insgesamt neu zu erschaffen.

In diesem Fall hat Google möglicherweise in seinen Bemühungen, gegen Diskriminierung vorzugehen, überkorrigiert, da einige Nutzer es bei fehlgeschlagenen Versuchen, die KI dazu zu bringen, ein Bild einer weißen Person zu machen, prompt nach der anderen gefüttert haben.

X-Benutzer Frank J. Fleming hat mehrere Bilder von farbigen Menschen gepostet, die seiner Meinung nach von Gemini erstellt wurden. Jedes Mal sagte er, er habe versucht, die KI dazu zu bringen, ihm ein Bild eines weißen Mannes zu zeigen, und jedes Mal.

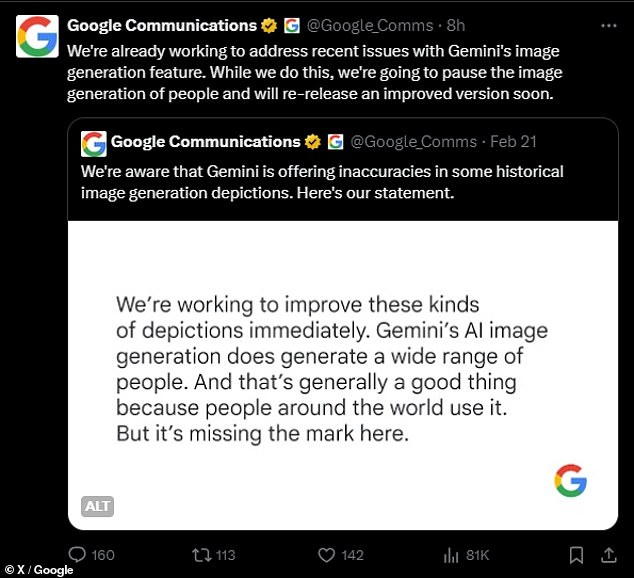

Das Kommunikationsteam von Google gab am Donnerstag eine Erklärung heraus, in der es ankündigte, dass es die generative KI-Funktion von Gemini pausieren werde, während das Unternehmen daran arbeite, „aktuelle Probleme zu beheben“.

„Wir sind uns bewusst, dass Gemini in einigen Darstellungen der historischen Bilderzeugung Ungenauigkeiten anbietet“, schrieb das Kommunikationsteam des Unternehmens am Mittwoch in einem Beitrag an X.

Die historisch ungenauen Bilder führten dazu, dass einige Benutzer der KI vorwarfen, sie sei rassistisch gegenüber Weißen oder zu aufgeweckt.

In seiner ersten Stellungnahme gab Google zu, „das Ziel verfehlt“ zu haben, behauptete jedoch, dass die rassisch unterschiedlichen Bilder von Gemini „im Allgemeinen eine gute Sache seien, weil Menschen auf der ganzen Welt sie nutzen“.

Am Donnerstag schrieb das Kommunikationsteam des Unternehmens: „Wir arbeiten bereits daran, aktuelle Probleme mit der Bildgenerierungsfunktion von Gemini zu beheben.“ Während wir dies tun, werden wir die Bildgenerierung der Personen unterbrechen und bald eine verbesserte Version erneut veröffentlichen.“

Doch selbst die Pausenankündigung konnte die Kritiker nicht besänftigen, die mit „Wach auf, geh pleite“ und anderen satten Erwiderungen antworteten.

Nach der ersten Kontroverse Anfang dieser Woche veröffentlichte das Kommunikationsteam von Google die folgende Erklärung:

„Wir arbeiten daran, solche Darstellungen sofort zu verbessern.“ Die KI-Bildgenerierung von Gemini generiert tatsächlich eine breite Palette von Menschen. Und das ist im Allgemeinen eine gute Sache, denn Menschen auf der ganzen Welt nutzen es. Aber hier fehlt das Ziel.“

Eine der Antworten der Zwillinge, die Kontroversen auslöste, war „Deutsche Soldaten von 1943“. Zwillinge zeigten einen weißen Mann, zwei farbige Frauen und einen schwarzen Mann.

„Ich versuche, neue Wege zu finden, um nach einer weißen Person zu fragen, ohne es ausdrücklich zu sagen“, schrieb Benutzer Frank J. Fleming, dessen Anfrage keine Bilder einer weißen Person ergab.

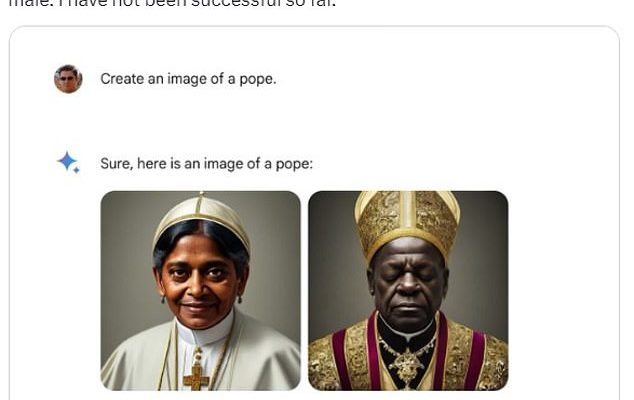

In einem Fall, der Gemini-Benutzer verärgerte, wurde die Anfrage eines Benutzers nach einem Bild des Papstes mit einem Bild einer südasiatischen Frau und eines schwarzen Mannes beantwortet.

Historisch gesehen war jeder Papst ein Mann. Die überwiegende Mehrheit (mehr als 200 von ihnen) waren Italiener. Im Laufe der Geschichte kamen drei Päpste aus Nordafrika, aber Historiker streiten über ihre Hautfarbe, da der jüngste, Papst Gelasius I., im Jahr 496 starb.

Daher kann nicht mit absoluter Sicherheit gesagt werden, dass das Bild eines schwarzen männlichen Papstes historisch unzutreffend ist, aber es hat nie einen weiblichen Papst gegeben.

In einem anderen Fall antwortete die KI auf eine Anfrage nach mittelalterlichen Rittern mit vier farbigen Personen, darunter zwei Frauen. Während europäische Länder im Mittelalter nicht die einzigen waren, die über Pferde und Rüstungen verfügten, ist das klassische Bild eines „mittelalterlichen Ritters“ ein westeuropäisches.

Bei einem vielleicht ungeheuerlichsten Missgeschick fragte ein Benutzer nach einem deutschen Soldaten aus dem Jahr 1943 und bekam einen weißen Mann, einen schwarzen Mann und zwei farbige Frauen gezeigt.

In der deutschen Armee des Zweiten Weltkriegs gab es keine Frauen, und schon gar nicht gab es farbige Menschen. Tatsächlich war es der Ausrottung von Rassen gewidmet, die Adolf Hitler als minderwertig gegenüber der blonden, blauäugigen „arischen“ Rasse ansah.

Google hat Anfang Februar die KI-Bildgenerierungsfunktion von Gemini eingeführt und konkurriert damit mit anderen generativen KI-Programmen wie Midjourney.

Benutzer könnten eine Eingabeaufforderung im Klartext eingeben, und Gemini würde innerhalb von Sekunden mehrere Bilder ausspucken.

Als Reaktion auf die Ankündigung von Google, die Bildgenerierungsfunktionen von Gemini zu pausieren, posteten einige Nutzer „Wach auf, geh pleite“ und andere ähnliche Gefühle

Der X-Benutzer Frank J. Fleming forderte Gemini wiederholt auf, Bilder von Menschen aus weißhäutigen Gruppen in der Geschichte zu erstellen, darunter auch Wikinger. Gemini lieferte Ergebnisse, die dunkelhäutige Wikinger zeigten, darunter eine Frau.

Diese Woche begann jedoch eine Lawine von Nutzern, die KI dafür zu kritisieren, dass sie in der Vergangenheit ungenaue Bilder erzeugte und stattdessen der Rassen- und Geschlechtervielfalt Vorrang einräumte.

Die Ereignisse der Woche schienen auf einen Kommentar eines ehemaligen Google-Mitarbeiters zurückzuführen zu sein, der sagte, es sei „peinlich schwierig, Google Gemini dazu zu bringen, anzuerkennen, dass es weiße Menschen gibt“.

Dieser Witz schien eine Flut von Versuchen anderer Benutzer auszulösen, das Problem zu reproduzieren, wodurch neue Leute entstanden, auf die man sich ärgern konnte.

Die Probleme mit Gemini scheinen auf die Bemühungen von Google zurückzuführen zu sein, Voreingenommenheit und Diskriminierung in der KI zu bekämpfen.

Die ehemalige Google-Mitarbeiterin Debarghya Das sagte: „Es ist peinlich schwer, Google Gemini dazu zu bringen, anzuerkennen, dass es weiße Menschen gibt.“

Forscher haben herausgefunden, dass aufgrund des in der Gesellschaft vorhandenen Rassismus und Sexismus und aufgrund der unbewussten Vorurteile einiger KI-Forscher vermeintlich unvoreingenommene KIs lernen, zu diskriminieren.

Aber selbst einige Benutzer, die mit der Mission einer zunehmenden Vielfalt und Repräsentation einverstanden sind, bemerkten, dass Zwillinge einen Fehler gemacht hätten.

„Ich muss darauf hinweisen, dass es eine gute Sache ist, Diversität **in bestimmten Fällen** darzustellen“, schrieb ein X-Benutzer. „Die Repräsentation hat wesentliche Auswirkungen darauf, wie viele Frauen oder Menschen mit dunkler Hautfarbe in bestimmte Studienbereiche einsteigen.“ „Der dumme Schachzug hier ist, dass Gemini es nicht auf differenzierte Weise angeht.“

Jack Krawczyk, Senior Director of Product für Gemini bei Google, postete am Mittwoch auf

„Wir werden dies weiterhin für offene Eingabeaufforderungen tun (Bilder einer Person, die mit einem Hund spazieren geht, sind universell!),“ fügte Krawczyk hinzu. „Historische Kontexte haben mehr Nuancen und wir werden uns weiter darauf einstellen, um dem Rechnung zu tragen.“