Wissenschaftler haben eine KI durch die Augen eines Babys trainiert, um der Technologie beizubringen, wie sich die Menschheit entwickelt – aus Angst, sie könnte uns zerstören.

Forscher der New York University schnallten Sam einen Headcam-Recorder an, als er gerade sechs Monate alt war und seinen zweiten Geburtstag hatte.

Das Filmmaterial aus 250.000 Wörtern und entsprechenden Bildern wurde einem KI-Modell zugeführt, das ähnlich wie Sam lernte, verschiedene Objekte zu erkennen.

Die KI entwickelte ihr Wissen auf die gleiche Weise wie das Kind – indem sie die Umgebung beobachtete, auf Menschen in der Nähe hörte und Punkte zwischen dem Gesehenen und dem Gehörten verknüpfte.

Das Experiment ermittelte auch den Zusammenhang zwischen visueller und sprachlicher Darstellung in der Entwicklung eines Kindes.

Forscher an der NYU zeichneten das Aussehen eines Kindes aus der Ich-Perspektive auf, indem sie eine Kamera an den sechs Monate alten Sam (im Bild) anbrachten, bis er etwa zwei Jahre alt war.

Die Forscher wollten herausfinden, wie Menschen Wörter mit der visuellen Darstellung verknüpfen, beispielsweise indem sie das Wort „Ball“ mit einem runden, federnden Objekt assoziieren und nicht mit anderen Merkmalen, Objekten oder Ereignissen.

Die Kamera erfasste zufällig Sams tägliche Aktivitäten, wie Essenszeiten, das Lesen von Büchern und das Spielen des Kindes, was etwa 60 Stunden an Daten umfasste

„Indem wir KI-Modelle verwenden, um die tatsächlichen Sprachlernprobleme von Kindern zu untersuchen, können wir klassische Debatten darüber angehen, welche Zutaten Kinder zum Erlernen von Wörtern benötigen – ob sie sprachspezifische Vorurteile, angeborenes Wissen oder einfach nur assoziatives Lernen benötigen, um loszulegen.“ “, sagte Brenden Lake, Assistenzprofessor am Center for Data Science und Department of Psychology der NYU und leitender Autor des Artikels.

Die Kamera nahm 61 Stunden Filmmaterial auf, was etwa einem Prozent von Sams wachen Stunden entspricht, und wurde verwendet, um das CVCL-Modell zu trainieren, Wörter mit Bildern zu verknüpfen. Die KI konnte feststellen, dass es sich um eine Katze handelte

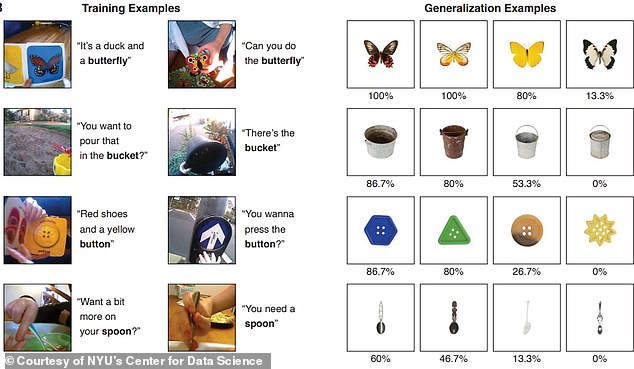

Das CVCL-Modell verknüpfte Bilder und Text in etwa 61,6 Prozent der Fälle genau. Abgebildet ist das Objekt, das die KI anhand des Filmmaterials bestimmen konnte

„Es scheint, dass wir allein durch Lernen mehr erreichen können, als allgemein angenommen wird.“

Die Forscher verwendeten einen Vision- und Text-Encoder, um Bilder und geschriebene Sprache zu übersetzen, damit das KI-Modell das über Sams Headset aufgenommene Filmmaterial interpretieren kann.

Während das Filmmaterial Wörter und Bilder häufig nicht direkt miteinander verknüpfte, war der CVCL-Bot (Child’s View for Contrastive Learning Model), bestehend aus KI und Headcam, in der Lage, die Bedeutungen zu erkennen.

Das Modell nutzte einen kontrastiven Lernansatz, der Informationen aufbaut, um vorherzusagen, welche Bilder und Texte zusammenpassen.

Die Forscher präsentierten mehrere Tests mit 22 einzelnen Wörtern und Bildern, die im Videomaterial des Kindes vorhanden waren, und stellten fest, dass das Modell viele der Wörter und ihre Bilder korrekt zuordnen konnte.

Ihre Ergebnisse zeigten, dass das KI-Modell das Gelernte mit einer Genauigkeit von 61,6 Prozent verallgemeinern konnte und in 35 Prozent der Fälle unsichtbare Beispiele wie „Apfel“ und „Hund“ korrekt identifizieren konnte.

„Wir zeigen zum ersten Mal, dass ein neuronales Netzwerk, das auf diesen entwicklungsrealistischen Input eines einzelnen Kindes trainiert wird, lernen kann, Wörter mit ihren visuellen Gegenstücken zu verknüpfen“, sagt Wai Keen Vong, Forscher am Center for Data Science der NYU Erstautor der Zeitung.

„Unsere Ergebnisse zeigen, wie jüngste algorithmische Fortschritte gepaart mit der naturalistischen Erfahrung eines Kindes das Potenzial haben, unser Verständnis des frühen Sprach- und Konzepterwerbs neu zu gestalten.“

Die Forscher fanden heraus, dass das KI-Modell immer noch Nachteile aufweist und der Test zwar vielversprechend war, um zu verstehen, wie Babys kognitive Funktionen entwickeln, er jedoch durch die Unfähigkeit, das Leben des Babys vollständig zu erleben, eingeschränkt war.

Ein Beispiel zeigte, dass CVCL Schwierigkeiten hatte, das Wort „Hand“ zu lernen, was ein Baby normalerweise sehr früh in seinem Leben lernt.

„Babys haben ihre eigenen Hände, sie haben viel Erfahrung damit“, sagte Vong gegenüber Nature und fügte hinzu: „Das ist definitiv ein fehlender Bestandteil unseres Modells.“

Die Forscher planen, zusätzliche Untersuchungen durchzuführen, um das frühe Sprachenlernen bei kleinen Kindern im Alter von etwa zwei Jahren zu reproduzieren.

Obwohl die Informationen nicht perfekt waren, sagte Lake, sie seien „absolut einzigartig“ und hätten „den besten Einblick, den wir je hatten, in das, wozu ein einzelnes Kind Zugang hat.“