Den Unterschied zwischen einem echten Foto und einem KI-generierten Bild zu erkennen, wird immer schwieriger, je realistischer die Deepfake-Technologie wird.

Forscher der University of Waterloo in Kanada wollten herausfinden, ob Menschen KI-Bilder von echten unterscheiden können.

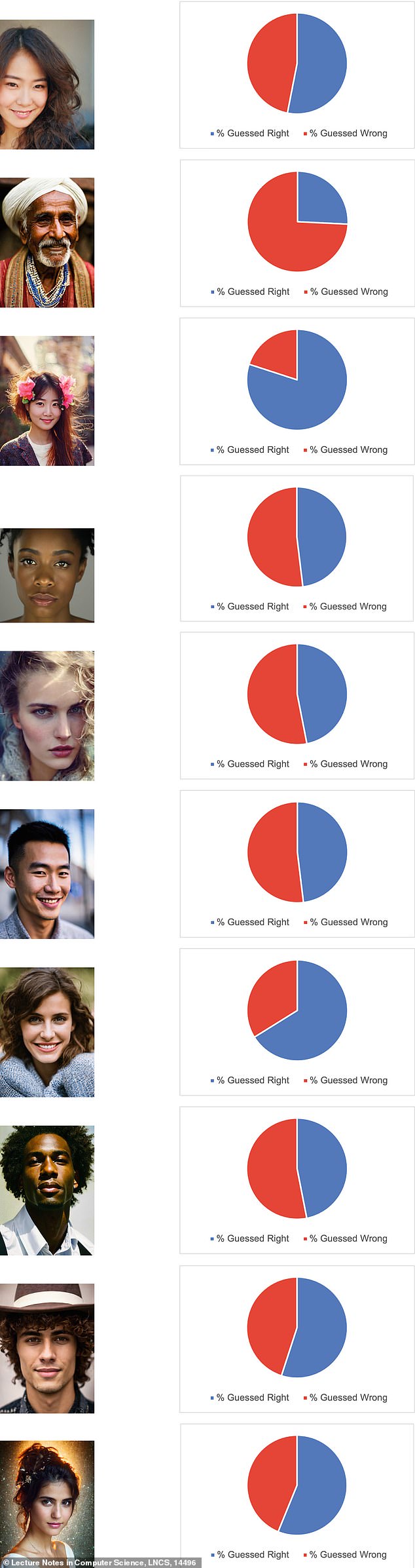

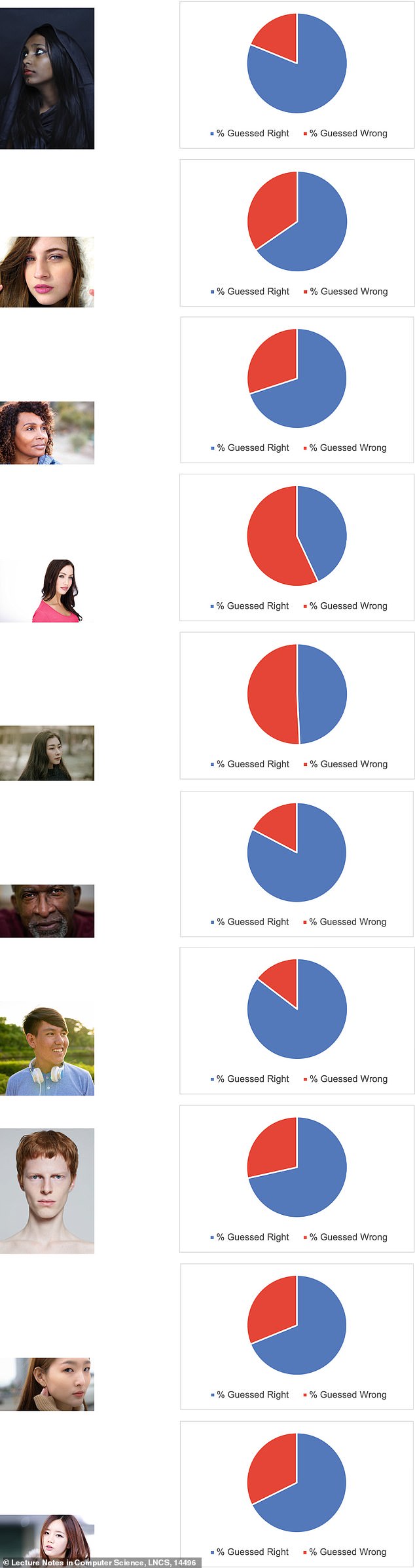

Sie baten 260 Teilnehmer, 10 Bilder, die durch eine Google-Suche gesammelt wurden, und 10 Bilder, die durch Stable Diffusion oder DALL-E – zwei KI-Programme zur Erstellung von Deepfake-Bildern – generiert wurden, als echt oder gefälscht zu kennzeichnen.

Die Forscher stellten fest, dass sie erwarteten, dass 85 Prozent der Teilnehmer die Bilder genau identifizieren könnten, aber nur 61 Prozent der Menschen richtig geraten hätten.

Scrollen Sie bis zum Ende dieses Artikels, um die Antworten zu erhalten

Die Forscher baten 260 Teilnehmer, herauszufinden, ob ein Bild echt oder gefälscht war, aber fast 40 Prozent der Menschen lagen falsch

Die in Springer Link veröffentlichte Studie ergab, dass die häufigsten Gründe, warum Menschen die Bilder als echt oder gefälscht identifizierten, darin bestanden, Details wie Augen und Haare zu betrachten, während andere, allgemeinere Gründe darin bestanden, dass das Bild „seltsam aussah“.

Den Teilnehmern war es erlaubt, die Bilder unbegrenzt lange anzusehen und sich auf die kleinen Details zu konzentrieren, was sie höchstwahrscheinlich nicht tun würden, wenn sie nur online scrollen würden – auch bekannt als „Doomscrolling“.

In der Umfrage wurden die Teilnehmer jedoch gebeten, ihre Antworten nicht zu sehr zu überdenken, und es wurde empfohlen, „so viel Aufmerksamkeit zu schenken wie einem Schlagzeilenfoto in den Nachrichten.“

„Menschen sind bei der Unterscheidung nicht so geschickt, wie sie denken“, sagte Andreea Pocol, Doktorandin der Informatik an der University of Waterloo und Hauptautorin der Studie.

Die Forscher wählten 10 gefälschte, von der KI generierte Bilder aus

Die Forscher sagten, sie seien motiviert, die Studie durchzuführen, weil zu diesem Thema nicht genügend Forschung betrieben worden sei. Deshalb veröffentlichten sie eine Umfrage, in der sie die Menschen unter anderem auf Twitter, Reddit und Instagram aufforderten, die echten von KI-generierten Bildern zu unterscheiden.

Neben den Bildern konnten die Teilnehmer vor dem Absenden ihrer Antworten begründen, warum sie glaubten, es sei echt oder gefälscht.

In der Studie heißt es, dass fast 40 Prozent der Teilnehmer die Bilder falsch klassifizierten, was zeigte, „dass Menschen nicht gut darin sind, echte Bilder von gefälschten zu unterscheiden, was leicht die Verbreitung falscher und potenziell gefährlicher Narrative ermöglicht“.

Sie trennten die Teilnehmer auch nach Geschlecht – männlich, weiblich oder anders – und stellten fest, dass weibliche Teilnehmer mit einer Genauigkeit von etwa 55 bis 70 Prozent am besten abschnitten, während männliche Teilnehmer eine Genauigkeit von 50 bis 65 Prozent aufwiesen.

Die Forscher wählten 10 ECHTE Bilder aus

Unterdessen hatten diejenigen, die sich als „andere“ identifizierten, mit einer Genauigkeit von 55 bis 65 Prozent eine geringere Wahrscheinlichkeit, die Fälschung im Vergleich zu echten Bildern zu erraten.

Die Teilnehmer wurden dann in Altersgruppen eingeteilt und stellten fest, dass die Genauigkeitsrate bei Personen im Alter von 18 bis 24 Jahren bei 0,62 lag. Mit zunehmendem Alter der Teilnehmer verringerte sich die Wahrscheinlichkeit, richtig zu raten, und sank bei Personen im Alter von 60 bis 64 Jahren auf nur noch 0,53 alt.

In der Studie heißt es, diese Forschung sei wichtig, da „Deepfakes in den letzten Jahren ausgefeilter und einfacher zu erstellen“ geworden seien, „was zu Bedenken hinsichtlich ihrer möglichen Auswirkungen auf die Gesellschaft geführt habe“.

Die Studie kommt zu einem Zeitpunkt, an dem KI-generierte Bilder oder Deepfakes immer häufiger und realistischer werden und nicht nur Prominente, sondern auch normale Menschen, einschließlich Teenager, betreffen.

Seit Jahren geraten Prominente ins Visier von Deepfakes, so tauchten 2018 gefälschte Sexvideos von Scarlett Johanson online auf, und zwei Jahre später geriet der Schauspieler Tom Hanks ins Visier von KI-generierten Bildern.

Dann, im Januar dieses Jahres, geriet Popstar Taylor Swift ins Visier gefälschter pornografischer Deepfake-Bilder, die im Internet viral gingen und 47 Millionen Aufrufe auf X erzielten, bevor sie entfernt wurden.

Deepfakes tauchten auch an einer High School in New Jersey auf, als ein männlicher Teenager gefälschte pornografische Fotos seiner Klassenkameradinnen teilte.

„Desinformation ist nicht neu, aber die Instrumente der Desinformation haben sich ständig verändert und weiterentwickelt“, sagte Pocol.

„Es könnte an einem Punkt angelangt sein, an dem Menschen, egal wie gut sie ausgebildet sind, immer noch Schwierigkeiten haben werden, echte Bilder von Fälschungen zu unterscheiden.“

„Deshalb müssen wir Instrumente entwickeln, um dies zu erkennen und zu bekämpfen.“ Es ist wie ein neues KI-Wettrüsten.“

ANTWORTEN: (Von links oben nach rechts) Fake, Fake, Real, Fake (Von links unten nach rechts) Fake, Fake, Real, Real