Beim Teasing des Pixel 6 Anfang August hat Google die Vorschau sehr um sein erstes maßgeschneidertes System-on-a-Chip (SoC) gerahmt. Auf dem Pixel Fall Event heute hat Google Tensor ausführlich beschrieben und es als die „größte mobile Hardware-Innovation in der Geschichte des Unternehmens“ bezeichnet.

Warum Tensor

Googles erklärtes Ziel bei der Entwicklung von Tensor ist es, das Machbare auf Smartphones voranzutreiben. Das Unternehmen möchte „KI-Durchbrüche direkt auf Pixel“ bringen und seine Vision einer immer verfügbaren Technologie, dh Ambient Computing, vorantreiben

Ersteres ist aus der Hardwareabteilung von Google hervorgegangen, die davon überzeugt ist, dass Pixel mit KI-gestützten intelligenten Funktionen von Mitbewerbern unterschieden werden kann, während Google Telefone als „zentrales Steuergerät eines Umgebungssystems“ betrachtet. Beim Pixel Launch Event sprach Google insbesondere wieder über Ambient Computing. Das letzte Mal, das in nennenswerter Weise aufgetreten ist, war der Start von Pixel 4 im Jahr 2019.

In einem Interview mit The Verge sagte Rick Osterloh, dass die Arbeit 2017 begann, nachdem er erkannt hatte, dass Google keinen schrittweisen Ansatz verfolgen konnte – wie den Bau eines einzelnen Co-Prozessors, z. B. Pixel Visual/Neural Core – um KI-Modelle zu verbessern. Vielmehr wird ein ganzer Chip benötigt, der für gewünschte Aufgaben optimiert ist.

Der Tensor-Chip wurde speziell entwickelt, um die neuesten Fortschritte von Google im Bereich KI direkt auf einem mobilen Gerät anzubieten. Dies ist ein Bereich, in dem wir uns jahrelang zurückgehalten haben, aber jetzt können wir ein neues Kapitel der KI-gesteuerten Smartphone-Innovation aufschlagen.

Die Tensor-CPU + GPU

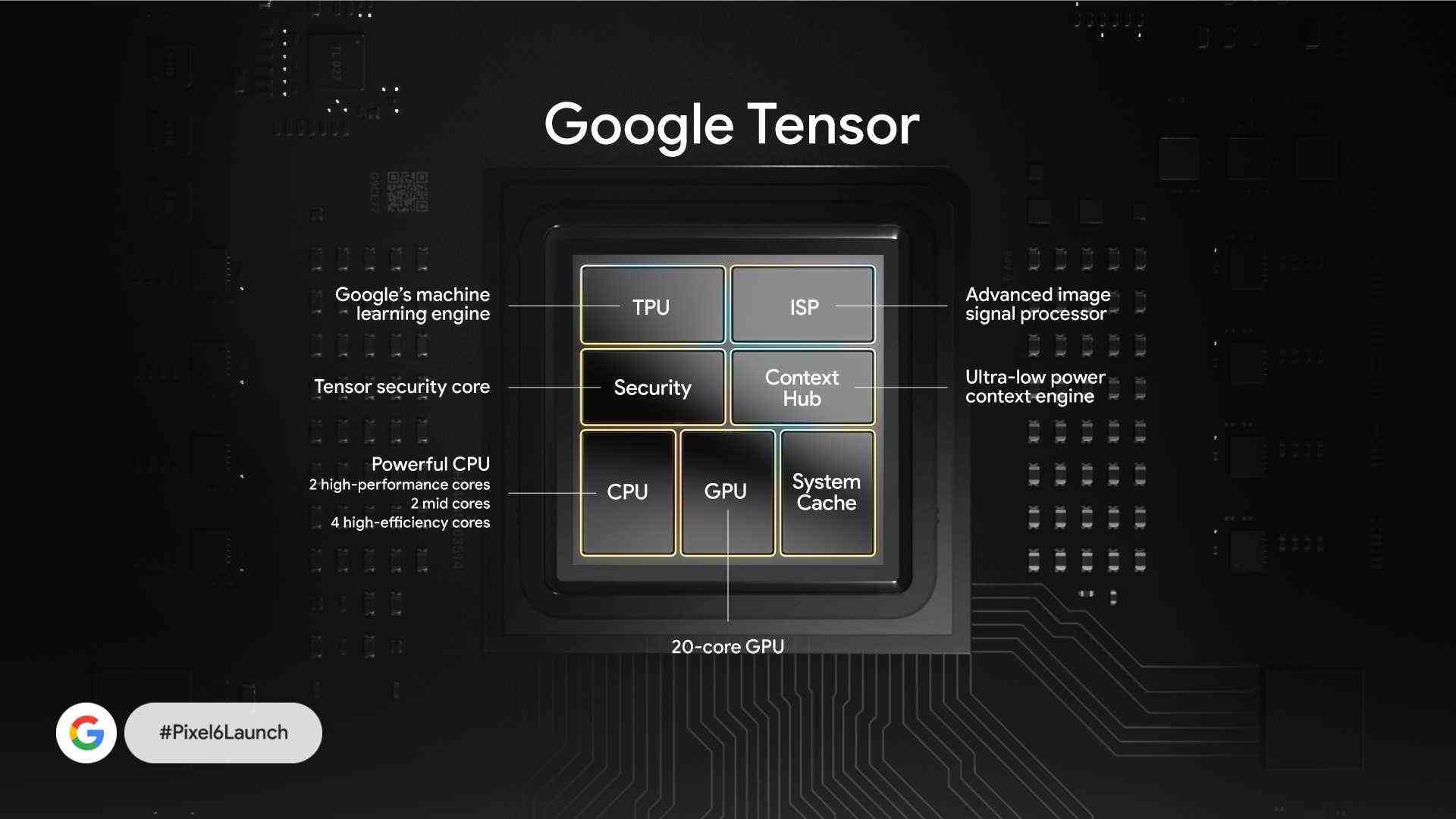

Beim Pixel Launch Event ging Google auf Tensor ein und warb explizit für die Aufnahme von zwei leistungsstarken ARM Cortex-X1-Kernen mit 2,8 GHz. Dazu gesellen sich zwei „mittlere“ 2,25 GHz A76-CPU-Kerne, wobei Ars Technicas Google Silicon-Interview darauf hinweist, dass sie auf einem 5-nm-Prozess basieren und nicht auf dem 7-nm-Original, das letztes Jahr in Flaggschiff-Telefonchips gefunden wurde. Vier hocheffiziente/kleine A55-Kerne runden die CPU ab.

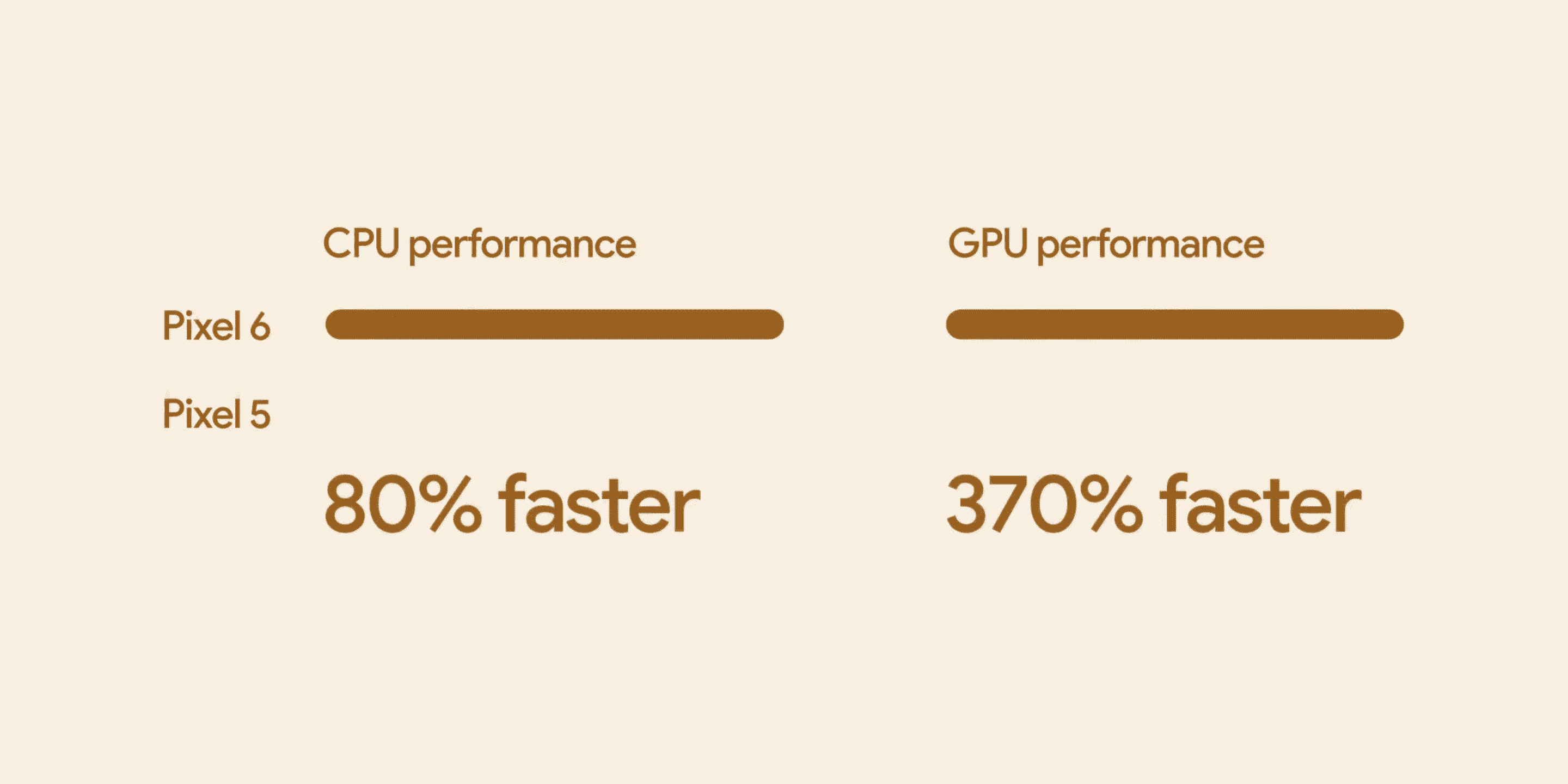

Der Dual-X1-Ansatz ermöglicht es Google, bei Workloads mittlerer Intensität mehr Leistung bereitzustellen. In einer normalen CPU würden die mittleren Kerne solche Aufgaben wie die visuelle Analyse von Google Lens bewältigen, aber “maximal” sein. Laut Google wäre die Verwendung von zwei X1-Kernen in diesem Szenario effizienter, und dafür ist Tensor optimiert. Tatsächlich ist es 80 % schneller als der Snapdragon 765G des Pixel 5.

„Sie können die beiden X1 mit niedrigerer Frequenz verwenden, damit sie extrem effizient sind, aber sie haben immer noch eine ziemlich hohe Arbeitslast. Eine Arbeitsbelastung, die Sie normalerweise mit dualen A76s voll ausgeschöpft hätten, gibt jetzt mit dualen X1s kaum noch Gas.“

Phil Carmack, VP und GM von Google Silicon

Es gibt auch eine 20-Kern-GPU, von der Google sagt, dass sie “ein erstklassiges Spielerlebnis für die beliebtesten Android-Spiele bietet”. Es ist 370 % schneller als das Pixel 5, das die Adreno 620 GPU verwendet.

Tensorsicherheit ft. Titan M2

Der Sicherheitskern von Tensor ist ein CPU-basiertes Subsystem, das vom Anwendungsprozessor isoliert ist und für die Ausführung sensibler Aufgaben und Kontrollen bestimmt ist. Es arbeitet mit dem dedizierten Titan M2-Sicherheitschip, der nicht Teil von Tensor ist, aber Google als widerstandsfähig gegen fortschrittliche Angriffe wie elektromagnetische Analyse, Spannungsstörungen und Laserfehlerinjektion angibt.

Der ursprüngliche Titan M-Chip verhindert in Verbindung mit Software, dass Ihr Telefon auf eine ältere Android-Version zurückgesetzt wird, die möglicherweise Sicherheitslücken aufweist. Es verhindert auch das Entsperren des Bootloaders und überprüft Ihren Sperrbildschirm-Passcode.

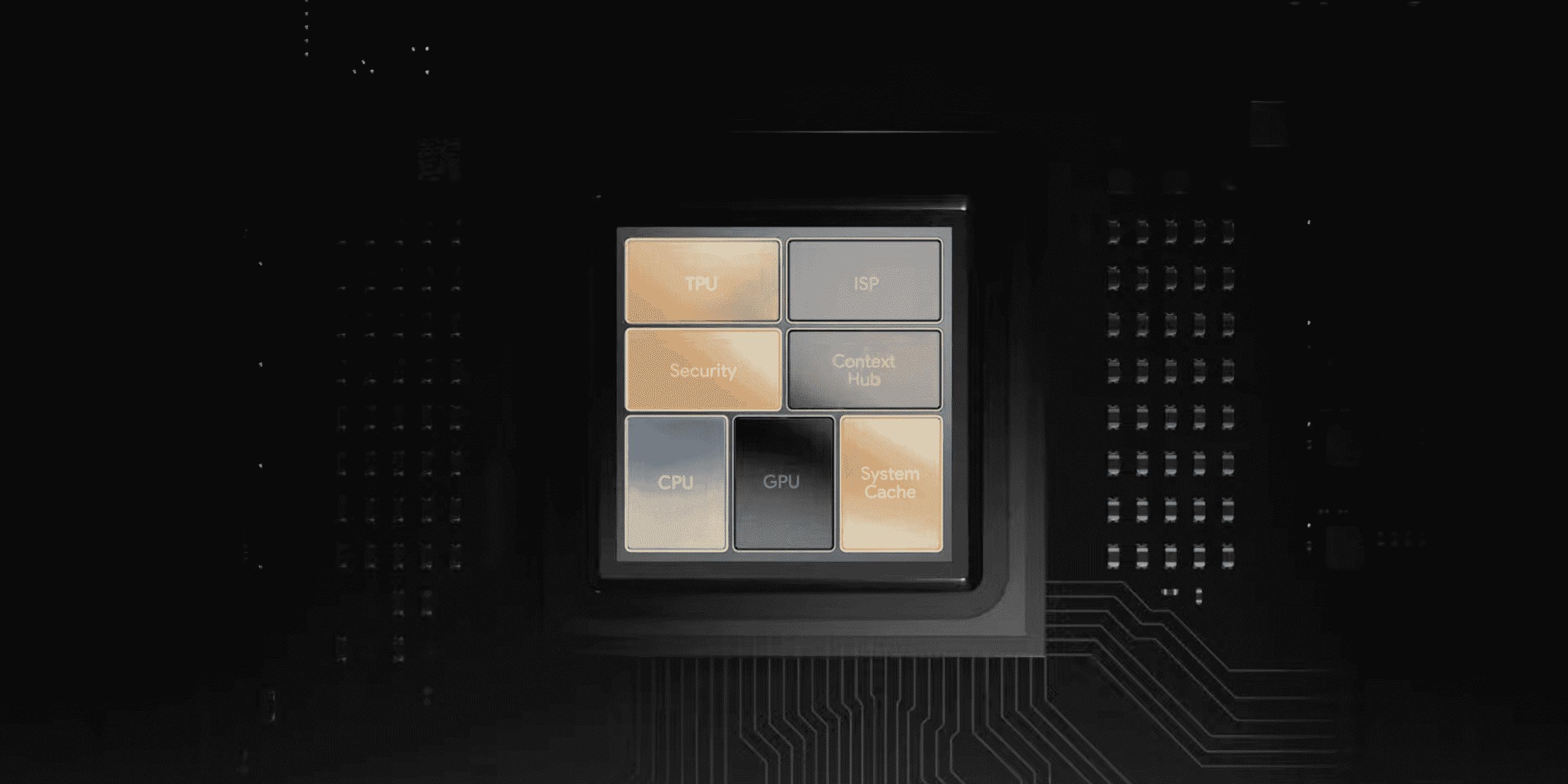

TPU, ISP und Context Hub

Natürlich gibt es auch die „Tensor Processing Unit“. Diese ML-Engine soll “von Google Research für Google Research maßgeschneidert” sein und darauf aufbauen, wo “ML-Modelle auf dem Weg sind, nicht wo sie heute sind”.

Der Bildsignalprozessor (ISP) verfügt über einen Beschleuniger, der den HDRNet-Algorithmus ausführt, ein Hauptgrund dafür, dass Pixel 6 und Pixel 6 Pro Live-HDR+-Videos mit 4K 60FPS effizienter machen können.

Der Context Hub bringt „maschinelles Lernen in die Domäne mit extrem niedrigem Stromverbrauch“. Es ermöglicht, dass das Always-On-Display (AOD), Now Playing und andere „Umgebungserlebnisse“ „die ganze Zeit laufen, ohne den Akku zu entladen“.

Jetzt alle zusammen oder heterogenes Computing

Alle diese Komponenten zusammen bilden Tensor, wobei Google die „Gesamtleistung und Effizienz“ priorisiert. Dies beinhaltet insbesondere die herausragenden Leistungen bei heterogenen Rechenaufgaben, bei denen verschiedene Teile des SoC zusammenarbeiten müssen. Lens nutzt beispielsweise CPU, GPU, ISP und TPU, um effizient zu laufen.

Da Softwareanwendungen auf Mobiltelefonen komplexer werden, laufen sie auf mehreren Teilen des Chips. Dies ist heterogenes Computing. Um eine gute Leistung für diese komplexen Anwendungen zu erzielen, haben wir Entscheidungen auf Systemebene für den SoC getroffen. Wir haben sichergestellt, dass verschiedene Subsysteme innerhalb von Tensor wirklich gut zusammenarbeiten, anstatt einzelne Elemente für Spitzengeschwindigkeiten zu optimieren.

Was Tensor kann

Neben Live HDR+, das Farben genauer und lebendiger macht, ermöglicht Tensor bei 4K60 andere rechnergestützte Fotografie- und Videofunktionen wie den Bewegungsmodus in Google Camera. Action Pan macht den Hintergrund unscharf, während die Langzeitbelichtung auf das Motiv wirkt (siehe unten).

Währenddessen ist die Gesichtserkennung auf dem Pixel 6 genauer und arbeitet schneller – aufgrund der integrierten Subsysteme, während sie im Vergleich zu einem Pixel 5 nur halb so viel Strom verbraucht.

Assistant auf Tensor verwendet das „fortschrittlichste Spracherkennungsmodell, das jemals von Google veröffentlicht wurde“ mit wiederum halber Leistung. Das hochwertige ASR-Modell (automatische Spracherkennung) wird zum Transkribieren von Sprachbefehlen sowie in langlaufenden Anwendungen wie Recorder und Live Caption verwendet, „ohne den Akku schnell zu entladen“.

In der Zwischenzeit gibt es Assistant Voice Typing zum Bearbeiten des gerade transkribierten Inhalts vollständig freihändig, und Live Translate, bei dem sich die Übersetzungsqualität des Pixels um 18 % verbessert, „ein Verbesserungsniveau, das normalerweise mehrere Jahre der Forschung erfordert:“

Google Tensor ermöglicht Live Translate auch die Bearbeitung von Medien wie Videos mithilfe von Sprach- und Übersetzungsmodellen auf dem Gerät. Im Vergleich zu früheren Modellen auf Pixel-4-Telefonen verbraucht das neue Modell der neuronalen maschinellen Übersetzung (NMT) auf dem Gerät weniger als die Hälfte der Leistung, wenn es auf Google Tensor ausgeführt wird.

Tensors Zukunft

Google gibt Tensor beim Start keinen Generationsbezeichner, aber das Unternehmen wird vermutlich eine Nummer an die nächste Version anhängen. (Zum Beispiel wird der Titan M vom Titan M2 abgelöst.)

Es besteht kein Zweifel, dass Google mehr Chips für Telefone herstellt (und es gibt Gerüchte über andere Formfaktoren). Das sagte auch SVP Rick Osterloh bei der Veranstaltung:

Tensor bietet uns auch eine Hardware-Basis, auf der wir in den kommenden Jahren aufbauen werden, damit Sie die persönlichen, hilfreichen Erfahrungen erhalten, die Sie von einem Google-Telefon erwarten.

FTC: Wir verwenden einkommensverdienende Auto-Affiliate-Links. Mehr.

Weitere Neuigkeiten finden Sie bei 9to5Google auf YouTube: