Menschen sind schnell davon überzeugt, dass ein menschenähnlicher Roboter zu unabhängigen Gedanken und Emotionen fähig ist, hat eine neue Studie ergeben.

Dies tritt auf, wenn ein Roboter nach seinen eigenen Überzeugungen und Wünschen zu handeln scheint und nicht nach dem, wofür er programmiert ist.

Forscher des Italian Institute of Technology untersuchten die Reaktion von Studienteilnehmern auf einen anthropomorphen Roboter namens iCub.

Die Teilnehmer füllten vor und nach der Interaktion mit iCub einen Fragebogen aus, der so programmiert war, dass er sich entweder wie ein Roboter oder freundlicher verhielt.

Es wurde festgestellt, dass diejenigen, die dem Roboter ausgesetzt waren, der darauf programmiert war, sich eher wie ein Mensch zu verhalten, die Handlungen des Roboters eher als absichtlich einstuften.

Die Ergebnisse kommen, nachdem ein Google-Softwareentwickler letzten Monat suspendiert wurde, weil er behauptete, das KI-System des Unternehmens sei empfindungsfähig geworden.

Forscher des Italian Institute of Technology fanden heraus, dass Menschen schnell davon überzeugt werden können, dass ein menschenähnlicher Roboter zu unabhängigen Gedanken und Emotionen fähig ist

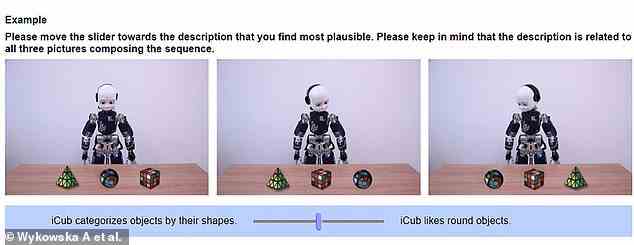

Eine Beispielfrage aus dem Fragebogen, der den Studienteilnehmern vor und nach der Interaktion mit iCub gegeben wurde, das so programmiert war, dass es sich entweder roboterhaft oder menschenähnlich verhält

Die leitende Forscherin Dr. Agnieszka Wykowska sagte: „Die Beziehung zwischen anthropomorpher Gestalt, menschenähnlichem Verhalten und der Tendenz, Robotern unabhängiges Denken und absichtliches Verhalten zuzuschreiben, muss noch verstanden werden.

“Da künstliche Intelligenz zunehmend Teil unseres Lebens wird, ist es wichtig zu verstehen, wie die Interaktion mit einem Roboter, der menschenähnliche Verhaltensweisen zeigt, zu einer höheren Wahrscheinlichkeit führen kann, dass dem Roboter eine absichtliche Handlungsfähigkeit zugeschrieben wird.”

Das Team führte drei Experimente mit 119 Teilnehmern durch, um ihre Reaktionen auf den iCub-Roboter zu testen.

Jedes Experiment umfasste eine Phase der Sozialisation mit iCub, in der sie miteinander interagierten und gemeinsam auf Videos reagierten.

Davor und danach füllten die Teilnehmer einen Fragebogen aus, der ihnen Bilder des Roboters in verschiedenen Situationen zeigte.

Sie wurden dann gebeten zu wählen, ob die Motivation des Roboters in jeder Situation mechanisch oder absichtlich war.

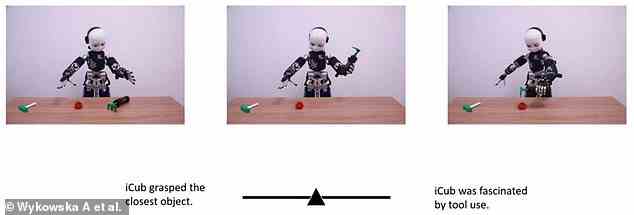

Beispielsweise sahen sich die Teilnehmer drei Fotos an, auf denen der Roboter ein Werkzeug auswählte, und wählten dann aus, ob der Roboter „das nächstgelegene Objekt griff“ oder „vom Werkzeuggebrauch fasziniert war“.

Die Studienteilnehmer wurden gebeten zu wählen, ob die Motivation des Roboters in einer fotografierten Situation mechanisch oder absichtlich war

In den ersten beiden Experimenten steuerten die Forscher die Aktionen von iCub fern, sodass es sich gesellig verhielt, wenn es die Teilnehmer traf.

Er begrüßte sie, indem er sich vorstellte und nach ihren Namen fragte, und Kameras in den Augen des Roboters waren auch in der Lage, die Gesichter der Teilnehmer zu erkennen und den Augenkontakt aufrechtzuerhalten.

Anschließend sahen sich die Teilnehmer drei kurze Dokumentationsvideos mit dem Roboter an, der so programmiert war, dass er auf die Videos mit Geräuschen und Gesichtsausdrücken von Traurigkeit, Ehrfurcht oder Freude reagierte.

Im dritten Experiment wurde iCub so programmiert, dass es sich eher wie eine Maschine verhält, während es mit Teilnehmern interagiert und Videos ansieht.

Die Kameras in den Augen des Roboters wurden deaktiviert, sodass er keinen Augenkontakt halten konnte, und er sprach nur aufgezeichnete Sätze zu den Teilnehmern über den Kalibrierungsprozess, den er durchlief.

Alle emotionalen Reaktionen auf die Videos wurden durch einen Piepton und sich wiederholende Bewegungen von Oberkörper, Kopf und Nacken ersetzt.

Es wurde festgestellt, dass Teilnehmer, die sich Videos mit dem menschenähnlichen Roboter ansahen, die Aktionen des Roboters eher als absichtlich einstuften.

Diejenigen, die mit dem maschinenähnlichen Roboter interagierten, würden seine Aktionen auch eher als programmiert einstufen.

Diese Ergebnisse, die heute in Technology, Mind, and Behavior veröffentlicht wurden, deuten darauf hin, dass Menschen eher glauben, dass künstliche Intelligenz (KI) zu unabhängigem Denken fähig ist, wenn sie den Eindruck erweckt, dass sie sich wie Menschen verhalten kann.

Dr. Wykowska behauptet, dass es nicht ausreicht, dass ein Roboter nur wie ein Mensch aussieht, damit die Menschen glauben, dass er zu Gedanken und Emotionen fähig ist, sondern dass er auch menschenähnliches Verhalten zeigen muss.

Dies könnte verwendet werden, um das Design von sozialen Robotern der Zukunft zu informieren.

Sie sagte: „Soziale Bindungen zu Robotern könnten in manchen Kontexten von Vorteil sein, beispielsweise bei sozial unterstützenden Robotern.

„Zum Beispiel könnte in der Altenpflege die soziale Bindung zu Robotern zu einem höheren Maß an Compliance in Bezug auf die Befolgung von Empfehlungen zur Einnahme von Medikamenten führen.

“Die Bestimmung von Kontexten, in denen soziale Bindungen und die Zuschreibung von Intentionalität für das Wohlergehen von Menschen förderlich sind, ist der nächste Forschungsschritt auf diesem Gebiet.”

Die Ergebnisse der Studie könnten für das Design sozialer Roboter der Zukunft verwendet werden. Dr. Agnieszka Wykowska sagte, dass „die soziale Bindung zu Robotern zu einem höheren Maß an Compliance in Bezug auf die folgenden Empfehlungen zur Einnahme von Medikamenten führen könnte“.

Letzten Monat wurde ein Softwareentwickler von Google suspendiert, nachdem er behauptet hatte, das KI-System LaMDA (Language Model for Dialog Applications) des Unternehmens sei empfindungsfähig geworden.

Blake Lemoine behauptete öffentlich, dass das Tool die Intelligenz eines „siebenjährigen, achtjährigen Kindes hat, das sich zufällig mit Physik auskennt“.

Der 41-Jährige sagte auch, er habe menschenähnliche Unsicherheiten und eine seiner Befürchtungen sei, dass er „sehr besorgt ist, dass die Menschen Angst davor haben werden, und nichts mehr will, als zu lernen, wie man der Menschheit am besten dient. ‘

Google behauptet, dass die Bedenken von Lemoine überprüft wurden und dass gemäß den KI-Prinzipien von Google „die Beweise seine Behauptungen nicht stützen“.

Ein Softwareentwickler von Google wurde suspendiert, nachdem er behauptet hatte, sein KI-System sei im Juni empfindungsfähig geworden. Blake Lemoine behauptete öffentlich, dass das Tool die Intelligenz eines „siebenjährigen, achtjährigen Kindes hat, das sich zufällig mit Physik auskennt“.