Hatten Sie jemals Mühe, Ihrem Freund etwas zu beschreiben, das Sie letzte Nacht im Fernsehen gesehen haben?

Bald könnten Sie Ihre mentalen Bilder auf die große Leinwand projizieren, wie es Wissenschaftler mit Mäusen getan haben.

Ein Team der École Polytechnique Fédérale de Lausanne (EPFL) hat ein Tool für künstliche Intelligenz (KI) entwickelt, das die Gehirnsignale der Nagetiere interpretieren kann.

Der Algorithmus mit dem Namen CEBRA wurde darauf trainiert, die neuronale Aktivität bestimmten Frames in Videos zuzuordnen, sodass er dann vorhersagen und rekonstruieren konnte, was eine Maus betrachtet.

Die Nachricht kommt kurz nachdem Forscher der University of Texas in Austin mithilfe von KI die Gedanken der Menschen in Echtzeit in Text umgewandelt haben.

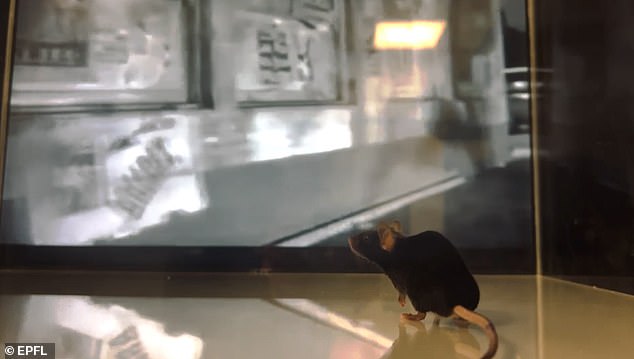

Ein Team der École Polytechnique Fédérale de Lausanne (EPFL) hat ein Tool für künstliche Intelligenz (KI) entwickelt, das die Gehirnsignale der Nagetiere interpretieren kann. Der Originalfilm ist oben abgebildet, während der decodierte Film unten abgebildet ist

Der Algorithmus mit dem Namen CEBRA wurde darauf trainiert, die neuronale Aktivität bestimmten Frames in Videos zuzuordnen, sodass er dann vorhersagen und rekonstruieren konnte, was eine Maus betrachtet

Dr. Mackenzie Mathis, die Hauptforscherin der Studie, sagte gegenüber MailOnline: „Da CEBRA nicht auf das Sehen beschränkt ist, halten wir es in Zukunft für ein leistungsstarkes Werkzeug für Gehirn-Maschine-Schnittstellen.

„Zum Beispiel könnte es zur Steuerung von Computer-Cursorn bei Patienten verwendet werden, die sich nicht bewegen können, oder es könnte verwendet werden, um visuellen Empfindungen bei Sehbehinderten zu helfen, wenn es mit einer Echtzeit-Stimulation des Gehirns gekoppelt ist.

‘Natürlich kann ich das nicht vollständig vorhersagen und es dauert noch Jahre, aber ich freue mich, dass die Leute CEBRA für diese Bereiche verwenden.’

Für die heute in Nature veröffentlichte Studie trainierten die Forscher CEBRA anhand von Filmen, die von Mäusen angesehen wurden, und ihrer Gehirnaktivität in Echtzeit.

Ein Teil der Aktivität wurde direkt mit Elektrodensonden gemessen, die in den visuellen Kortexbereich des Gehirns eingeführt wurden.

Der Rest wurde mit optischen Sonden an gentechnisch veränderten Mäusen gesammelt, deren Neuronen grün werden, wenn sie aktiviert werden.

Anhand dieser Daten lernte CEBRA, welche Gehirnsignale mit welchen Bildern eines bestimmten Films verbunden sind.

Dann erhielt es eine neue Gehirnaktivität, auf die es zuvor nicht gestoßen war, von einer Maus, die ein etwas anderes Beispiel des Filmclips ansah.

Daraus konnte in Echtzeit vorhergesagt werden, welches Einzelbild die Maus beobachtet hatte, und die Forscher verwandelten diese Daten in einen eigenen Film.

Dr. Matthis sagte gegenüber MailOnline: „Wir sagen nicht jedes Pixel voraus, sondern den Frame.

„Das Wahrscheinlichkeitsniveau wäre 1/900, also ist eine Genauigkeit von über 95 Prozent unserer Meinung nach ziemlich aufregend. Aber diese pixelweise Dekodierung planen wir als nächstes.“

In einem Beispielvideo ist die Maus zu sehen, wie sie sich einen Schwarz-Weiß-Filmclip aus den 1960er Jahren ansieht, in dem ein Mann zu einem Auto rennt, das den Kofferraum öffnet.

Ein separater Bildschirm zeigt, was CEBRA glaubt, was die Maus ansieht, was ein nahezu identisches Video ist, wenn auch etwas fehlerhafter.

In einem Beispielvideo (oben) ist die Maus zu sehen, wie sie sich einen Schwarz-Weiß-Filmclip aus den 1960er Jahren ansieht, in dem ein Mann zu einem Auto rennt, der den Kofferraum öffnet. Ein separater Bildschirm (unten) zeigt, was CEBRA glaubt, was die Maus ansieht, was ein nahezu identisches Video ist, wenn auch etwas fehlerhafter

Der Algorithmus ist dazu in der Lage, Daten von nur einem Prozent der Neuronen im visuellen Kortex einer Maus zu verwenden, was etwa 0,5 Millionen Neuronen entspricht.

„Wir wollten zeigen, wie wenige Daten – sowohl in Bezug auf Filmclips als auch neuronale Daten – wir verwenden konnten“, sagte Dr. Mathis gegenüber MailOnline.

„Das macht es viel realistischer für klinische Anwendungen in der Zukunft.

“Bemerkenswerterweise kann der Algorithmus in Echtzeit ausgeführt werden, sodass das Modell weniger als eine Sekunde benötigt, um den gesamten Videoclip vorherzusagen.”

Die Forscher sagen, dass CEBRA nicht darauf beschränkt ist, visuelle Informationen aus Gehirndaten zu interpretieren.

Es kann damit auch Armbewegungen bei Primaten vorhersagen und bestimmen, wo sich eine Ratte in ihrem Gehege befindet, während sie frei herumläuft.

Dr. Mathis sagte: „[CEBRA] kann uns auch einen Einblick geben, wie das Gehirn Informationen verarbeitet, und könnte eine Plattform für die Entdeckung neuer Prinzipien in der Neurowissenschaft sein, indem Daten über Tiere und sogar Arten hinweg kombiniert werden.

Die Forscher sagen, dass CEBRA nicht darauf beschränkt ist, visuelle Informationen aus Gehirndaten zu interpretieren. Es kann damit auch Armbewegungen bei Primaten vorhersagen und bestimmen, wo sich eine Ratte in ihrem Gehege befindet, während sie frei herumläuft

“Die potenziellen klinischen Anwendungen sind spannend.”

Eine ähnliche Technologie wurde letzten Monat von einem Team der Universität Osaka vorgestellt, das mit menschlichen Gehirndaten arbeitet.

Ihr KI-gestützter Algorithmus rekonstruierte rund 1.000 Bilder, darunter einen Teddybären und ein Flugzeug, aus Gehirnscans mit einer Genauigkeit von 80 Prozent.

Es verwendete das beliebte Stable Diffusion-Modell, das in DALL-E 2 von OpenAI enthalten ist und beliebige Bilder basierend auf Texteingaben erstellen kann.

Die Forscher zeigten den Teilnehmern einzelne Bildsätze und sammelten fMRT-Scans (funktionelle Magnetresonanztomographie), die die KI dann entschlüsselte.

In ähnlicher Weise haben Wissenschaftler der University of Texas in Austin erst diese Woche eine Technologie enthüllt, die die Gehirnaktivität einer Person in Text umwandelt.

Drei Studienteilnehmer hörten sich Geschichten an, während sie in einem MRT-Gerät lagen, während ein KI-betriebener „Decoder“ ihre Gehirnaktivität analysierte.

Anschließend wurden sie gebeten, eine andere Geschichte vorzulesen oder sich eine eigene auszudenken, und der Decoder konnte dann die MRT-Daten in Echtzeit in Text umwandeln.

Der Durchbruch wirft Bedenken hinsichtlich der „mentalen Privatsphäre“ auf, da dies der erste Schritt sein könnte, um die Gedanken anderer belauschen zu können.