Der schlimmste Feind des Menschen: Killer-Roboterhunde, die vom Verstand der Soldaten kontrolliert werden, werden von der australischen Armee vor Gericht gestellt

Soldaten, die einen Roboterhund mit ihren Gedanken steuern, während sie eine staubige Straße patrouillieren und ein entfettetes Gebäude fegen, mögen wie Science-Fiction klingen, aber es ist die Szene einer Demonstration in der realen Welt.

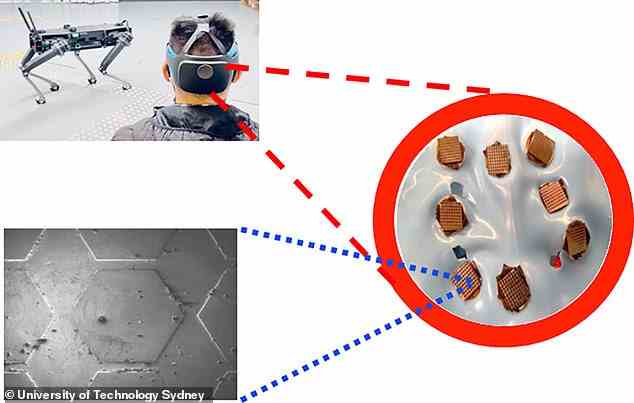

Die australische Armee hat die Fähigkeiten zur Gedankenkontrolle mit acht Sensoren perfektioniert, die ordentlich in einen Helm gepackt sind und mit einer Microsoft HoloLens zusammenarbeiten.

Die Innovation umfasst einen KI-Decoder, der die Gehirnsignale eines Soldaten in erklärbare Anweisungen übersetzt, die an den Roboter-Vierbeiner gesendet werden, sodass sich der Mensch auf seine Umgebung konzentrieren kann.

Ein neues Video zeigt Militärpersonal, das eine simulierte Patrouillenräumung mit dem Roboterhund durchführt, der angewiesen wurde, eine Einrichtung zu säubern, indem er das liest, was er aus den Gehirnwellen einer Person liest – und das mit einer Genauigkeit von 94 Prozent.

Die australische Armee hat ein Update ihres Gedankenkontrollsystems vorgestellt, das Roboterhunde auf dem Schlachtfeld antreibt

Das System wurde von der University of Technology Sydney entwickelt, die die Innovation letztes Jahr erstmals vorgestellt, aber kürzlich ein neues Papier veröffentlicht hat, in dem die Arbeit detailliert beschrieben wird.

“Der Benutzer verwendete unsere Augmented Brain-Robot Interface (aBRI)-Plattform, um die Robotersysteme zu steuern”, heißt es in dem von der American Chemical Society am 16. März veröffentlichten Papier.

“Die aBRI-Plattform ermöglicht es dem Benutzer, mit Maschinen/Robotern auf natürlichere Weise zu interagieren, was besser ist als die herkömmliche Brain-Computer-Interface (BCI)-Anwendungseinstellung, bei der die Benutzer stationär bleiben müssen.”

Forscher beschrieben die aBRI-Plattform mit vier Hauptkomponenten: Geräte für Schnittstellen, ein mobiles Elektroenzephalogramm (EEG)-System, ein Einplatinencomputer und ein Robotersystem.’

Die letztes Jahr angekündigte vorherige Arbeit demonstrierte die Technologie, die EEG-Signale „aus der Stirnregion des Kopfes unter Verwendung von nichtinvasiven epitaxialen Graphen-(EG)-Sensoren auf Siliziumkarbid (SiC) auf Silizium mit einer ungemusterten Oberfläche sammelt“.

Das jüngste Update zeigte den Wert von Brain-Machine-Interfaces, die Anweisungen aus dem Okzipitallappen wahrnehmen, der für die visuelle Wahrnehmung wie Farbe, Form und Bewegung verantwortlich ist.

Der menschliche Controller muss sich nur vorstellen, in welche Richtung sich der Roboter bewegen soll und die Maschine folgt.

Die Technologie ermöglicht es Soldaten, die Roboter freihändig zu steuern, was ideal für den Kampf ist.

Das jüngste Update zeigte den Wert von Brain-Machine-Interfaces, die Anweisungen aus dem Okzipitallappen wahrnehmen, der für die visuelle Wahrnehmung wie Farbe, Form und Bewegung verantwortlich ist

Es verfügt über acht Sensoren, die ordentlich in einen Helm gepackt sind, der auf dem Hinterkopf sitzt und mit einer Microsoft HoloLens zusammenarbeitet

Sergeant Damian Robinson vom 5th Combat Service Support Battalion, der das HoloLens-Headset getestet hat, sagte in einer Erklärung: „Der gesamte Prozess ist nicht schwer zu meistern. Es ist sehr intuitiv. Es dauerte nur ein paar Sitzungen.

„Es ist eher eine Sache der visuellen Konzentration.

“Sie müssen nichts Bestimmtes denken, um den Roboter zu bedienen, aber Sie müssen sich auf dieses Flackern konzentrieren.”

Das Flackern ist ein Leuchtfeuer in den HoloLens-Headsets, die als Markierungen dienen, auf die sich der Roboterhund zubewegt, um ihn auf Kurs zu halten.

„Das Potenzial des Projekts ist sehr breit“, sagte Robinson.

“Im Kern übersetzt es Gehirnströme in Nullen und Einsen, und das kann in einer Reihe verschiedener Systeme implementiert werden.”