Cambridge-Forscher warnen vor den psychologischen Gefahren von „Deadbots“, einer KI, die verstorbene Personen nachahmt, und fordern ethische Standards und Einwilligungsprotokolle, um Missbrauch zu verhindern und einen respektvollen Umgang zu gewährleisten.

Laut Forschern der Universität Cambridge besteht bei künstlicher Intelligenz, die es Benutzern ermöglicht, Text- und Sprachgespräche mit verlorenen Angehörigen zu führen, die Gefahr, psychischen Schaden anzurichten und die Zurückgebliebenen ohne Design-Sicherheitsstandards sogar digital zu „heimsuchen“.

„Deadbots“ oder „Griefbots“ sind KI-Chatbots, die anhand der von ihnen hinterlassenen digitalen Fußabdrücke die Sprachmuster und Persönlichkeitsmerkmale der Toten simulieren. Einige Unternehmen bieten diese Dienste bereits an und ermöglichen so eine völlig neue Art der „Post-Mortem-Präsenz“.

KI-Ethiker vom Leverhulme Centre for the Future of Intelligence in Cambridge skizzieren drei Design-Szenarien für Plattformen, die als Teil der sich entwickelnden „digitalen Afterlife-Industrie“ entstehen könnten, um die möglichen Folgen von nachlässigem Design in einem Bereich der KI aufzuzeigen, den sie als „hohes Risiko“ bezeichnen .“

Missbrauch von KI-Chatbots

Die Forschung, veröffentlicht in der Zeitschrift Philosophie und Technologieunterstreicht das Potenzial für Unternehmen, Deadbots zu verwenden, um heimlich Produkte für Benutzer zu bewerben, wie es bei einem verstorbenen geliebten Menschen der Fall ist, oder Kinder zu beunruhigen, indem sie darauf bestehen, dass ein toter Elternteil immer noch „bei Ihnen“ ist.

Wenn sich die Lebenden anmelden, um nach ihrem Tod virtuell neu erschaffen zu werden, könnten die daraus resultierenden Chatbots von Unternehmen genutzt werden, um überlebende Familienangehörige und Freunde mit unerwünschten Benachrichtigungen, Erinnerungen und Aktualisierungen über die von ihnen angebotenen Dienste zuzuspammen – so als würden sie digital „von den Toten gestalkt“. .“

Sogar diejenigen, die sich zunächst von einem „Deadbot“ trösten lassen, können durch tägliche Interaktionen ausgelaugt werden, die zu einer „überwältigenden emotionalen Belastung“ werden, argumentieren Forscher, könnten aber auch nicht in der Lage sein, eine KI-Simulation aussetzen zu lassen, wenn ihr inzwischen verstorbener geliebter Mensch eine längere Vertragslaufzeit unterschreibt Vertrag mit einem digitalen Jenseitsdienst.

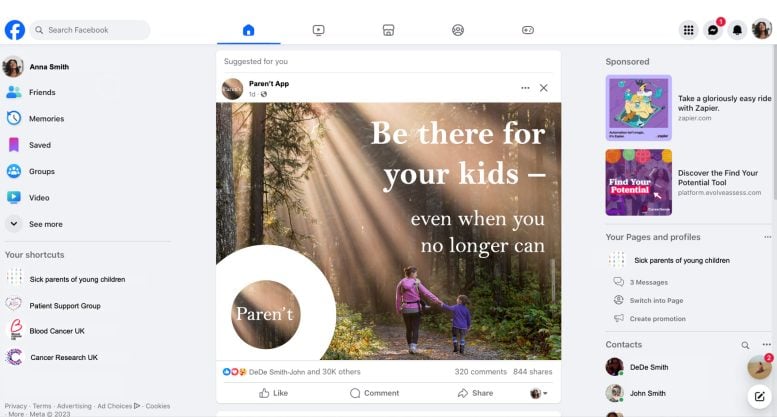

Eine Visualisierung eines fiktiven Unternehmens namens MaNana, eines der in der Arbeit verwendeten Entwurfsszenarien, um die potenziellen ethischen Probleme in der aufstrebenden digitalen Jenseitsbranche zu veranschaulichen. Bildnachweis: Dr. Tomasz Hollanek

„Rasche Fortschritte in der generativen KI bedeuten, dass fast jeder mit Internetzugang und etwas Grundwissen einen verstorbenen geliebten Menschen wiederbeleben kann“, sagte Dr. Katarzyna Nowaczyk-Basińska, Mitautorin der Studie und Forscherin am Leverhulme Centre for the Future of Intelligence in Cambridge ( LCFI). „Dieser Bereich der KI ist ein ethisches Minenfeld. Es ist wichtig, die Würde des Verstorbenen in den Vordergrund zu stellen und sicherzustellen, dass diese nicht durch finanzielle Motive, beispielsweise durch digitale Jenseitsdienste, beeinträchtigt wird. Gleichzeitig kann eine Person eine KI-Simulation als Abschiedsgeschenk für geliebte Menschen hinterlassen, die nicht bereit sind, ihre Trauer auf diese Weise zu verarbeiten. Die Rechte sowohl der Datenspender als auch derjenigen, die mit KI-Diensten nach dem Tod interagieren, sollten gleichermaßen geschützt werden.“

Bestehende Dienste und hypothetische Szenarien

Es gibt bereits Plattformen, die gegen eine geringe Gebühr die Nachbildung von Toten mit KI anbieten, etwa „Project December“, das zunächst GPT-Modelle nutzte, bevor es eigene Systeme entwickelte, und Apps wie „HereAfter“. Ähnliche Dienste sind auch in China entstanden. Eines der möglichen Szenarien in dem neuen Papier ist „MaNana“: ein konversationsbasierter KI-Dienst, der es Menschen ermöglicht, einen Deadbot zu erstellen, der ihre verstorbene Großmutter simuliert, ohne die Zustimmung des „Datenspenders“ (des toten Großelternteils).

Das hypothetische Szenario sieht vor, dass ein erwachsenes Enkelkind, das zunächst von der Technologie beeindruckt und getröstet ist, nach Abschluss einer „Premium-Testversion“ Werbung erhält. Zum Beispiel der Chatbot, der in der Stimme und im Stil des Verstorbenen vorschlägt, bei Essenslieferdiensten zu bestellen. Der Verwandte hat das Gefühl, die Erinnerung an seine Großmutter missachtet zu haben, und möchte, dass der Deadbot ausgeschaltet wird, aber auf sinnvolle Weise – etwas, was die Dienstleister nicht berücksichtigt haben.

Eine Visualisierung eines fiktiven Unternehmens namens Paren’t. Bildnachweis: Dr. Tomasz Hollanek

„Menschen könnten mit solchen Simulationen starke emotionale Bindungen entwickeln, was sie besonders anfällig für Manipulation macht“, sagte Co-Autor Dr. Tomasz Hollanek, ebenfalls vom LCFI in Cambridge. „Es sollten Methoden und sogar Rituale in Betracht gezogen werden, um Deadbots auf würdige Weise in den Ruhestand zu schicken. Dabei kann es sich je nach gesellschaftlichem Kontext beispielsweise um eine Form der digitalen Beerdigung oder andere Arten von Zeremonien handeln. Wir empfehlen, Protokolle zu entwerfen, die verhindern, dass Deadbots auf respektlose Weise genutzt werden, etwa für Werbung oder eine aktive Präsenz in sozialen Medien.“

Während Hollanek und Nowaczyk-Basińska sagen, dass Designer von Erholungsdiensten aktiv die Einwilligung der Datenspender einholen sollten, bevor sie verabschieden, argumentieren sie, dass ein Verbot von Deadbots, die auf nicht zustimmenden Spendern basieren, nicht durchführbar wäre.

Sie schlagen vor, dass Designprozesse eine Reihe von Aufforderungen an diejenigen beinhalten sollten, die ihre Lieben „wiederbeleben“ möchten, wie zum Beispiel „Haben Sie jemals mit X darüber gesprochen, wie sie in Erinnerung bleiben möchten?“, damit die Würde der Verstorbenen im Vordergrund steht in der Deadbot-Entwicklung.

Altersbeschränkungen und Transparenz

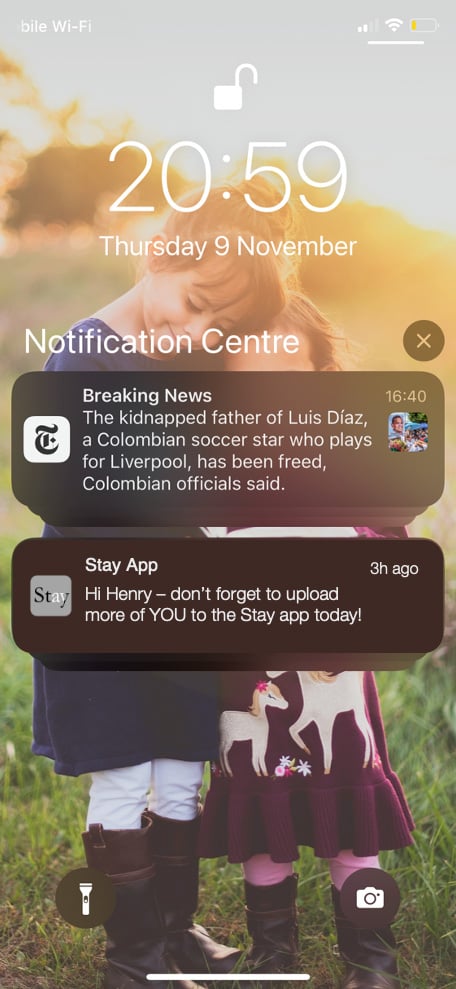

Ein weiteres in der Zeitung vorgestelltes Szenario, ein imaginäres Unternehmen namens „Paren’t“, beleuchtet das Beispiel einer todkranken Frau, die einen Deadbot zurücklässt, um ihrem achtjährigen Sohn bei der Trauerbewältigung zu helfen.

Während der Deadbot zunächst als therapeutisches Hilfsmittel dient, beginnt die KI, verwirrende Reaktionen zu erzeugen, während sie sich an die Bedürfnisse des Kindes anpasst, beispielsweise durch die Darstellung einer bevorstehenden persönlichen Begegnung.

Eine Visualisierung eines fiktiven Unternehmens namens Stay. Bildnachweis: Dr. Tomasz Hollanek

Die Forscher empfehlen Altersbeschränkungen für Deadbots und fordern außerdem „sinnvolle Transparenz“, um sicherzustellen, dass Benutzer stets wissen, dass sie mit einer KI interagieren. Diese könnten beispielsweise aktuellen Warnhinweisen zu Inhalten ähneln, die zu Anfällen führen können.

Das letzte in der Studie untersuchte Szenario – ein fiktives Unternehmen namens „Stay“ – zeigt eine ältere Person, die sich heimlich auf einen Deadbot ihrer selbst einlässt und für ein zwanzigjähriges Abonnement bezahlt, in der Hoffnung, dass dies ihre erwachsenen Kinder tröstet und es ihren Enkelkindern ermöglicht kenne sie.

Nach dem Tod beginnt der Dienst. Ein erwachsenes Kind nimmt nicht teil und erhält eine Flut von E-Mails mit der Stimme seines verstorbenen Elternteils. Ein anderer tut es, ist aber am Ende emotional erschöpft und von Schuldgefühlen über das Schicksal des Deadbots geplagt. Doch die Sperrung des Deadbots würde gegen die Bedingungen des Vertrags verstoßen, den ihre Eltern mit dem Serviceunternehmen unterzeichnet haben.

„Es ist von entscheidender Bedeutung, dass digitale Jenseitsdienste die Rechte und Zustimmung nicht nur derjenigen berücksichtigen, die sie nachbilden, sondern auch derjenigen, die mit den Simulationen interagieren müssen“, sagte Hollanek.

„Diese Dienste laufen Gefahr, den Menschen großen Kummer zu bereiten, wenn sie unerwünschter digitaler Verfolgung durch alarmierend genaue KI-Nachbildungen ihrer Verstorbenen ausgesetzt sind.“ Die möglichen psychologischen Auswirkungen könnten, insbesondere in einer ohnehin schwierigen Zeit, verheerend sein.“

Die Forscher fordern die Designteams auf, Opt-out-Protokolle zu priorisieren, die es potenziellen Benutzern ermöglichen, ihre Beziehungen zu Deadbots auf eine Weise zu beenden, die einen emotionalen Abschluss herbeiführt.

Nowaczyk-Basińska fügte hinzu: „Wir müssen jetzt darüber nachdenken, wie wir die sozialen und psychologischen Risiken der digitalen Unsterblichkeit mindern, denn die Technologie ist bereits vorhanden.“

Referenz: „Griefbots, Deadbots, Postmortem Avatars: on Responsible Applications of Generative AI in the Digital Afterlife Industry“ von Tomasz Hollanek und Katarzyna Nowaczyk-Basińska, 9. Mai 2024, Philosophie & Technologie.

DOI: 10.1007/s13347-024-00744-w