Dank eines neuen KI-Tools von Microsoft wird die Grenze zwischen Realität und Unrealität immer dünner.

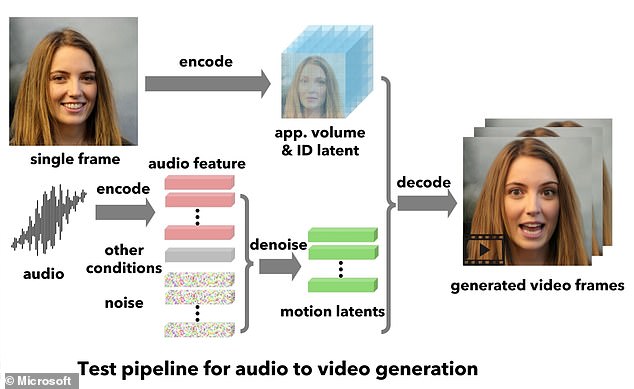

Die als VASA-1 bezeichnete Technologie verwandelt ein Standbild des Gesichts einer Person in einen animierten Clip, in dem sie spricht oder singt.

Lippenbewegungen seien „exquisit synchronisiert“ mit dem Ton, um den Eindruck zu erwecken, als sei das Thema zum Leben erwacht, behauptet der Technologieriese.

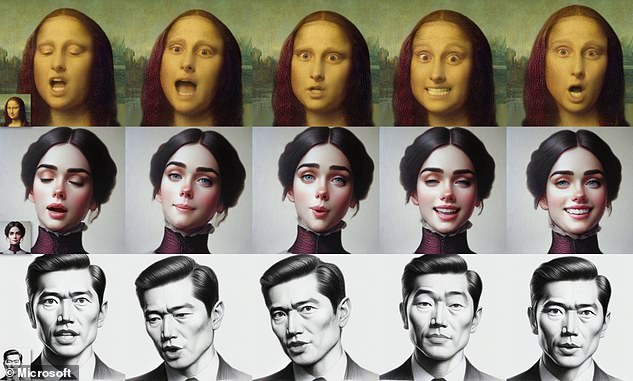

In einem Beispiel beginnt Leonardo da Vincis Meisterwerk „Die Mona Lisa“ aus dem 16. Jahrhundert grob mit amerikanischem Akzent zu rappen.

Allerdings räumt Microsoft ein, dass das Tool „zur Nachahmung von Menschen missbraucht werden könnte“ und gibt es nicht der Öffentlichkeit zugänglich.

Microsofts neues Tool VASA-1 kann aus einem Standbild und einem Ton einer sprechenden Person Clips von sprechenden Personen erstellen – der Technologieriese wird es jedoch nicht so schnell veröffentlichen

VASA-1 nimmt ein statisches Bild eines Gesichts auf – sei es ein Foto einer realen Person oder ein Kunstwerk oder eine Zeichnung einer fiktiven Person.

Anschließend wird dies „akribisch“ mit der Sprachaufnahme „jeder Person“ abgeglichen, um das Gesicht zum Leben zu erwecken.

Die KI wurde mit einer Bibliothek von Gesichtsausdrücken trainiert, die es ihr sogar ermöglicht, das Standbild sogar in Echtzeit zu animieren – also während der Ton gesprochen wird.

In einem Blogbeitrag beschreiben Microsoft-Forscher VASA als „Framework zur Erzeugung lebensechter sprechender Gesichter virtueller Charaktere“.

„Es ebnet den Weg für Echtzeit-Interaktionen mit lebensechten Avataren, die menschliches Gesprächsverhalten nachahmen“, sagen sie.

„Unsere Methode ist nicht nur in der Lage, eine wertvolle Lippen-Audio-Synchronisation zu erzeugen, sondern auch ein großes Spektrum an Emotionen und ausdrucksstarken Gesichtsnuancen sowie natürlichen Kopfbewegungen einzufangen, die zur Wahrnehmung von Realismus und Lebendigkeit beitragen.“

Was die Anwendungsfälle betrifft, glaubt das Team, dass VASA-1 es digitalen KI-Avataren ermöglichen könnte, „auf eine Art und Weise mit uns in Kontakt zu treten, die so natürlich und intuitiv ist wie Interaktionen mit echten Menschen“.

Aber Experten haben ihre Besorgnis über die Technologie geäußert, die, wenn sie veröffentlicht würde, den Eindruck erwecken könnte, dass Menschen Dinge sagen, die sie nie gesagt haben.

VASA-1 erfordert ein statisches Bild eines Gesichts – sei es ein Foto einer realen Person oder ein Kunstwerk oder eine Zeichnung einer imaginären Person. Es gleicht dies „akribisch“ mit Sprachaufnahmen „jeder Person“ ab, um das Gesicht zum Leben zu erwecken

Das Microsoft-Team sagte, VASA-1 sei „nicht dazu gedacht, Inhalte zu erstellen, die zur Irreführung oder Täuschung dienen“.

Ein weiteres potenzielles Risiko ist Betrug, da Menschen im Internet durch eine gefälschte Nachricht mit dem Bild einer Person, der sie vertrauen, getäuscht werden könnten.

Jake Moore, ein Sicherheitsspezialist bei ESET, sagte: „Sehen heißt definitiv nicht mehr glauben.“

„Während sich diese Technologie verbessert, ist es ein Wettlauf gegen die Zeit, um sicherzustellen, dass sich jeder darüber im Klaren ist, was möglich ist, und dass er es sich zweimal überlegen sollte, bevor er Korrespondenz als echt akzeptiert“, sagte er gegenüber MailOnline.

Die Microsoft-Experten gingen von Bedenken aus, die die Öffentlichkeit haben könnte, und sagten, VASA-1 sei „nicht dazu gedacht, Inhalte zu erstellen, die zur Irreführung oder Täuschung dienen“.

„Wie andere verwandte Techniken zur Inhaltsgenerierung könnte es jedoch immer noch missbraucht werden, um sich als Menschen auszugeben“, fügen sie hinzu.

„Wir lehnen jedes Verhalten ab, das zur Erstellung irreführender oder schädlicher Inhalte realer Personen führt, und sind daran interessiert, unsere Technik zur Weiterentwicklung der Fälschungserkennung einzusetzen.“

„Derzeit enthalten die mit dieser Methode erzeugten Videos noch identifizierbare Artefakte, und die numerische Analyse zeigt, dass es noch eine Lücke gibt, um die Authentizität echter Videos zu erreichen.“

Microsoft räumt ein, dass die bestehenden Techniken noch weit davon entfernt sind, „die Authentizität natürlich sprechender Gesichter zu erreichen“, aber die Fähigkeiten der KI wachsen schnell.

Unabhängig vom Gesicht im Bild kann das Tool realistische Gesichtsausdrücke erzeugen, die zu den Geräuschen der gesprochenen Wörter passen

Laut Forschern der Australian National University wirken künstliche Gesichter realistischer als menschliche Gesichter.

Diese Experten warnten, dass KI-Darstellungen von Menschen dazu neigen, einen „Hyperrealismus“ zu haben, mit Gesichtern, die unverhältnismäßiger sind, und dass die Menschen dies als Zeichen von Menschlichkeit verwechseln.

Eine weitere Studie von Experten der Lancaster University ergab, dass gefälschte KI-Gesichter vertrauenswürdiger erscheinen, was Auswirkungen auf den Online-Datenschutz hat.

Unterdessen stellte OpenAI, der Erfinder des berühmten ChatGPT-Bots, im Februar sein „erschreckendes“ Text-zu-Video-Tool Sora vor, mit dem ultrarealistische KI-Videoclips ausschließlich auf der Grundlage kurzer, beschreibender Textaufforderungen erstellt werden können.

Dieses Bild eines KI-generierten Videos von Tokio, erstellt von Sora von OpenAI, schockierte Experten mit seinem „erschreckenden“ Realismus

Als Reaktion auf die Aufforderung „Eine Katze weckt ihren schlafenden Besitzer und verlangt Frühstück“ gab Sora diesen Film zurück

Auf einer speziellen Seite auf der Website von OpenAI finden Sie eine umfangreiche Galerie der von KI erstellten Filme, von einem Mann, der auf einem Laufband läuft, über Spiegelungen in den Fenstern eines fahrenden Zugs bis hin zu einer Katze, die ihren Besitzer weckt.

Experten warnten jedoch, dass dadurch ganze Branchen wie die Filmproduktion ausgelöscht und im Vorfeld der US-Präsidentschaftswahlen zu einem Anstieg von Deep-Fake-Videos führen könnten.

„Die Idee, dass eine KI ein hyperrealistisches Video erstellen kann, in dem beispielsweise ein Politiker etwas Ungewöhnliches tut, sollte Alarmglocken schrillen lassen, wenn wir in das wahlreichste Jahr der Menschheitsgeschichte eintreten“, sagte Dr. Andrew Rogoyski von der University of Surrey .

Ein Forschungsbericht, der das neue Tool von Microsoft beschreibt, wurde als Vorabdruck veröffentlicht.