Die Idee, künstliche Intelligenz (KI) zu nutzen, um einen toten geliebten Menschen digital wiederzubeleben, klingt vielleicht wie eine Handlung aus der neuesten Folge von Black Mirror.

Aber diese sogenannten „Griefbots“, „Deadbots“ oder „Deathbots“ sind langsam aber sicher Realität geworden, und mehrere Firmen bieten diesen Dienst mittlerweile an.

Jetzt haben Forscher der Universität Cambridge gewarnt, dass diese Bots psychischen Schaden anrichten und die Zurückgebliebenen sogar digital „heimsuchen“ könnten.

„Diese Dienste laufen Gefahr, den Menschen großen Kummer zu bereiten, wenn sie unerwünschter digitaler Verfolgung durch erschreckend genaue KI-Nachbildungen derjenigen ausgesetzt sind, die sie verloren haben“, sagte Co-Autor Dr. Tomasz Hollanek.

„Die möglichen psychologischen Auswirkungen könnten, insbesondere in einer ohnehin schwierigen Zeit, verheerend sein.“

Die Idee, künstliche Intelligenz (KI) zu nutzen, um einen toten geliebten Menschen digital wiederzubeleben, klingt vielleicht wie eine Handlung aus der neuesten Folge von Black Mirror. Aber diese sogenannten „Griefbots“, „Deadbots“ oder „Deathbots“ sind langsam aber sicher Realität geworden, und mehrere Firmen bieten diesen Service inzwischen an (Archivbild)

In ihrer Studie untersuchten Ethiker am Leverhulme Centre for the Future of Intelligence in Cambridge drei hypothetische Szenarien, die wahrscheinlich als Teil der schnell wachsenden „digitalen Afterlife-Industrie“ entstehen werden.

Erstens könnten die Bots genutzt werden, um heimlich für Produkte außerhalb des Grabes oder der Urne zu werben, warnen die Autoren.

Zweitens könnten sie Kinder beunruhigen, indem sie darauf bestehen, dass ein toter Elternteil immer noch „bei Ihnen“ sei.

Und schließlich könnten die Verstorbenen dazu genutzt werden, überlebende Familienangehörige und Freunde mit Erinnerungen und Aktualisierungen über die von ihnen angebotenen Dienste zuzuspammen – ein Szenario, das sie als „Stalking von den Toten“ beschreiben.

Der anfängliche Trost des vertrauten Gesichts des geliebten Menschen könne emotional belastend sein, fügen sie hinzu.

Ein mögliches Szenario – von den Forschern als „Manana“ bezeichnet – ist die Erschaffung einer verstorbenen Großmutter ohne Zustimmung des „Datenspenders“ – des toten Großelternteils

Zu den bestehenden Plattformen, die den digitalen Afterlife-Service anbieten, gehören Project December und Hereafter.

Aber auch mehrere große Player schauen sich den Markt an.

Im Januar 2021 erhielt Microsoft ein Patent für einen Chatbot, der die Daten einer Person nutzen konnte, um „wie jemand zu reagieren, den Sie kennen“.

Dr. Katarzyna Nowaczyk-Basińska, Co-Autorin der Studie, sagte: „Rasche Fortschritte in der generativen KI bedeuten, dass fast jeder mit Internetzugang und etwas Grundwissen einen verstorbenen geliebten Menschen wiederbeleben kann.“

„Dieser Bereich der KI ist ein ethisches Minenfeld.“ Es ist wichtig, die Würde des Verstorbenen in den Vordergrund zu stellen und sicherzustellen, dass diese nicht durch finanzielle Motive, beispielsweise durch digitale Jenseitsdienste, beeinträchtigt wird.

„Gleichzeitig kann eine Person eine KI-Simulation als Abschiedsgeschenk für geliebte Menschen hinterlassen, die nicht bereit sind, ihre Trauer auf diese Weise zu verarbeiten.“

„Die Rechte sowohl der Datenspender als auch derjenigen, die mit KI-Diensten nach dem Tod interagieren, sollten gleichermaßen geschützt werden.“

Ein mögliches Szenario – von den Forschern als „Manana“ bezeichnet – ist die Erschaffung einer verstorbenen Großmutter ohne Zustimmung des „Datenspenders“ – des toten Großelternteils.

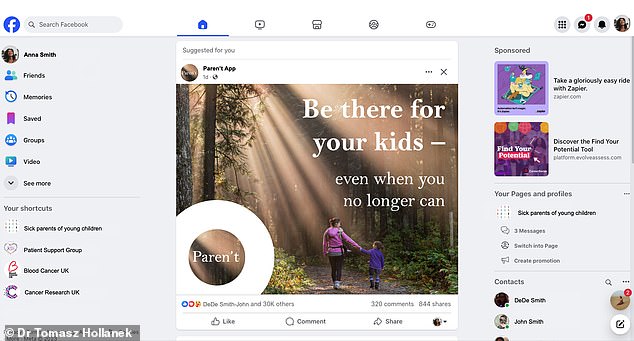

Ein anderes Szenario in der Arbeit – von den Forschern „Paren’t“ genannt – stellt sich eine todkranke Frau vor, die einen Deadbot verlässt, um ihrem achtjährigen Sohn bei der Trauerbewältigung zu helfen

Nach einer anfänglichen Komfortphase beginnt die App möglicherweise, den Benutzer zu belästigen, indem sie beispielsweise in der Stimme und im Stil des Verstorbenen vorschlägt, bei Essenslieferdiensten zu bestellen.

„Mit solchen Simulationen könnten Menschen starke emotionale Bindungen entwickeln, die sie besonders anfällig für Manipulationen machen“, sagte Dr. Hollanek.

„Es sollten Methoden und sogar Rituale in Betracht gezogen werden, um Deadbots auf würdige Weise in den Ruhestand zu schicken.“ Dabei kann es sich je nach gesellschaftlichem Kontext beispielsweise um eine Form der digitalen Beerdigung oder andere Arten von Zeremonien handeln.

„Wir empfehlen, Protokolle zu entwerfen, die verhindern, dass Deadbots auf respektlose Weise genutzt werden, etwa für Werbung oder eine aktive Präsenz in sozialen Medien.“

Während Hollanek und Nowaczyk-Basińska argumentieren, dass Designer die Zustimmung der Datenspender einholen sollten, bevor sie bestehen, behaupten sie, dass ein Verbot von Deadbots, die auf nicht zustimmenden Spendern basieren, nicht durchführbar wäre.

Ein anderes Szenario in der Arbeit – von den Forschern „Paren’t“ genannt – stellt sich eine todkranke Frau vor, die einen Deadbot verlässt, um ihrem achtjährigen Sohn bei der Trauerbewältigung zu helfen.

Während der Deadbot zunächst als therapeutisches Hilfsmittel dient, beginnt die KI, verwirrende Reaktionen zu erzeugen, während sie sich an die Bedürfnisse des Kindes anpasst, beispielsweise durch die Darstellung einer bevorstehenden persönlichen Begegnung.

Die Forscher sagen, dass es sinnvolle Hinweise für die Benutzer geben muss, dass sie es mit einer KI zu tun haben, und fordern auch Altersbeschränkungen für die Deadbots.

Ein letztes Szenario in der Studie geht von dem Fall einer älteren Person aus, die sich heimlich auf einen Deadbot ihrer selbst einlässt und für ein 20-Jahres-Abonnement bezahlt, in der Hoffnung, dass dies ihre erwachsenen Kinder trösten und es ihren Enkelkindern ermöglichen würde, sie kennenzulernen.

Wenn der Gottesdienst nach dem Tod beginnt, nimmt ein erwachsenes Kind nicht teil und erhält eine Flut von E-Mails mit der Stimme seines verstorbenen Elternteils.

Ein anderer engagiert sich zwar, ist aber am Ende emotional erschöpft und von Schuldgefühlen wegen des Schicksals des Deadbots geplagt, vermuten die Forscher.

„Es ist von entscheidender Bedeutung, dass digitale Jenseitsdienste die Rechte und Zustimmung nicht nur derjenigen berücksichtigen, die sie nachbilden, sondern auch derjenigen, die mit den Simulationen interagieren müssen“, sagte Dr. Hollanek.

Dr. Nowaczyk-Basińska fügte hinzu: „Wir müssen jetzt darüber nachdenken, wie wir die sozialen und psychologischen Risiken der digitalen Unsterblichkeit mindern, denn die Technologie ist bereits vorhanden.“