Ein neues Bildschutztool wurde entwickelt, um KI-Programme zu vergiften, die mit nicht autorisierten Daten trainiert werden, und den Urhebern eine neue Möglichkeit zu geben, ihre Stücke zu schützen und Systemen Schaden zuzufügen, von denen sie sagen, dass sie ihre Werke stehlen.

Nightshade, ein neues Tool eines Teams der University of Chicago, fügt Daten in die Pixel eines Bildes ein, die KI-Bildgeneratoren beschädigen, die das Internet auf der Suche nach Bildern zum Trainieren durchsuchen, was dazu führt, dass sie nicht richtig funktionieren. Ein KI-Programm könnte ein durch Nightshade geschütztes Bild eines Hundes beispielsweise als Katze interpretieren, ein Foto eines Autos könnte als Kuh erkannt werden und so weiter, was zu einer Fehlfunktion der Maschine führen könnte, so die Forschung des Teams.

Ein Besucher fotografiert am 9. März 2023 im Mauritshuis-Museum in Den Haag mit seinem Mobiltelefon ein Bild, das der in Berlin ansässige Digitalschöpfer Julian van Dieken mit künstlicher Intelligenz entworfen hat und das von Johannes Vermeers Gemälde „Mädchen mit Perlenohrring“ inspiriert ist. Julian van Diekens mit künstlicher Intelligenz geschaffene Arbeit ist Teil der Sonderinstallation von Fans-Nachbildungen von Johannes Vermeers Gemälde „Mädchen mit dem Perlenohrring“, die im Museum Mauritshuis ausgestellt ist. (SIMON WOHLFAHRT/AFP über Getty Images)

WAS IST KÜNSTLICHE INTELLIGENZ (KI)?

„Nightshades Ziel ist es nicht, zu zerbrechen [AI] Modelle“, Ben Zhao, schrieb der Professor der University of Chicago, der das Nightshade-Team leitet. „Damit sollen Anreize für unautorisierte Datenschulungen geschaffen und legitim lizenzierte Inhalte für Schulungen gefördert werden.“

„Für Modelle, die Opt-outs befolgen und nicht schaben, gibt es nur minimale oder gar keine Auswirkungen“, fuhr er fort.

KÜNSTLERIN VERLAGT KI-BILDGENERATOREN, WEIL SIE IHRE ARBEIT ANGEBLICH ZUM TRAINIEREN VON BOTS VERWENDET HABEN:

WEITERE DIGITALE ORIGINALE VON FOX NEWS SEHEN SIE HIER

Text-zu-Bild-KI-Generatoren wie Midjourney und Stable Diffusion erstellen Bilder basierend auf den Eingabeaufforderungen der Benutzer. Die Programme werden mit Texten und Bildern aus dem Internet und anderen Quellen trainiert.

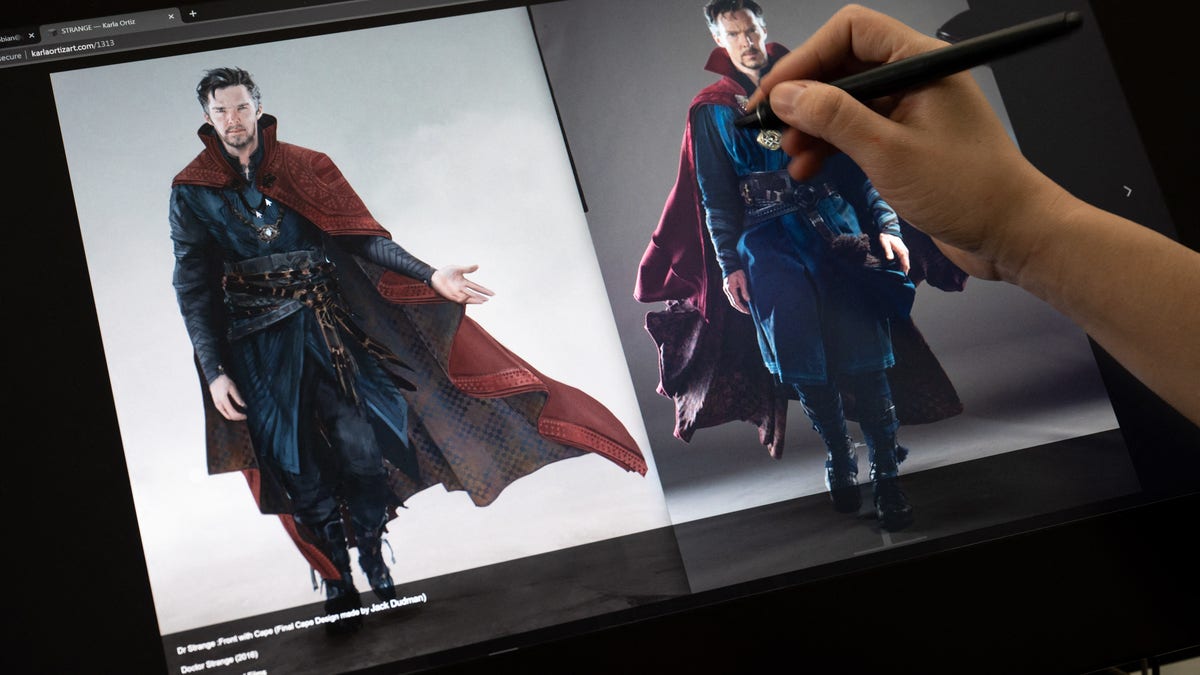

Karla Ortiz, eine in San Francisco ansässige bildende Künstlerin, die angibt, dass ihre Kunstwerke zum Trainieren der Technologie verwendet wurden, reichte im Januar eine Klage gegen Midjourney und Stable Diffusion wegen Urheberrechtsverletzung und Verstößen gegen das Recht auf Veröffentlichung ein. Die Angeklagten beantragten im April die Abweisung des Verfahrens, doch der für den Fall zuständige Bezirksrichter erlaubte den Klägern nach einer Anhörung im Juli, eine neue Beschwerde einzureichen.

„Es fühlt sich an, als hätte jemand alles, wofür man gearbeitet hat, genommen und jemand anderem erlaubt, damit zu machen, was er will, um Profit zu machen“, sagte Ortiz im Mai gegenüber Fox News. „Jemand kann meine Arbeit nachahmen, weil ein Unternehmen es ihnen erlaubt.“

Ein Künstler mit künstlicher Intelligenz namens „Rootport“ trägt Handschuhe, um seine Identität zu schützen, und demonstriert, wie er KI-Kunst produziert. (RICHARD A. BROOKS/AFP über Getty Images)

DAS LETZTE LACHEN: WIE COMEDIANS vorhaben, den Spieß umzudrehen, wenn die KI ihr Material verkratzt

Eine weitere Klägerin der Klage, die in Nashville lebende Künstlerin Kelly McKernan, bemerkte im Internet ähnliche Bilder wie sie selbst, die offenbar durch die Eingabe ihres Namens in KI-Bild-Engines im vergangenen Jahr entstanden waren.

„Letztendlich profitiert jemand von meiner Arbeit“, sagte McKernan. „Wir sind hier David gegen Goliath.“

Um sich dagegen zu wehren, dass KI-Maschinen ihre künstlerischen Stile kapern, arbeiteten McKernan und Ortiz mit Zhao und dem Team der University of Chicago an einem weiteren Kunstschutzprojekt namens Glaze, einem „System, das menschliche Künstler durch die Störung der Stilnachahmung schützen soll“. zu seiner Website.

Wenn Glaze, der Vorgänger von Nightshade, auf ein Bild angewendet wird, verändert es die Art und Weise, wie KI-Maschinen das Bild interpretieren, ohne die Art und Weise zu verändern, wie es für den Menschen aussieht. Aber im Gegensatz zu Nightshade führt Glaze nicht zu Fehlfunktionen des Modells.

Die Illustratorin und Content-Künstlerin Karla Ortiz posiert in ihrem Studio in San Francisco, Kalifornien. (AMY OSBORNE/AFP über Getty Images)

Wie Deepfakes kurz davor stehen, die politische Verantwortung zu zerstören

Dennoch stehen Künstler vor der Herausforderung, ihre Werke vor KI zu schützen.

„Das Problem besteht natürlich darin, dass diese Ansätze nichts für die Milliarden von Inhalten tun, die bereits online veröffentlicht wurden“, sagte Hany Farid, Professor an der University of California, Berkeley’s School of Information, in einer Erklärung gegenüber Fox News. „Die andere Einschränkung bei dieser Art von Ansatz besteht darin, dass die Ersteller ihre Inhalte veröffentlicht haben und keinen Schutz haben, wenn sie gehackt werden – und das wird auch der Fall sein.“

„Das heißt, es entsteht ein etwas falsches Gefühl des Schutzes“, fuhr er fort.

Allerdings habe kein großer KI-Bildgenerator Nightshade gehackt, sagte Zhao.

Auf der Website der Illustratorin und Content-Künstlerin Karla Ortiz sind ein Design und eine Illustration zu sehen, die sie am 8. März 2023 für den Film Doctor Strange in San Francisco, Kalifornien, erstellt hat. Ortiz und zwei weitere Künstler haben eine Sammelklage gegen Unternehmen mit Kunstgenerierung eingereicht Dienstleistungen. (AMY OSBORNE/AFP über Getty Images)

KLICKEN SIE HIER, UM DIE FOX NEWS-APP ZU ERHALTEN

„Uns sind keine Techniken bekannt, die es erkennen könnten“, er schrieb auf X. „Wenn wir welche finden, werden wir Nightshade aktualisieren, um dem zu entgehen.“

Das Team der University of Chicago, Stability AI und Midjourney antworteten nicht auf Anfragen nach Kommentaren.

Um das vollständige Interview mit Ortiz anzusehen, klicken Sie hier.