Was ein SEO-Crawler als fatalen Fehler markiert, muss in vielen Fällen sofort beachtet werden – aber manchmal ist es überhaupt kein Fehler.

Dies kann sogar mit den beliebtesten SEO-Crawling-Tools wie Semrush Site Audit, Ahrefs Site Audit, Sitebulb und Screaming Frog passieren.

Wie können Sie den Unterschied erkennen, um zu vermeiden, dass eine Korrektur priorisiert wird, die nicht durchgeführt werden muss?

Hier sind einige Beispiele aus der Praxis für solche Warnungen und Fehler zusammen mit Erklärungen, warum sie für Ihre Website ein Problem darstellen können.

1. Probleme mit der Indexierbarkeit (Noindex-Seiten auf der Site)

Jeder SEO-Crawler markiert und warnt Sie vor nicht indexierbaren Seiten auf der Website. Je nach Crawler-Typ können Noindex-Seiten als Warnungen, Fehler oder Erkenntnisse markiert werden.

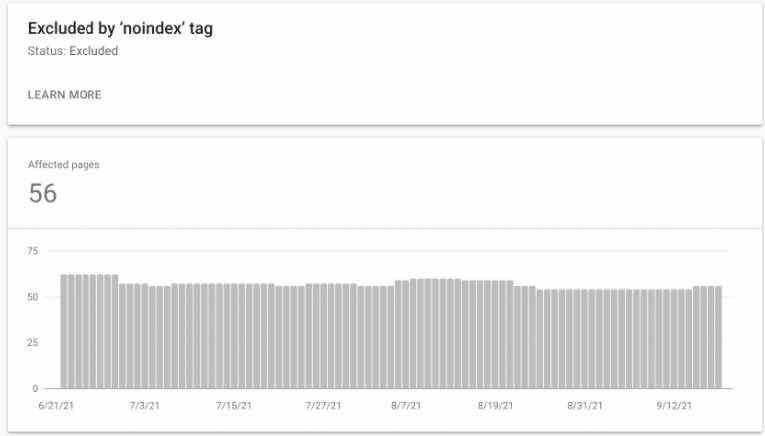

So wird dieses Problem in Ahrefs Site Audit gekennzeichnet:

Der Bericht zur Abdeckung der Google Search Console kann auch nicht indexierbare Seiten als Fehler (wenn die Website nicht indexierbare Seiten in der übermittelten Sitemap enthält) oder Ausgeschlossen markieren, auch wenn es sich nicht um tatsächliche Probleme handelt.

Werbung

Weiter unten lesen

Dies ist wiederum nur die Information, dass diese URLs nicht indexiert werden können.

So sieht es in GSC aus:

Screenshot aus der Google Search Console, September 2021

Screenshot aus der Google Search Console, September 2021Die Tatsache, dass eine URL mit einem „noindex“-Tag versehen ist, bedeutet nicht unbedingt, dass dies ein Fehler ist. Es bedeutet nur, dass die Seite nicht von Google und anderen Suchmaschinen indiziert werden kann.

Das „noindex“-Tag ist eine von zwei möglichen Anweisungen für Crawler, die andere besteht darin, die Seite zu indizieren.

Werbung

Weiter unten lesen

Praktisch jede Website enthält URLs, die nicht von Google indexiert werden sollten.

Dies können beispielsweise Tag-Seiten (und manchmal auch Kategorieseiten), Anmeldeseiten, Seiten zum Zurücksetzen von Passwörtern oder eine Dankesseite sein.

Ihre Aufgabe als SEO-Profi besteht darin, Noindex-Seiten auf der Website zu überprüfen und zu entscheiden, ob sie tatsächlich für die Indexierung gesperrt werden sollen oder ob das „noindex“-Tag versehentlich hinzugefügt worden sein könnte.

2. Meta-Beschreibung zu kurz oder leer

SEO-Crawler überprüfen auch die Meta-Elemente der Website, einschließlich der Meta-Beschreibungselemente. Wenn die Site keine Meta-Beschreibungen hat oder diese zu kurz sind (normalerweise weniger als 110 Zeichen), wird der Crawler sie als Problem markieren.

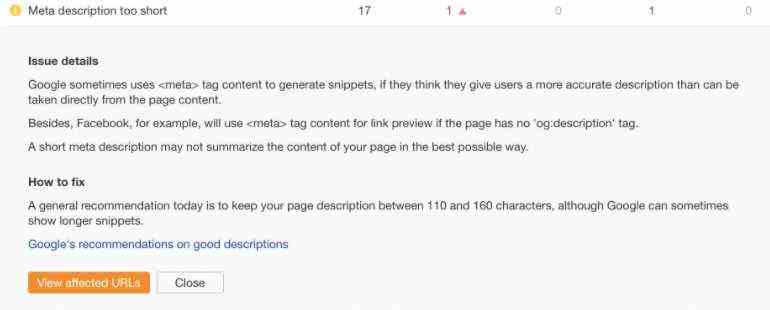

So sieht das in Ahrefs aus:

Screenshot von Ahrefs Site Audit, September 2021

Screenshot von Ahrefs Site Audit, September 2021So zeigt Screaming Frog es an:

Screenshot aus Screaming Frog, September 2021

Screenshot aus Screaming Frog, September 2021Abhängig von der Größe der Site ist es nicht immer möglich und/oder machbar, für alle ihre Webseiten eindeutige Meta-Beschreibungen zu erstellen. Möglicherweise benötigen Sie sie auch nicht.

Ein gutes Beispiel für eine Website, auf der es möglicherweise keinen Sinn ergibt, ist eine riesige E-Commerce-Website mit Millionen von URLs.

Je größer die Site ist, desto weniger wichtig wird dieses Element.

Der Inhalt des Meta-Description-Elements wird im Gegensatz zum Inhalt des Title-Tags von Google nicht berücksichtigt und beeinflusst das Ranking nicht.

Such-Snippets verwenden manchmal die Meta-Beschreibung, werden aber oft von Google umgeschrieben.

Hier ist, was Google in seiner Advanced SEO-Dokumentation dazu zu sagen hat:

„Snippets werden automatisch aus Seiteninhalten erstellt. Snippets sind so konzipiert, dass sie den Seiteninhalt hervorheben und in der Vorschau anzeigen, der sich am besten auf die spezifische Suche eines Benutzers bezieht: Das bedeutet, dass eine Seite möglicherweise unterschiedliche Snippets für verschiedene Suchen anzeigt.“

Was Sie als SEO tun müssen, ist, daran zu denken, dass jede Website anders ist. Verwenden Sie Ihren gesunden Menschenverstand, wenn Sie entscheiden, ob Meta-Beschreibungen für diese bestimmte Website tatsächlich ein Problem darstellen oder ob Sie die Warnung getrost ignorieren können.

Werbung

Weiter unten lesen

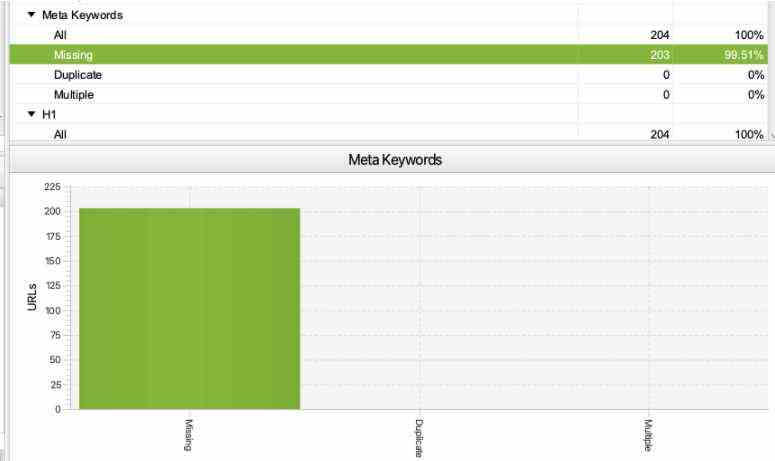

3. Meta-Keywords fehlen

Meta-Keywords wurden vor mehr als 20 Jahren verwendet, um Suchmaschinen wie Altavista anzuzeigen, für welche Schlüsselphrasen eine bestimmte URL ranken wollte.

Dies wurde jedoch stark missbraucht. Meta-Keywords waren eine Art „Spam-Magnet“, sodass die Mehrheit der Suchmaschinen die Unterstützung für dieses Element eingestellt hat.

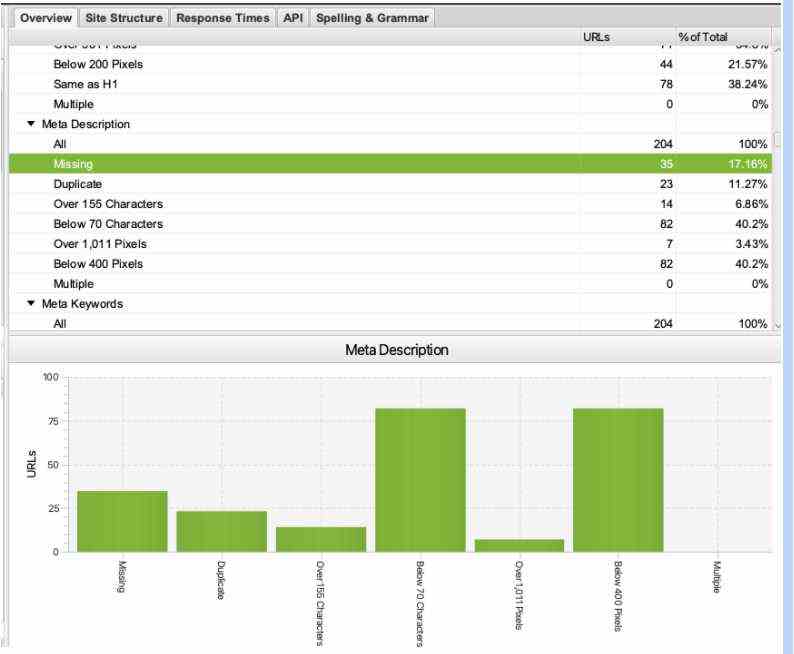

Screaming Frog prüft standardmäßig immer, ob Meta-Keywords auf der Site vorhanden sind.

Da dies ein veraltetes SEO-Element ist, verwenden 99% der Websites keine Meta-Keywords mehr.

So sieht es in Screaming Frog aus:

Screenshot aus Screaming Frog, September 2021

Screenshot aus Screaming Frog, September 2021Neue SEO-Profis oder Kunden könnten verwirrt sein, wenn sie denken, dass, wenn ein Crawler etwas als fehlend markiert, dieses Element tatsächlich der Website hinzugefügt werden sollte. Aber das ist hier nicht der Fall!

Werbung

Weiter unten lesen

Wenn Meta-Keywords auf der von Ihnen geprüften Website fehlen, ist es eine Verschwendung, sie hinzuzufügen.

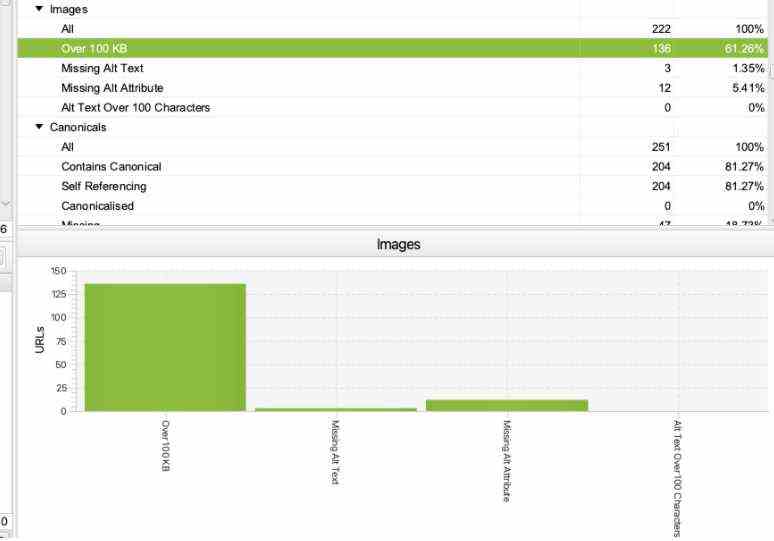

4. Bilder über 100 KB

Es ist wichtig, die auf der Site verwendeten Bilder zu optimieren und zu komprimieren, damit nicht auf jeder Webseite ein riesiges PNG-Logo mit 10 MB Gewicht geladen werden muss.

Es ist jedoch nicht immer möglich, alle Bilder auf unter 100 KB zu komprimieren.

Screaming Frog markiert und warnt Sie immer vor Bildern, die über 100 KB groß sind. So sieht es im Tool aus:

Screenshot aus Screaming Frog, September 2021

Screenshot aus Screaming Frog, September 2021Die Tatsache, dass die Site Bilder mit einer Größe von mehr als 100 KB enthält, bedeutet nicht unbedingt, dass die Site Probleme mit der Bildoptimierung hat oder sehr langsam ist.

Werbung

Weiter unten lesen

Wenn dieser Fehler angezeigt wird, überprüfen Sie die Geschwindigkeit und Leistung der gesamten Website in Google PageSpeed Insights und im Core Web Vitals-Bericht der Google Search Console.

Wenn die Site in Ordnung ist und die Core Web Vitals-Bewertung besteht, müssen die Bilder normalerweise nicht weiter komprimiert werden.

Spitze: Mit diesem Screaming Frog-Bericht können Sie die Bilder nach Größe vom schwersten zum leichtesten sortieren, um zu überprüfen, ob auf bestimmten Webseiten wirklich große Bilder vorhanden sind.

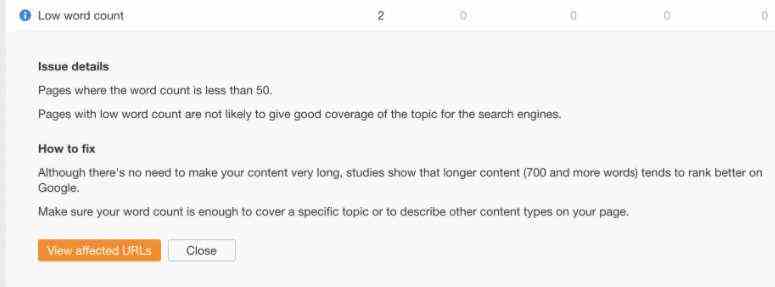

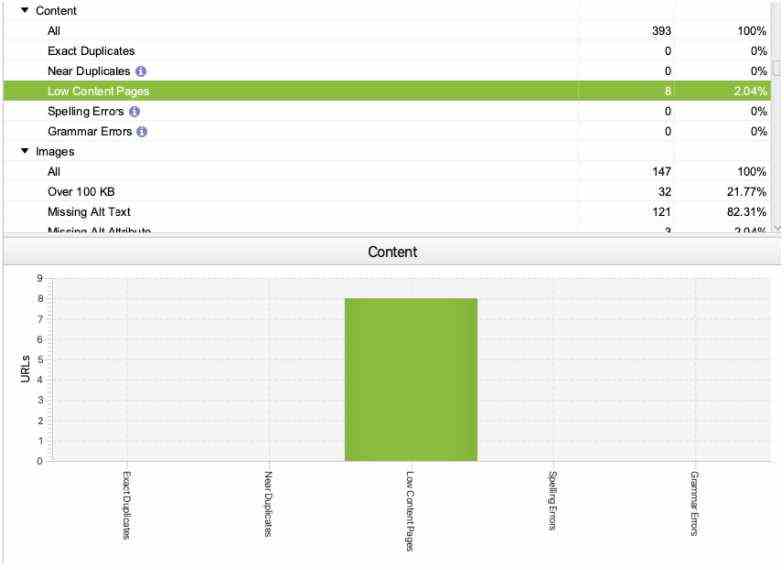

5. Seiten mit geringem Inhalt oder geringer Wortzahl

Abhängig von den Einstellungen des SEO-Crawlers heben die meisten SEO-Audit-Tools Seiten mit weniger als 50-100 Wörtern als Seiten mit geringem Inhalt hervor.

So sieht dieses Problem in Ahrefs aus:

Screenshot von Ahrefs Site Audit, September 2021

Screenshot von Ahrefs Site Audit, September 2021Screaming Frog hingegen betrachtet Seiten mit weniger als 200 Wörtern standardmäßig als Seiten mit geringem Inhalt (Sie können diese Einstellung bei der Konfiguration des Crawls ändern).

Werbung

Weiter unten lesen

So berichtet Screaming Frog darüber:

Screenshot aus Screaming Frog, September 2021

Screenshot aus Screaming Frog, September 2021Nur weil eine Webseite nur wenige Wörter enthält, bedeutet dies nicht, dass es sich um ein Problem oder einen Fehler handelt.

Es gibt viele Arten von Seiten, die eine niedrige Wortzahl aufweisen sollen, darunter einige Anmeldeseiten, Seiten zum Zurücksetzen von Passwörtern, Tag-Seiten oder eine Kontaktseite.

Der Crawler markiert diese Seiten als wenig Inhalt, aber dies ist kein Problem, das ein gutes Ranking der Website bei Google verhindert.

Werbung

Weiter unten lesen

Das Tool versucht Ihnen zu sagen, dass, wenn Sie möchten, dass eine bestimmte Webseite einen hohen Rang bei Google hat und viel organischen Traffic bringt, diese Webseite möglicherweise sehr detailliert und detailliert sein muss.

Dazu gehört oft unter anderem eine hohe Wortzahl. Es gibt jedoch verschiedene Arten von Suchabsichten und die Inhaltstiefe ist nicht immer das, was Benutzer suchen, um ihre Bedürfnisse zu befriedigen.

Denken Sie bei der Überprüfung von Seiten mit geringer Wortzahl, die vom Crawler gekennzeichnet wurden, immer darüber nach, ob diese Seiten wirklich viel Inhalt haben sollen. In vielen Fällen sind sie es nicht.

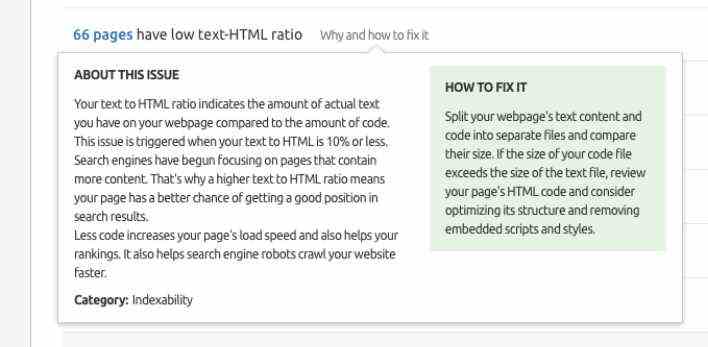

6. Niedriges HTML-Text-Verhältnis

Semrush Site Audit warnt Sie auch über Seiten mit einem niedrigen Text-HTML-Verhältnis.

So berichtet Semrush darüber:

Screenshot vom Semrush Site Audit, September 2021

Screenshot vom Semrush Site Audit, September 2021Diese Warnung soll Ihnen zeigen:

Werbung

Weiter unten lesen

- Seiten mit möglicherweise geringer Wortzahl.

- Seiten, die möglicherweise komplex aufgebaut sind und eine riesige HTML-Codedatei haben.

Diese Warnung verwirrt oft weniger erfahrene oder neue SEO-Profis, und Sie benötigen möglicherweise einen erfahrenen technischen SEO-Profi, um festzustellen, ob Sie sich Sorgen machen müssen.

Es gibt viele Variablen, die das HTML-Text-Verhältnis beeinflussen können, und es ist nicht immer ein Problem, wenn die Site ein niedriges/hohes HTML-Text-Verhältnis hat. Es gibt kein optimales HTML-Text-Verhältnis.

Worauf Sie sich als SEO-Profi stattdessen konzentrieren können, ist sicherzustellen, dass die Geschwindigkeit und Leistung der Website optimal sind.

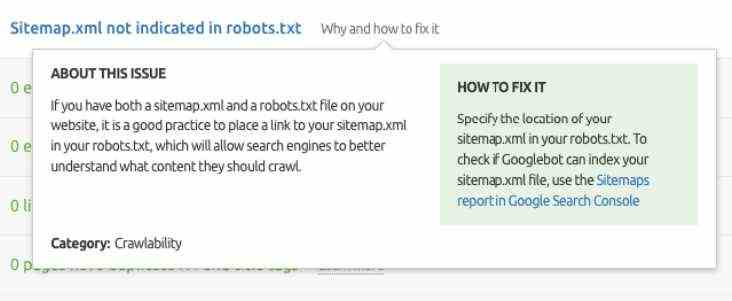

7. XML-Sitemap nicht in robots.txt angegeben

Robots.txt ist nicht nur die Datei mit Crawler-Anweisungen, sondern auch der Ort, an dem Sie die URL der XML-Sitemap angeben können, damit Google sie crawlen und den Inhalt problemlos indizieren kann.

SEO-Crawler wie Semrush Site Audit benachrichtigen Sie, wenn die XML-Sitemap nicht in der robots.txt angezeigt wird.

Werbung

Weiter unten lesen

So berichtet Semrush darüber:

Screenshot vom Semrush Site Audit, September 2021

Screenshot vom Semrush Site Audit, September 2021Auf den ersten Blick sieht dies nach einem ernsten Problem aus, obwohl es in den meisten Fällen nicht so ist, weil:

- Google hat normalerweise keine Probleme beim Crawlen und Indexieren kleinerer Websites (unter 10.000 Seiten).

- Google wird keine Probleme beim Crawlen und Indexieren riesiger Seiten haben, wenn sie eine gute interne Verlinkungsstruktur haben.

- Eine XML-Sitemap muss nicht in der robots.txt angegeben werden, wenn sie korrekt in der Google Search Console eingereicht wurde.

- Eine XML-Sitemap muss nicht in der robots.txt angegeben werden, wenn sie sich am Standardspeicherort befindet – dh /sitemap.xml (in den meisten Fällen).

Bevor Sie dies in Ihrem SEO-Audit als ein Problem mit hoher Priorität markieren, stellen Sie sicher, dass keines der oben genannten Punkte auf die von Ihnen geprüfte Website zutrifft.

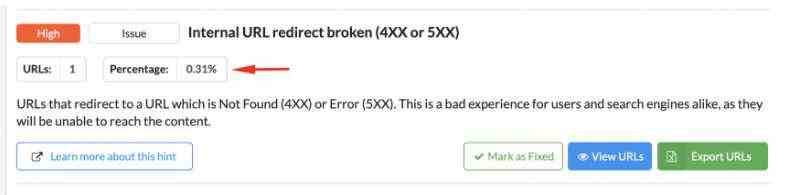

Bonus: Das Tool meldet einen kritischen Fehler, der sich auf wenige unwichtige URLs bezieht

Selbst wenn das Tool ein echtes Problem anzeigt, z. B. eine 404-Seite auf der Site, kann es kein schwerwiegendes Problem sein, wenn eine von Millionen von Webseiten auf der Site den Status 404 zurückgibt oder wenn keine Links auf diese 404-Seite verweisen .

Werbung

Weiter unten lesen

Aus diesem Grund sollten Sie bei der Bewertung der vom Crawler erkannten Probleme immer überprüfen, auf wie viele Webseiten sie sich beziehen und auf welche.

Sie müssen den Fehlerkontext angeben.

Sitebulb zeigt Ihnen beispielsweise den Prozentsatz der URLs an, auf die sich ein bestimmter Fehler bezieht.

Hier ist ein Beispiel für eine interne URL, die auf eine defekte URL umleitet, die 4XX oder 5XX zurückgibt, die von Sitebulb gemeldet wurde:

Screenshot vom Sitebulb-Website-Crawler, September 2021

Screenshot vom Sitebulb-Website-Crawler, September 2021Es sieht nach einem ziemlich ernsten Problem aus, bezieht sich aber nur auf eine unwichtige Webseite, also ist es definitiv kein Problem mit hoher Priorität.

Werbung

Weiter unten lesen

Abschließende Gedanken & Tipps

SEO-Crawler sind unverzichtbare Werkzeuge für technische SEO-Profis. Was sie enthüllen, muss jedoch immer im Kontext der Website und Ihrer Unternehmensziele interpretiert werden.

Es braucht Zeit und Erfahrung, um den Unterschied zwischen einem Pseudoproblem und einem echten Problem zu erkennen. Glücklicherweise bieten die meisten Crawler ausführliche Erklärungen zu den angezeigten Fehlern und Warnungen.

Deshalb ist es immer eine gute Idee – gerade für SEO-Anfänger – diese Erklärungen und die Crawler-Dokumentation zu lesen. Stellen Sie sicher, dass Sie wirklich verstehen, was ein bestimmtes Problem bedeutet und ob es sich tatsächlich lohnt, es zu einer Lösung zu eskalieren.

Mehr Ressourcen:

Ausgewähltes Bild: Pro Symbols/Shutterstock