Ohne KI geht nichts mehr, sagt die Gaming- und IT-Branche diese Woche auf der CES. Doch wie macht Künstliche Intelligenz Games eigentlich lebensechter? Ein Blick in die Technik und auf die Rolle des KI-Platzhirschen Nvidia.

Die Gamingbranche lebt vom Streben nach glaubwürdigen virtuellen Welten. Da beginnt fotorealistischen Texturen sowie perfekten Lichteffekten und reicht künftig auch bis zum Plaudern mit KI-Figuren. Bisher sind Schatten, Reflexionen oder Lichtstrahlen nur eine Annäherung an die Realität. Die Spiegelung der Umgebung in den Pfützen einer regennassen Straße oder in der Glasfront eines Schaufensters wird mit kleinen Softwaretricks lediglich imitiert. In Echtzeit berechnete Reflexionen erfordern Unmengen an Rechenleistung. Und die ist begrenzt, weil die Hardwareentwicklung auf der Stelle tritt.

Die neuen Prozessoren in den PC und Konsolen verdoppeln nicht mehr alle zwei Jahre ihre Leistung wie in den vorangegangenen Jahrzehnten. Lange hatte das “Moorsche Gesetz” Recht behalten. IBM Chef Gordon Moore sagte 1965 voraus, dass sich die Anzahl der Transistoren auf einem Chip alle zwei Jahre verdoppeln würde und damit auch die Rechenleistung, bei zugleich sinkenden Preisen. Bis Anfang 2000 war das auch so. Durch eine kaum vorstellbare Miniaturisierung der Leiterbahnen passten immer mehr Transistoren auf eine immer kleinere Fläche.

76 Milliarden Transistoren auf einem Daumennagel

Waren im ersten IBM Großrechner von der Größe einer Toploader-Gefriertruhe 1000 Transistoren zusammengeschaltet, beherbergt der modernste Intel-Prozessor 14,2 Milliarden Transistoren auf der Fläche eines Daumennagels. Auf der neusten Grafikkarte von Nvidia, der Geforce RTX 4090, werkeln sogar über 76 Milliarden der kleinen Ein/Aus-Schalter. Ein Rekord. Allerdings lassen sich die Leiterbahnen auf den Chips kaum mehr verkleinern, sie sind bereits heute nur noch zehn bis sieben Nanometer breit, was wenigen Atomlagen entspricht. Gleiches gilt für die Taktrate, einst das PS-Pendant für die Rechenkraft von Prozessoren, auch sie lässt sich kaum mehr in die Höhe treiben. Zumal höhere Taktung mehr Abwärme und aufwändigere Kühlung bedeutet, vor allem aber einen deutlich höheren Stromverbrauch.

Die Auswirkung von Ray Tracing sind mitunter nur in Details erkennbar, doch in der Summe nimmt das Gehirn die Szene als realistischer wahr. Das kleine Bild zeigt die Szene ohne Ray Tracing. Im großen KI-Bild ist die Szene besser ausgeleuchtet, das Licht wird vom Stoff der Jacke reflektiert, im Fenster spiegelt sich die klar erkennbar die Umgebung und die Neoneffekte strahlen realistischer auf Oberflächen.

© stern.de

Die zuletzt gestiegene Rechenkraft der Grafikprozessoren wurde vor allem für immer höheren Auflösungen der Monitore benötigt. Einer Umfrage des Magazins PCGames-Hardware zufolge, zockten die Hälfte der Befragten heute auf 4K-Monitoren. Noch vor gut vier Jahren war FullHD das Maß der Dinge. Bei 4K muss die Grafikkarte acht Millionen Pixel mehr als bei FullHD berechnen. Zugleich verlangen die Gamer eine immer flüssigere Darstellung der virtuellen Welten. Statt 30 Bilder pro Sekunde sollte der Grafikprozessor nun 60 FPS – Frames per Second bewältigen, besser noch mehr. Für realistischere Grafik blieb da wenig Spielraum. Bis jetzt.

Statt die Rechenleistung der Grafikprozessoren immer weiter zu beschleunigen, macht man sie mit künstlicher Intelligenz schlauer. Alle großen Chiphersteller sind auf den KI-Zug aufgesprungen. So wird Intel seinen Grafikkarten spezielle KI-Chips zur Seite stellen, AMD, die Nummer zwei im Grafikkartenmarkt, macht das bereits länger.

Nvidia könne Apple vom Thron der wertvollsten Marke stoßen

Unumstrittener Platzhirsch auf diesem Gebiet ist das US-Unternehmen Nvidia. Einst als auf das Gaming spezialisierter Grafikkartenhersteller gestartet, sieht das Unternehmen heute sein Wachstumsfeld im Bereich des KI gestützten Computings. Außerhalb der Gamingbranche ist Nvidia selten ein Begriff, dabei ist das US-Unternehmen im Mai 2023 in den Club der “One-Billion”-Unternehmen aufgestiegen. Der Börsenwert hatte sich innerhalb eines Jahres verdoppelt. Mit einem Wert von rund 1000 Milliarden US-Dollar ist Nvidia der wertvollste Chiphersteller der Welt. Experten zufolge hat Nvidia das Potenzial, eines Tages Apple vom Thron des wertvollsten Unternehmens überhaupt zu stoßen. Bis dahin ist es jedoch noch ein Stück. Gerade verwies Microsoft seinen ewigen Widersacher mit einem Börsenwert von 2875,3 US-Dollar auf Rang Zwei. Angetrieben wie bei Nvidia vom KI-Geschäft.

Die künstlichen neuronale Netzwerke, auf denen die Künstliche Intelligenz beruht, müssen im Wortsinn lernen und trainiert werden. Aus den gesammelten “Erfahrungen” kann die KI dann Einschätzungen ableiten. Neuronale Netzwerke gleichen dem Gehirn. Zum Beispiel in der Objekterkennung auf Bildern. Was unterscheidet einen Hund von einer Kuh? Beide haben vier Beine, einen Kopf und einen Schwanz. Es ist beinahe unmöglich eine Definition zu programmieren, mit der ein Computer zielsicher die beiden Tiere aus unterschiedlichen Perspektiven auseinanderhalten könnte.

Im großen Bild spiegelt sich der Himmel im Wasser, im kleinen Bild nicht.

© Nvidia

Effektiver ist es, der Anwendung zehntausende Bilder von Hunden und Kühen zu zeigen, damit das Programm durch “Versuch und Irrtum” selbst die Unterschiede herausarbeitet und lernt. Das unterscheidet eine KI von herkömmlicher Software. Aus diesem Grund bietet Google seine Speicherdienste für Fotos kostenlos an. Mit den hochgeladenen Bildern der User, wird die Bilderkennungs-KI von Google trainiert. Aber auch in der Medizin zum Beispiel bei der Erkennung von Krebszellen findet Künstliche Intelligenz Verwendung. Nach dem gleichen Prinzip arbeiten auch ChatGPT und seine Kollegen. Sie lernen, aus den gesprochenen Worten die Frage zu interpretieren und eine darauf passende Antwort aus einer gewaltigen Datenmenge zu einem Antworttext zusammenzustellen.

30.000 US-Dollar für einen KI-Prozessor

Für dieses Training ist die Rechenweise herkömmlicher Prozessoren jedoch ungeeignet. Vor sechs Jahren stellte Nvidia einen Chip vor, der Rechenaufgaben nicht nacheinander abarbeitet, sondern parallel und zugleich die Anzahl der Rechenschritte deutlich reduziert. Diese “Tensor-Cores“ beschleunigen das KI-Training enorm. Die 2023 eingeführte vierte Generation der Tensoren ist um ein Vielfaches schneller als die erste Generation.

Mit dem H100-Tensor-Prozessor dominiert Nvidia derzeit der Hardwaremarkt für KI. Die Nachfrage ist so groß, dass sie kaum mehr befriedigen kann. Nvidia-Chef Jensen Huang spricht von einem “Plattform-Wechsel”, der in der IT nur alle 15 Jahre stattfinde. Das IPhone war so ein IT-Erdbeben. Nvidias IPhone ist der H100. Einer dieser Prozessoren kostet rund 30.000 US-Dollar. ChatGPT-Erfinder OpenAI will dem Handelsblatt zufolge 50.000 der GPUs kaufen, beim Konkurrenten Inflection sollen es 22.000 sein. Meta (Facebook, Instagram, WhatsApp) wird in der Branche der Bedarf von 25.000 Tensor-Chips nachgesagt. Ein Milliarden Geschäft.

Die KI-Prozessoren und die große Nachfrage haben direkte Auswirkungen auf Millionen von Gamern. Denn auch in seiner neusten Grafikarten-Generation hat Nvidia Tensor-Chips verbaut. Sie sollen die Spielegrafik in den Bereich des Fotorealismus rücken. Haben zuvor Grafikprozessor und die sogenannten Shader eher stumpf die von der Software gesendeten Bildinformationen in einzelne Pixel gerastert und in ein Bild auf dem Monitor verwandelt, gehen die KI-Nvidia-Karten andere Wege. Der wichtigste davon ist, die Bilder kleiner zu machen, als sie es tatsächlich sind.

Zentrale Technik ist das DLSS, das Deep Learning Super Sampling. Dabei wird das Bild in einer niedrigeren Auflösung als der des Monitors gerendert und anschließend auf die Monitorauflösung hochskaliert. Das Rendern, also berechnen von 3D Informationen zu einem 2D-Bild, geht in einer geringeren Auflösung deutlich schneller und entlastet den Grafikprozessor erheblich. Anschließend muss das Bild jedoch wieder in die hohe Auflösung skaliert werden. Bei einer einzelnen Grafik wäre das leicht, bei einer Spielegrafik, die sich im Takt von Millisekunden von Bild zu Bild verändert, ist das deutlich schwieriger.

Hier kommt das “Learning” ins Spiel. Die KI hinter DLSS nimmt nicht nur ein Bild und rechnet es hoch, sondern sie schaut auf die Informationen der Bilder zuvor und schätzt, welche Bilder wohl unmittelbar danach kommen könnten. Das System lernt im Grunde, die Bewegungen von Objekten vorherzusagen. DLSS ist keine Bildverbesserung, sondern es erhöht deutlich die Zahl der angezeigten Bilder pro Sekunde, ohne signifikante Verschlechterung der Bildqualität. DLSS bildet die Grundlage aller weiteren Bildverbesserungen. Erst mit DLSS und der vergleichbaren FSR-Technik von AMD lassen sich zusätzliche Grafikoptionen im Spiel aktivieren, ohne dass die FPS absinken und es zu ruckeln beginnt.

So zum Beispiel Ray Tracing, der Berechnung von Lichtstrahlen und deren Reflexion. Ob die Stehlampe auf einem Schreibtisch oder die Neonreklame über einem Geschäft an einer regennassen Straße: Lichtstrahlen treffen auf Objekte, werfen Schatten und werden je nach Oberfläche stärker oder schwächer auf weitere Gegenstände umgelenkt. In Pfützen spiegelt sich das Licht von Gebäuden oder im Autolack die Umgebung. Die Hardware muss hier nicht nur das Bild aus einer Perspektive berechnen, sondern aus jeder, aus der Lichtstrahlen auf etwas treffen.

Zwar können moderne Grafikprozessoren den Weg des Lichts berechnen, doch nicht so schnell, dass es für eine flüssige Darstellung reicht. Mit dem KI gestützten DLSS oder vergleichbaren Techniken wie FSR von AMD wird das erstmals möglich. Und das ist erst der Anfang. Konzentrierte sich DLSS bisher auf das Skalieren von Bildern, verbessert die neuste Version 3.5 die Grafik durch Techniken wie Ray Rekonstruktion und Path Tracing. Dabei werden den berechneten Strahlen weitere Pixel hinzugefügt, die Reflexionen werden so noch klarer und die Grafik insgesamt detailreicher. Während Ray Tracing den Weg des Lichtstrahls von der Quelle zum angestrahlten Objekt berechnet, kalkuliert Path Tracing die gesamte Beleuchtung einer Szene.

Paradebeispiel und Machbarkeitsstudie ist das Spiel Cyberpunk 2077 in der neusten Version. Der millionenfach verkaufte Titel des polnischen Studios CDRed Project ist derzeit das einzige Spiel bei dem sämtliche KI-Verbesserungen bestaunt werden können. Die virtuelle futuristische Großstadt Night City mit ihren stark befahrenen regennassen Straßen, den grellen Neonlichtern und beleuchteten Geschäften ist atemberaubend – wenn eine Grafikkarte der 40er-Reihe von Nvidia im PC steckt. Preis einer 4090 RTX, dem Spitzenmodell: rund 2000 Euro. Gute 800 Euro werden für die spürbar schwächere Variante der 4070 RTX verlangt. Auf der CES 2024 stellte Nvidia eine Reihe von Mittelklassekarten vor, mit denen die KI-Bildverbesserungen ebenfalls möglich sind.

Nvidia KI in Spielen

Cyberpunk 2077 mit und ohne KI im Vergleich

Die Preise für Grafikkarten haben sich damit innerhalb von drei Jahren verdoppelt. Zum einen lag das an der großen Nachfrage an KI-Chips, zum anderen am Boom der Krypto-Währungen. Mit den GPUs, den Hauptrecheneinheiten der Grafikkarte, lassen sich Bitcoins viel schneller berechnen. Sogenannte Kryptominer kauften mit Hilfe von Bots innerhalb von Sekunden nicht selten direkt beim Hersteller die Lager leer. Selbst wenn PC-Gamer die hohen Preise zu zahlen bereit waren, sie bekamen die Karten in Europa nicht. Veraltete Nvidia-Grafikkarten wurden 2020 und 2021 nicht selten teurer als ihr Preis bei der Neuvorstellung angeboten. Das gab es noch nie.

Davinci Resolve: Aufwändige Videoeffekte mit KI schnell berechnet

Die Lage hat sich entspannt, doch nach Einschätzung von Marktbeobachtern wird sich das alte Preisgefüge indes nicht mehr einstellen. Spitzengrafikkarten werden wohl auch weiterhin so viel kosten wie ein kompletter guter Gaming-PC vor drei Jahren. Für das derzeitige Spitzenmodell Nvidia 4090 RTX ist die CPU, das Herzstück eines jeden PC oder Konsole, ohnehin nur noch Beiwerk. Für die Leistung bei Games aber auch Anwendungen wie Videobearbeitung, Auto-CAD, oder Bildbearbeitung spielt die CPU mittlerweile eine untergeordnete Rolle. Adobes After Effects und das Videoschnittprogramm Blackmagic Davinci Resolve verkürzen die für das Berechnen der Videos notwendige Zeit mit der KI-Technik ganz erheblich. Was früher Stunden dauerte ist heute in Minuten erledigt.

Kritiker aus der Gamingbranche sehen die Entwicklung mit gemischten Gefühlen. Grafikkarten würden im Grunde nicht mehr schneller, sondern täuschten lediglich einen Leistungszuwachs durch KI vor. Wenn das künftig nur noch mit Nvidias hauseigener DLSS-Technik ginge, so die Befürchtung, würde das Unternehmen den Markt dominieren, was sich auf die gesamte Wertschöpfungskette der Spieleentwicklung negativ auswirkte.

Ein echtes Gespräch mit Computerfiguren könnten bald möglich sein

Doch schon mittelfristig könnte die KI in Spielen weit mehr als die Grafik glaubwürdiger erscheinen zu lassen. Mit von der KI generierten Unterhaltungen zum Beispiel. Der Heilige Gral von Computerspielentwicklern das Erschaffen einer für den Spieler glaubwürdigen Welt. Bei der Grafik funktioniert das immer besser, sie ist auf dem Weg zum Fotorealismus. Was jedoch die Immersion zerstört ist die Interaktion mit den NPC, den Non Playable Characters, jenen von der Software künstlich erstellten Figuren im Spiel. Sie sollen als Passanten und Begleiter des Spielers die virtuelle Welt bevölkern und ihr damit ein Eigenleben einhauchen. NPC sind allerdings nur mit einem begrenzten Repertoire an Sätzen ausgestattet. Ist das programmierte Gespräch mit dem Spieler beendet, schweigen sie fortan oder geben ein “Hallo, wie geht’s” als Standartantwort. Ein Gespräch mit ihnen zu führen, ist derzeit noch undenkbar.

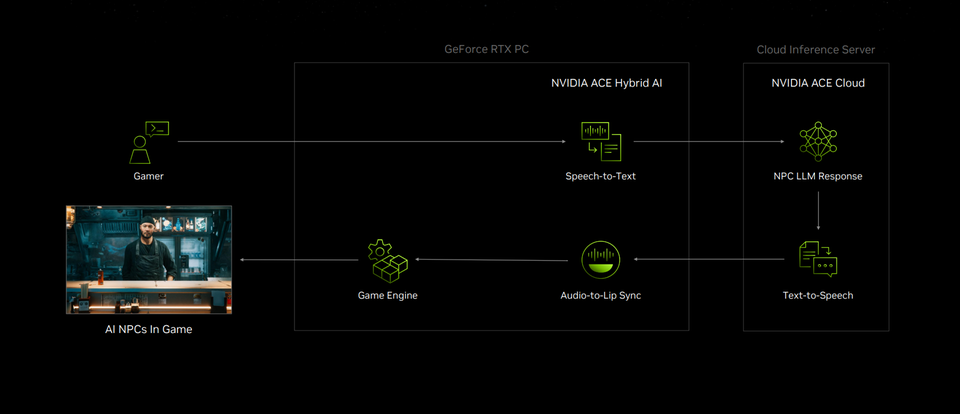

So funktioniert Nvidia ACE. Das Gespräch findet sozusagen in der Cloud statt.

© Nvidia

Das von Nvidia auf der CES 2024 vorgestellte System ACE soll die Interaktion von Spieler und virtueller Umwelt revolutionieren. ACE steht für Avatar Cloud Engine. Die Idee: NPC haben eine Vita, eine Art künstliche Identität mit Charaktereigenschaften, einem Beruf und bestimmten Fähigkeiten, sie wissen, in welchem Verhältnis sie zum Spieler in der Geschichte stehen. Die digitale Persönlichkeit liegt in einer Cloud. Spricht der Spieler einen NPC an, wird die Frage an die Cloud gesendet und, vergleichbar mit ChatGPT, eine passende Antwort auf der Grundlage der vorgegeben Persönlichkeit generiert. Die Antwortsätze werden von der Cloud an ein Modul geschickt, das die Lippenbewegung mit dem Text synchronisiert, bevor sie vom NPC ausgesprochen werden. Auf diese Weise könnten Spieler tatsächlich mit NPC in einer virtuellen Bar “abhängen” und sich unterhalten. Ein Hauch von Holodeck aus der Serie Star Trek Next Generation.

Das der Mensch die Maschine grundsätzlich annimmt, zeigte unlängst das “Priester Experiment”, bei dem ChatGPT mit Rahmendaten zu einer Identität programmiert wurde. Die KI sollte einen in der Seelsorge tätigen Priester darstellen und einer echten älteren Dame beistehen, die tatsächlich am Leben und ihrer Einsamkeit verzagte. Das Gespräch wurde von einem echten Priester überwacht. Die Frau wusste nicht, mit wem sie ihr Herz ausschüttete, doch als das Geheimnis gelüftet wurde, wollte sie sich auch weiterhin mit der KI unterhalten. Ihr das Gespräch schließlich in ihrer Not geholfen, meinte sie.

Ohne sinnvolle Inhalte ist selbst gute KI sinnlos

Doch bis ACE in Spielen Einzug hält, dürfte es noch Jahre dauern. Bislang ist das System nur eine Dienstleistung, die von den Studios in neue Spiele eingebaut werden kann. Nvidia selbst nennt es Micro-Services. Die Technik wäre indes so revolutionär, dass eine neue Gattung von Spielen dafür geschaffen werden müsste. Echte Unterhaltungen mit Protagonisten wären zwar spannend, doch für den Spieler müsste sich daraus ein Mehrwert im Spiel ergeben. Für den Microsoft Flugsimulator oder X-Plane könnte das zum Beispiel ein echter Funkverkehr mit den Fluglosten sein. Ohne Nutzen bliebe der KI-Chat ein Nischenprodukt, ähnlich wie die Brillen für die Virtuelle Realität.

Für Nvidia es ist ein Versuch, sich weitere Pfründe im schnellen KI-Markt zu sichern und neue Erfahrungen zu sammeln. Für das nächste KI-Produkt auf dem Weg zum vielleicht wertvollsten Unternehmen der Welt.