Experten haben gewarnt, dass die KI-Technologie eine Explosion von Betrug mit dem Klonen von Stimmen anheizt.

Betrüger können jetzt die Stimme eines Opfers mit nur einem dreisekündigen Audioschnipsel nachahmen, der oft aus Social-Media-Profilen gestohlen wird.

Es wird dann verwendet, um einen Freund oder ein Familienmitglied anzurufen, um ihn davon zu überzeugen, dass er in Schwierigkeiten steckt und dringend Geld braucht.

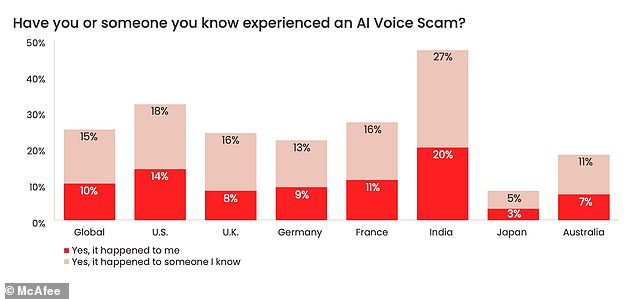

Laut dem Cybersicherheitsspezialisten McAfee gibt einer von vier Briten an, dass er selbst oder jemand, den er kennt, Opfer des Betrugs geworden ist.

Es ist so glaubwürdig, dass die Mehrheit der Betroffenen zugab, dass sie dadurch Geld verloren haben, wobei die Kosten für etwa ein Drittel der Opfer über 1.000 £ liegen.

Behalten Sie die Augen im Auge: KI-Technologie schürt eine Explosion von Betrug mit dem Klonen von Stimmen, warnen Experten (Archivbild)

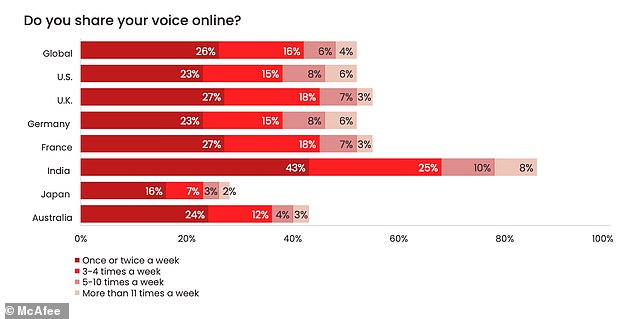

Betrüger können jetzt die Stimme eines Opfers mit nur einem dreisekündigen Audioschnipsel nachahmen, der oft aus Social-Media-Profilen gestohlen wird. Der Cybersicherheitsspezialist McAfee hat Menschen auf der ganzen Welt befragt, um zu sehen, wie viele Menschen online ihre Meinung sagen

Ein Bericht der Firma besagt, dass die KI bereits „das Spiel für Cyberkriminelle verändert“ hat, da die Tools, die zur Durchführung des Betrugs erforderlich sind, im Internet frei verfügbar sind.

Experten, Akademiker und Chefs aus der gesamten Technologiebranche fordern eine strengere Regulierung der KI, da sie befürchten, dass der Sektor außer Kontrolle gerät.

US-Vizepräsidentin Kamala Harris trifft sich heute (Mittwoch) mit den Vorstandsvorsitzenden von Google, Microsoft und OpenAI, der Firma hinter ChatGPT, um zu erörtern, wie KI verantwortungsvoll entwickelt werden kann.

Sie werden sich mit der Notwendigkeit von Sicherheitsvorkehrungen befassen, die potenzielle Risiken mindern können, und die Bedeutung ethischer und vertrauenswürdiger Innovationen betonen, sagte das Weiße Haus.

In McAfees Bericht „The Artificial Imposter“ heißt es, das Klonen, wie jemand klingt, sei zu einem „mächtigen Werkzeug im Arsenal eines Cyberkriminellen“ geworden – und es sei nicht schwer, Opfer zu finden.

Eine Umfrage unter über 1.000 britischen Erwachsenen ergab, dass die Hälfte ihre Sprachdaten mindestens einmal pro Woche online in sozialen Medien oder Sprachnotizen teilte.

Die Untersuchung ergab mehr als ein Dutzend KI-Tools zum Klonen von Stimmen, die offen im Internet verfügbar sind, von denen viele kostenlos sind und für deren Verwendung nur ein grundlegendes Maß an Fachwissen erforderlich ist.

In einem Fall reichten nur drei Sekunden Audio aus, um eine 85-prozentige Übereinstimmung zu erzielen, während es keine Probleme hatte, Akzente aus der ganzen Welt zu reproduzieren.

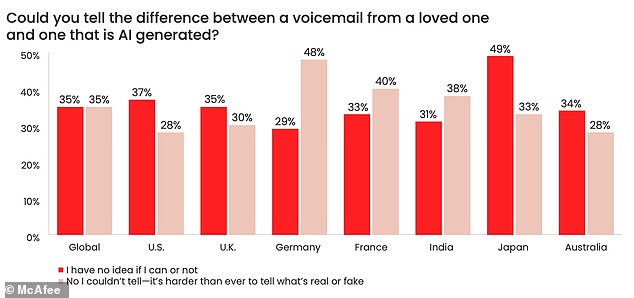

Da jedermanns Stimme das gesprochene Äquivalent eines biometrischen Fingerabdrucks ist, gaben 65 Prozent der Befragten an, dass sie sich nicht sicher waren, ob sie die geklonte Version von der echten unterscheiden könnten.

Die nachgeahmte Stimme wird verwendet, um einen Freund oder ein Familienmitglied anzurufen, um sie davon zu überzeugen, dass sie in Schwierigkeiten sind und dringend Geld brauchen (Archivbild)

Ein Bericht der Firma besagt, dass die KI bereits „das Spiel für Cyberkriminelle verändert“ hat, da die Tools, die zur Durchführung des Betrugs erforderlich sind, im Internet frei verfügbar sind. Die Firma befragte Personen, um herauszufinden, wie viele selbst einen KI-Sprachbetrug erlebt hatten oder jemanden kannten, der dies getan hatte

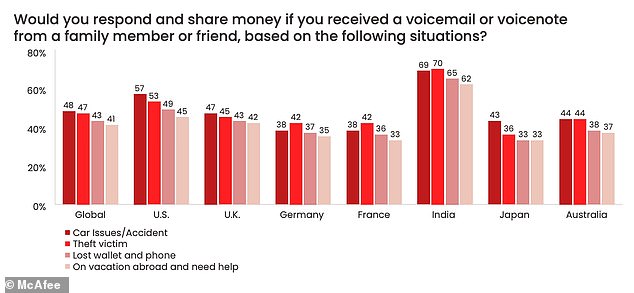

Besorgniserregend: Mehr als drei von zehn Briten gaben an, dass sie auf eine Voicemail oder Sprachnotiz antworten würden, die vorgibt, von einem Freund oder geliebten Menschen zu stammen, der Geld braucht – insbesondere, wenn sie dachten, es käme von einem Partner, Kind oder Elternteil

Die Kosten, auf einen KI-Sprachbetrug hereinzufallen, können erheblich sein, da 78 Prozent der Menschen zugeben, dass sie Geld verloren haben. Etwa 6 Prozent wurden um 5.000 bis 15.000 Pfund betrogen

Mehr als drei von zehn Befragten gaben an, dass sie auf eine Voicemail oder Sprachnotiz antworten würden, die vorgeben, von einem Freund oder geliebten Menschen zu stammen, der Geld braucht – insbesondere, wenn sie dachten, es käme von einem Partner, Kind oder Elternteil.

Nachrichten, die am wahrscheinlichsten eine Antwort hervorriefen, waren diejenigen, die behaupteten, der Absender sei in einen Autounfall verwickelt gewesen, ausgeraubt worden, habe sein Telefon oder seine Brieftasche verloren oder brauche Hilfe, während er ins Ausland reiste.

Einer von 12 gab an, dass er persönlich von einer Art KI-Sprachbetrug betroffen war, und weitere 16 Prozent gaben an, dass es jemandem passiert war, den sie kannten.

Die Kosten, auf einen KI-Sprachbetrug hereinzufallen, können erheblich sein, da 78 Prozent der Menschen zugeben, dass sie Geld verloren haben. Etwa 6 Prozent wurden um 5.000 bis 15.000 Pfund betrogen.

Vonny Gamot, Head of EMEA bei McAfee: „Fortschrittliche Tools für künstliche Intelligenz verändern das Spiel für Cyberkriminelle. Jetzt können sie mit sehr geringem Aufwand die Stimme einer Person klonen und einen engen Kontakt dazu verleiten, Geld zu senden.“

Sie fügte hinzu: „Künstliche Intelligenz bietet unglaubliche Möglichkeiten, aber bei jeder Technologie besteht immer das Potenzial, dass sie böswillig in den falschen Händen eingesetzt wird.

„Das sehen wir heute angesichts des Zugangs und der Benutzerfreundlichkeit von KI-Tools, die Cyberkriminellen dabei helfen, ihre Bemühungen auf immer überzeugendere Weise zu skalieren.“