Google kündigte eine bahnbrechende Forschung zur Verarbeitung natürlicher Sprache mit dem Namen Chain of Thought Prompting an, die den Stand der Technik fortschrittlicher Technologien wie PaLM und LaMDA auf ein bemerkenswertes Niveau hebt, wie die Forscher sagen.

Die Tatsache, dass Chain of Thought Prompting PaLM und LaMDA in diesen signifikanten Raten verbessern kann, ist eine große Sache.

LaMDA und PaLM

Die Forschung führte Experimente mit zwei Sprachmodellen durch, dem Sprachmodell für Dialoganwendungen (LaMDA) und dem Pathways-Sprachmodell (PaLM).

LaMDA ist ein Modell, das sich auf Konversation konzentriert, wie ein Chatbot, aber es kann auch für viele andere Anwendungen verwendet werden, die Sprechen und Dialog erfordern.

PaLM ist ein Modell, das dem folgt, was Google die Pathways-KI-Architektur nennt, bei der ein Sprachmodell trainiert wird, um zu lernen, wie man Probleme löst.

Früher wurden maschinelle Lernmodelle darauf trainiert, eine Art von Problem zu lösen, und sie wurden im Wesentlichen losgelassen, um diese eine Sache wirklich gut zu machen. Aber um etwas anderes zu tun, müsste Google ein neues Modell trainieren.

Die Pathways-KI-Architektur ist eine Möglichkeit, ein Modell zu erstellen, das Probleme lösen kann, die es vorher nicht unbedingt gesehen hat.

Wie im Google PaLM-Erklärer zitiert:

„…wir möchten ein Modell trainieren, das nicht nur viele einzelne Aufgaben bewältigen kann, sondern auch auf vorhandene Fähigkeiten zurückgreifen und kombinieren kann, um neue Aufgaben schneller und effektiver zu lernen.“

Was es macht

Das Forschungspapier listet drei wichtige Durchbrüche für Chain of Thought Reasoning auf:

- Es ermöglicht Sprachmodellen, komplexe Mehrschrittprobleme in eine Folge von Schritten zu zerlegen

- Die Kette des Denkprozesses ermöglicht es Ingenieuren, einen Blick in den Prozess zu werfen, und wenn etwas schief geht, können sie so erkennen, wo es schief gelaufen ist, und es beheben

- Kann mathematische Wortprobleme lösen, kann mit gesundem Menschenverstand argumentieren und kann laut Forschungsbericht (im Prinzip) jedes wortbasierte Problem lösen, das ein Mensch lösen kann.

Aufgaben zum mehrstufigen Denken

Die Forschung gibt ein Beispiel für eine mehrstufige Denkaufgabe, an der Sprachmodelle getestet werden:

„F: Die Cafeteria hatte 23 Äpfel. Wenn sie 20 für das Mittagessen verwendet und 6 weitere gekauft haben, wie viele Äpfel haben sie dann?

A: Die Cafeteria hatte ursprünglich 23 Äpfel. Sie verwendeten 20, um das Mittagessen zuzubereiten. Sie hatten also 23 – 20 = 3. Sie kauften 6 weitere Äpfel, also haben sie 3 + 6 = 9. Die Antwort ist 9.“

PaLM ist ein hochmodernes Sprachmodell, das Teil der Pathways-KI-Architektur ist. Es ist so fortgeschritten, dass es erklären kann, warum ein Witz lustig ist.

Doch so fortgeschritten PaLM auch ist, die Forscher behaupten, dass die Chain of Thought Prompting diese Modelle erheblich verbessert, und das macht diese neue Forschung so bemerkenswert.

Google erklärt es so:

„Das Chain-of-Thought-Argument ermöglicht es Modellen, komplexe Probleme in Zwischenschritte zu zerlegen, die einzeln gelöst werden.

Darüber hinaus macht die sprachbasierte Natur der Gedankenkette sie auf jede Aufgabe anwendbar, die eine Person durch Sprache lösen könnte.“

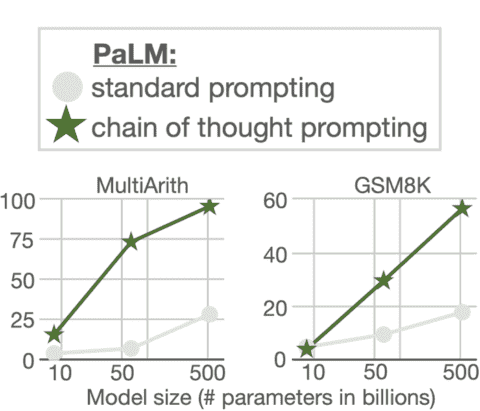

Das Forschungspapier fährt dann mit der Feststellung fort, dass sich die Standard-Eingabeaufforderung nicht wirklich verbessert, wenn der Maßstab des Modells erhöht wird.

Bei diesem neuen Ansatz hat die Skalierung jedoch einen signifikanten und bemerkenswert positiven Einfluss darauf, wie gut das Modell funktioniert.

Ergebnisse

Chain of Thought Prompting wurde sowohl auf LaMDA als auch auf PaLM getestet, wobei zwei mathematische Wortproblem-Datensätze verwendet wurden.

Diese Datensätze werden von Forschern verwendet, um Ergebnisse zu ähnlichen Problemen für verschiedene Sprachmodelle zu vergleichen.

Unten sind Bilder von Diagrammen, die die Ergebnisse der Verwendung von Chain of Thought Prompting auf LaMDA zeigen.

Die Ergebnisse der Skalierung von LaMDA auf dem MultiArith-Datensatz zeigen, dass dies zu einer bescheidenen Verbesserung führte. Aber LaMDA schneidet deutlich besser ab, wenn es mit Chain of Thought Prompting skaliert wird.

Die Ergebnisse des GSM8K-Datensatzes zeigen eine bescheidene Verbesserung.

Anders sieht es beim PaLM-Sprachmodell aus.

Wie in der obigen Grafik zu sehen ist, sind die Gewinne aus der Skalierung von PaLM mit Chain of Thought Prompting enorm, und sie sind enorm für beide Datensätze (MultiArith und GSM8K).

Die Forscher bezeichnen die Ergebnisse als bemerkenswert und als neuen Stand der Technik:

„Beim GSM8K-Datensatz von mathematischen Wortaufgaben zeigt PaLM eine bemerkenswerte Leistung, wenn es auf 540-B-Parameter skaliert wird.

…die Kombination von Chain of Thought Prompting mit dem 540B-Parameter-PaLM-Modell führt zu einer neuen State-of-the-Art-Leistung von 58 % und übertrifft damit den früheren Stand der Technik von 55 %, der durch die Feinabstimmung von GPT-3 175B in einem großen Training erreicht wurde potenzielle Lösungen durch einen speziell ausgebildeten Verifizierer festlegen und anschließend in eine Rangfolge bringen.

Darüber hinaus zeigen Nachfolgearbeiten zur Selbstkonsistenz, dass die Leistung der Gedankenkette weiter verbessert werden kann, indem die Mehrheitsentscheidung einer breiten Palette von generierten Denkprozessen getroffen wird, was zu einer Genauigkeit von 74 % bei GSM8K führt.“

Schlussfolgerungen

Der Abschluss einer Forschungsarbeit ist einer der wichtigsten Teile, um zu überprüfen, ob die Forschung den Stand der Technik voranbringt oder eine Sackgasse ist oder mehr Forschung erfordert.

Der Abschnitt zum Abschluss des Forschungspapiers von Google hat eine stark positive Note.

Es stellt fest:

„Wir haben Chain of Thought Prompting als einfache und breit anwendbare Methode zur Verbesserung der Argumentation in Sprachmodellen untersucht.

Durch Experimente zu arithmetischem, symbolischem und gesundem Menschenverstand finden wir heraus, dass die Kette der Gedankenverarbeitung eine emergente Eigenschaft der Modellskala ist, die es ausreichend großen Sprachmodellen ermöglicht, Denkaufgaben durchzuführen, die ansonsten flache Skalierungskurven haben.

Die Erweiterung des Spektrums an Denkaufgaben, die Sprachmodelle ausführen können, wird hoffentlich weitere Arbeiten zu sprachbasierten Denkansätzen inspirieren.“

Das bedeutet, dass Chain of Thought Prompting das Potenzial haben könnte, Google die Möglichkeit zu geben, seine verschiedenen Sprachmodelle erheblich zu verbessern, was wiederum zu erheblichen Verbesserungen der Möglichkeiten von Google führen kann.

Zitate

Lesen Sie den Google AI-Artikel

Sprachmodelle führen Argumentation über eine Gedankenkette durch

Laden Sie das Forschungspapier herunter und lesen Sie es

Chain of Thought Prompting löst Argumentation in großen Sprachmodellen aus (PDF)