Beweiswissenschaftler können jetzt Ihren GEIST lesen: KI verwandelt die Gedanken der Menschen mit einer Genauigkeit von 80 % in Bilder

Künstliche Intelligenz kann Bilder basierend auf Texteingabeaufforderungen erstellen, aber Wissenschaftler enthüllten eine Galerie von Bildern, die die Technologie durch Lesen der Gehirnaktivität erzeugt.

Der neue KI-gestützte Algorithmus rekonstruierte aus diesen Gehirnscans mit 80-prozentiger Genauigkeit rund 1.000 Bilder, darunter einen Teddybären und ein Flugzeug.

Forscher der Universität Osaka verwendeten das beliebte Stable Diffusion-Modell, das in DALL-E 2 von OpenAI enthalten ist und beliebige Bilder basierend auf Texteingaben erstellen kann.

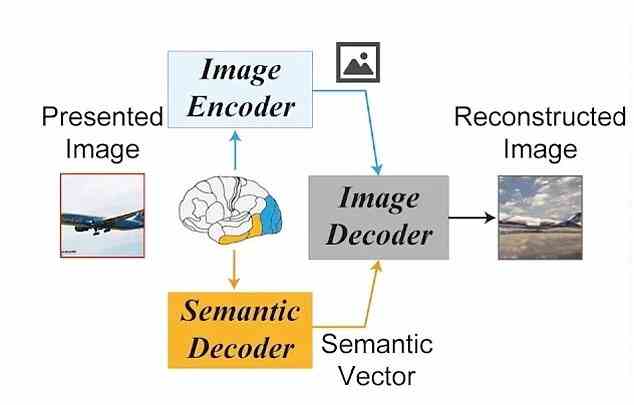

Das Team zeigte den Teilnehmern einzelne Bildsätze und sammelte fMRT-Scans (funktionelle Magnetresonanztomographie), die die KI dann entschlüsselte.

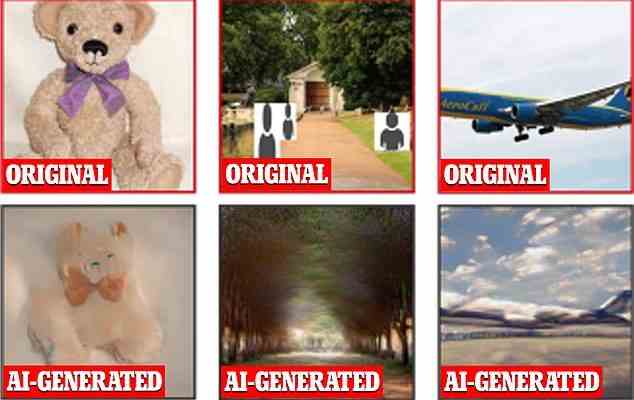

Wissenschaftler speisten die KI-Gehirnaktivität von vier Studienteilnehmern. Die Software rekonstruierte dann, was sie in den Scans sah. Die obere Reihe zeigt die Originalbilder, die den Teilnehmern gezeigt werden, und die untere Reihe zeigt die KI-generierten Bilder

“Wir zeigen, dass unsere Methode hochauflösende Bilder mit hoher semantischer Genauigkeit aus der Aktivität des menschlichen Gehirns rekonstruieren kann”, teilte das Team in der in bioRxiv veröffentlichten Studie mit.

“Im Gegensatz zu früheren Studien zur Bildrekonstruktion erfordert unsere Methode kein Training oder Feinabstimmung komplexer Deep-Learning-Modelle.”

Laut Yu Takagi, der die Forschung leitete, bezieht der Algorithmus Informationen aus Teilen des Gehirns, die an der Bildwahrnehmung beteiligt sind, wie dem Hinterhaupts- und dem Schläfenlappen.

Das Team verwendete fMRT, weil es Änderungen des Blutflusses in aktiven Gehirnbereichen aufnimmt, berichtet Science.org.

FMRI kann Sauerstoffmoleküle erkennen, sodass die Scanner sehen können, wo im Gehirn unsere Neuronen – Nervenzellen des Gehirns – am härtesten arbeiten (und den meisten Sauerstoff aufnehmen), während wir Gedanken oder Emotionen haben.

In dieser Studie wurden insgesamt vier Teilnehmer eingesetzt, die jeweils einen Satz von 10.000 Bildern betrachteten.

Die KI beginnt mit der Generierung der Bilder als Rauschen ähnlich dem statischen Fernsehrauschen, das dann durch unterscheidbare Merkmale ersetzt wird, die der Algorithmus in der Aktivität sieht, indem er sich auf die Bilder bezieht, auf denen er trainiert wurde, und eine Übereinstimmung findet.

“Wir demonstrieren, dass unser einfacher Rahmen hochaufgelöste (512 x 512) Bilder aus Gehirnaktivitäten mit hoher semantischer Genauigkeit rekonstruieren kann”, heißt es in der Studie.

„Wir interpretieren jede Komponente eines LDM quantitativ aus neurowissenschaftlicher Sicht, indem wir bestimmte Komponenten bestimmten Gehirnregionen zuordnen.

Wir präsentieren eine objektive Interpretation, wie der Text-zu-Bild-Konvertierungsprozess von einem LDM implementiert wird [a latent diffusion model] enthält die durch den bedingten Text ausgedrückten semantischen Informationen, während gleichzeitig das Erscheinungsbild des ursprünglichen Bildes beibehalten wird.’

Den Teilnehmern wurde ein Bild gezeigt und die KI sammelte ihre Gehirnaktivität, die sie dann entschlüsselte und das Bild rekonstruierte

Der neue KI-gestützte Algorithmus rekonstruierte aus diesen Gehirnscans mit 80-prozentiger Genauigkeit rund 1.000 Bilder, darunter einen Teddybären und ein Flugzeug. Die obere Reihe zeigt die Originalbilder, die den Teilnehmern gezeigt werden, und die untere Reihe zeigt die KI-generierten Bilder

Eine andere „Gedankenlese“-Maschine ist in der Lage, die Gehirnaktivität zu entschlüsseln, während eine Person stillschweigend versucht, Wörter phonetisch zu buchstabieren, um ganze Sätze zu bilden

Die Kombination künstlicher Intelligenz mit Gehirnscannern war eine Aufgabe der wissenschaftlichen Gemeinschaft, die ihrer Meinung nach neue Schlüssel zur Erschließung unserer inneren Welten sind.

In einer Studie vom November nutzten Wissenschaftler die Technologien, um die Gehirnwellen von nicht verbalen, gelähmten Patienten zu analysieren und sie in Echtzeit auf einem Computerbildschirm in Sätze umzuwandeln.

Die „Gedankenlese“-Maschine kann die Gehirnaktivität entschlüsseln, während eine Person stillschweigend versucht, Wörter phonetisch zu buchstabieren, um vollständige Sätze zu bilden.

Forscher der University of California sagten, dass ihr Neuroprothesen-Sprachgerät das Potenzial hat, die Kommunikation mit Menschen wiederherzustellen, die aufgrund von Lähmungen nicht sprechen oder tippen können.

In Tests entschlüsselte das Gerät die Gehirnaktivität der Freiwilligen, während sie versuchten, jeden Buchstaben lautlos phonetisch zu sprechen, um Sätze aus einem Vokabular mit 1.152 Wörtern mit einer Geschwindigkeit von 29,4 Zeichen pro Minute und einer durchschnittlichen Zeichenfehlerrate von 6,13 Prozent zu bilden.

In weiteren Experimenten stellten die Autoren fest, dass sich der Ansatz auf große Vokabulare mit über 9.000 Wörtern verallgemeinern ließ, was einer durchschnittlichen Fehlerquote von 8,23 Prozent entspricht.