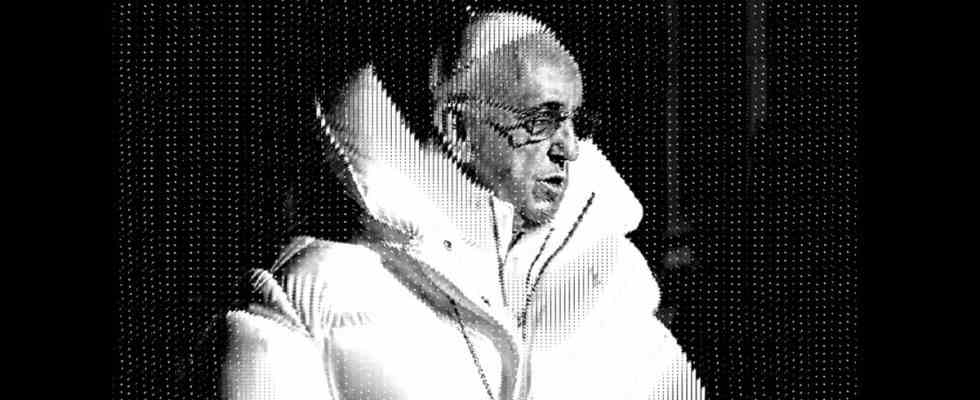

Im Jahr 2023 am Leben zu sein und im Internet zu sein, bedeutet plötzlich, hyperrealistische Bilder berühmter Menschen zu sehen, die seltsame, lustige, schockierende und möglicherweise verstörende Dinge tun, die nie wirklich passiert sind. Allein in der vergangenen Woche hat das KI-Kunsttool Midjourney zwei überzeugende, fotografische Bilder von Prominenten gerendert, die beide viral wurden. Letzte Woche stellte es sich Donald Trumps Verhaftung und eventuelle Flucht aus dem Gefängnis vor. Am Wochenende war Papst Franziskus in Midjourneys Schlund an der Reihe, als ein KI-generiertes Bild des Papstes in einer eleganten weißen Puffjacke auf Reddit explodierte und Twitter.

Aber die gefälschte Trump-Verhaftung und die Balenciaga-Darstellungen des Papstes haben einen bedeutenden Unterschied: Während die meisten Menschen den Bildern von Trump schnell keinen Glauben schenkten, täuschte der Kugelfisch des Papstes selbst die anspruchsvollsten Internet-Bewohner. Diese Unterscheidung verdeutlicht, wie synthetische Medien – die von manchen bereits als Fake-News-Bogeyman behandelt werden – unsere Wahrnehmung der Realität prägen werden und wie nicht.

Der coole Parka von Papst Franziskus täuschte versierte Zuschauer, weil er ein Nachrichtenereignis mit niedrigem Einsatz darstellte – die Art von Boulevard-ähnlicher Nicht-Nachrichtengeschichte, die, wenn sie echt wäre, letztendlich von populären Social-Media-Konten aggregiert würde Klatschnachrichten, vorher Vielleicht Viral gehen. Es ist ein kleines Stück Internet-Ephemera, wie die Fotos, die früher von Wladimir Putin ohne Hemd kursierten.

Als solches erfordert das Bild keine strenge Prüfung. Als ich das Bild in meinem Feed sah, habe ich es mir nicht allzu genau angesehen; Ich nahm entweder an, dass es echt und ein lustiges Beispiel für einen Prominenten war, der etwas Unerwartetes trug, oder dass es eine Fälschung und Teil eines Online-Witzes war, in den ich nicht eingeweiht war. Mein Instinkt war sicherlich nicht, das Foto nach Fehlern zu durchsuchen, die für KI-Tools typisch sind (ich habe zum Beispiel die glitzernden Hände des Papstes nicht bemerkt). Ich habe mit einer Reihe von Leuten gesprochen, die eine ähnliche Reaktion hatten. Sie ließen sich vorübergehend von dem Bild täuschen, beschrieben ihre Erfahrung mit der Fälschung jedoch in einem eher atmosphärischen Sinne – sie scrollten; sah das Bild und dachte, Oh wow, schau dir den Papst an; und bewegten sich dann zusammen mit ihrem Tag. Die Bilder der Trump-Verhaftung hingegen zeigten ein erwartetes Nachrichtenereignis, das, wäre es tatsächlich passiert, schwerwiegende politische und kulturelle Auswirkungen gehabt hätte. Man scrollt nicht einfach weiter, nachdem man gesehen hat, wie der ehemalige Präsident zu Boden gerissen wird.

Die beiden Bildersätze veranschaulichen also gut, wie viele Menschen beurteilen, ob Informationen wahr oder falsch sind. Wir alle verwenden verschiedene Heuristiken, um die Wahrheit herauszufinden. Wenn wir neue Informationen über etwas erhalten, worüber wir vorhandenes Wissen haben, greifen wir einfach auf Fakten zurück, die wir zuvor gelernt haben. Aber wenn wir unsicher sind, verlassen wir uns auf weniger konkrete Heuristiken wie Plausibilität (würde das passieren?) oder Stil (fühlt sich etwas authentisch an, sieht es aus oder liest es sich authentisch?). Im Fall der Trump-Verhaftung waren sowohl die Stil- als auch die Plausibilitätsheuristik ausgefallen.

„Wenn Trump öffentlich verhaftet wurde, frage ich mich, Warum sehe ich dieses Bild, aber die Trendthemen, Tweets und die nationalen Zeitungen und Netzwerke von Twitter spiegeln dies nicht wider??” Mike Caulfield, ein Forscher am Center for an Informed Public der University of Washington, erzählte es mir. „Aber für den Papst ist Ihre einzige verfügbare Heuristik, Würde der Papst einen coolen Mantel tragen? Da wir hier fast alle keine Expertise haben, greifen wir auf die Style-Heuristik zurück und kommen zu der Antwort, vielleicht.“

Wie ich letzte Woche schrieb, funktionieren sogenannte halluzinierte Bilder, die große Ereignisse darstellen, die nie stattgefunden haben, anders als Verschwörungstheorien, die ausgefeilt, manchmal vage und häufig schwer zu widerlegen sind. Caulfield, der Fehlinformationskampagnen rund um Wahlen erforscht, sagte mir, dass die effektivsten Versuche der Irreführung von Akteuren kommen, die solide Berichterstattung von traditionellen Nachrichtenagenturen nehmen und sie dann falsch interpretieren.

Angenommen, Sie versuchen, Empörung über eine Kommunalwahl zu schüren. Eine gute Möglichkeit, dies zu tun, wäre, eine gemeldete Nachricht über die Öffentlichkeitsarbeit von Wählern zu nehmen und fälschlicherweise auf böswillige Absichten in Bezug auf ein Detail in dem Artikel zu schließen. Ein weggeworfener Satz über eine Kampagne, die Wahlbriefe an Nichtbürger verschickt, kann zu einer viralen Verschwörungstheorie werden, wenn ein Propagandist behauptet, dass diese Mailer es waren Genau genommen Stimmzettel. Unter dem Vorwurf des Wahlbetrugs können die Verschwörer dann ein ganzes Universum von Unwahrheiten aufbauen. Sie könnten sich die Spendenunterlagen und politischen Beiträge des Außenministers ansehen und imaginäre Verbindungen zu George Soros oder anderen politischen Aktivisten erfinden, wodurch Intrigen und Anspielungen entstehen, wo es eigentlich keine Beweise für ein Fehlverhalten gibt. „All dies erzeugt das Gefühl einer dichten Realität, und das alles ist möglich, weil es im Zentrum ein Körnchen Realität gibt“, sagte Caulfield.

Damit synthetische Medien Menschen in High-Stakes-Nachrichtenumgebungen täuschen können, müssen die betreffenden Bilder oder Videos die genaue Berichterstattung über echte Nachrichtenereignisse in Frage stellen oder falsch darstellen. Das Erfinden von Szenarien aus dem ganzen Stoff erleichtert die Beweislast bis zu dem Punkt, dass selbst Gelegenheitsscroller sehr leicht die Wahrheit finden können. Das heißt aber nicht, dass KI-generierte Fälschungen harmlos sind. Caulfeld beschrieben in einem Tweet, wie große Sprachmodelle oder LLMs – die Technologie hinter Midjourney und ähnlichen Programmen – Meister darin sind, den Stil zu manipulieren, den Menschen dazu neigen, mit Autorität, Authentizität und Fachwissen in Verbindung zu bringen. „Das Internet hat Fakten und Wissen wirklich auseinandergenommen, LLMs könnten mit Stil ähnlich vorgehen“, schrieb er.

Stil, argumentiert er, war noch nie die wichtigste Heuristik, um Menschen bei der Bewertung von Informationen zu helfen, aber er ist immer noch ziemlich einflussreich. Wir verwenden Schreib- und Sprechstile, um die Vertrauenswürdigkeit von E-Mails, Artikeln, Reden und Vorträgen zu bewerten. Wir verwenden den visuellen Stil auch bei der Bewertung der Authentizität – denken Sie an Firmenlogos oder Online-Bilder von zum Verkauf stehenden Produkten. Es ist nicht schwer vorstellbar, dass das Überfluten des Internets mit kostengünstigen Informationen, die einen authentischen Stil nachahmen, unser Gehirn durcheinander bringen könnte, ähnlich wie die Demokratisierung des Publizierens durch das Internet den Prozess der einfachen Faktenfindung komplexer machte. Wie Caulfield bemerkt: „Je profaner die Sache, desto größer das Risiko.“

Da wir noch in den Kinderschuhen eines generativen KI-Zeitalters stecken, ist es zu verfrüht anzunehmen, dass wir kopfüber in die Tiefen einer postfaktischen Höllenlandschaft stürzen. Betrachten Sie diese Tools jedoch durch Caulfields Linse: Aufeinanderfolgende Technologien, vom frühen Internet über soziale Medien bis hin zu künstlicher Intelligenz, haben jeweils unterschiedliche Heuristiken der Informationsverarbeitung ins Visier genommen und sie nacheinander verbilligt. Der kumulative Effekt beschwört ein unheimliches Bild von Technologien herauf wie ein aufgewühltes Meer, das langsam an den notwendigen Werkzeugen nagt, die wir haben, um die Welt zu verstehen und widerstandsfähig zu bleiben. Eine langsame Erosion dessen, was uns menschlich macht.